基本信息

| 期刊 | CVPR |

|---|---|

| 年份 | 2023 |

| 论文地址 | https://arxiv.org/pdf/2303.09030.pdf |

| 代码地址 | https://github.com/zcablii/LSKNet |

标题

遥感目标检测的大选择核网络

目前存在的问题

相对较少的工作考虑到强大的先验知识存在于遥感图像。航空图像通常是用高分辨率的鸟瞰图拍摄的。特别是,航拍图像中的大多数物体可能体积较小,仅从它们的外观很难识别。相反,这些物体的成功识别往往依赖于它们的上下文,因为周围的环境可以提供关于它们的形状、方向和其他特征的有价值的线索。

- 遥感图像中目标的精确检测往往需要广泛的上下文信息。

- 不同对象类型所需的上下文信息的范围是非常不同的。

改进

大核卷积

卷积核大小和膨大率的增加保证了感受野的快速扩展。我们设置了膨胀率的上界,以保证膨胀卷积不会在特征图之间引入间隙。例如,我们可以将一个大的内核分解为2或3个深度卷积,如表2所示,它们的理论感受野分别为23和29。

优点:

- 它显式地生成多个具有各种大型接受域的特性,这使得以后的内核选择更加容易。

- 顺序分解比简单地应用单个更大的内核更有效。我们的分解比标准的大卷积核大大减少了参数的数量

空间核选择

在不同尺度上从大卷积核中空间选择特征映射

首先,我们将不同感受野范围的不同核的特征进行串联,然后采用基于通道的平均和最大池化方法有效地提取空间关系,将空间融合的特征进行串联,并使用卷积层将融合的特征(2通道)转换为N个空间注意图,对于每个空间注意图̂SAi,使用一个sigmoid激活函数,对分解后的每个大核分别获得单个空间选择掩码,将分解后的大核序列中的特征按其对应的空间选择掩模加权,再经卷积层融合得到注意特征S

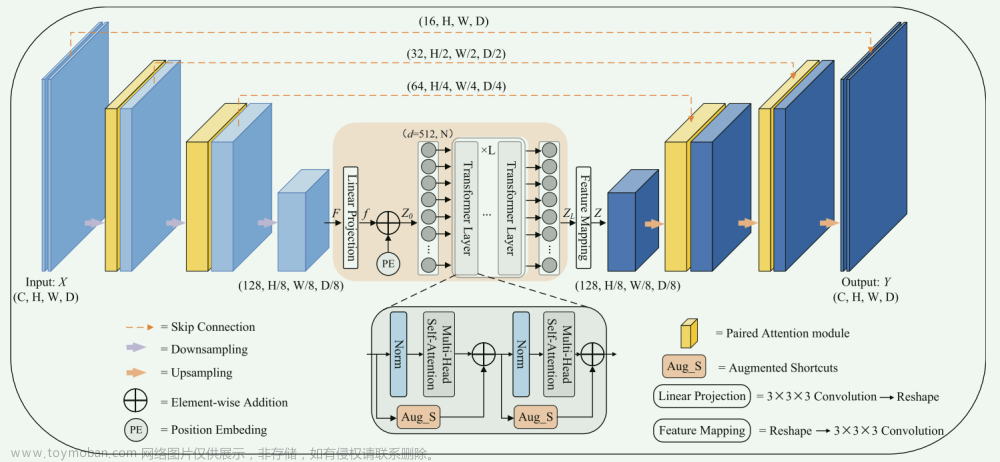

网络结构

文章来源:https://www.toymoban.com/news/detail-717371.html

文章来源:https://www.toymoban.com/news/detail-717371.html

另一个写的好的参考

网址文章来源地址https://www.toymoban.com/news/detail-717371.html

到了这里,关于论文阅读——Large Selective Kernel Network for Remote Sensing Object Detection的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]Coordinate Attention for Efficient Mobile Network Design](https://imgs.yssmx.com/Uploads/2024/02/732600-1.png)

![[论文阅读笔记] TRACE: A Comprehensive Benchmark for Continual Learning In Large Language Models](https://imgs.yssmx.com/Uploads/2024/01/801421-1.png)