Kafka数据同步原理详解

Kafka是一种分布式的消息队列系统,它具有高吞吐量、可扩展性和分布式特性等优势。在Kafka中,数据按照主题进行分区,每个主题都有一组分区。每个分区都有自己的生产者和消费者,生产者负责向分区中写入消息,消费者负责从分区中读取消息。因此,Kafka的数据同步主要涉及到生产者和消费者之间的数据传输以及副本同步。

分区同步

分区写入过程

当生产者向Kafka发送消息时,Kafka会将消息存储在本地的一个特殊的文件夹中,称为log文件夹。每个log文件夹中都会包含一个或多个分区的日志文件,每个日志文件对应一个分区。在写入消息时,Kafka会根据分区策略将消息分配到不同的分区中,然后按照写入的顺序将消息追加到对应的日志文件中。

分区读取过程

消费者从Kafka读取消息时,需要指定要读取的主题和分区。Kafka会将消费者的请求路由到对应的分区节点上,然后从该节点的log文件夹中读取指定分区的日志文件。消费者可以通过指定偏移量来控制从哪个位置开始读取,默认情况下会从上次读取的位置继续读取。

副本同步

Kafka的每个分区都有多个副本,这些副本可以分布在不同的节点上以提高系统的容错性和可扩展性。主副本负责处理该分区的所有写请求,而从副本则从主副本中复制数据并保证与主副本的数据一致性。

副本选举

如果主副本出现故障,则从副本会进行选举,选出一个新的主副本继续提供服务。这个过程是自动的,Kafka会检测主副本的状态,当主副本出现故障时,会选出一个从副本作为新的主副本。

数据复制

从副本会定期从主副本中复制数据并保证与主副本的数据一致性。Kafka使用了一种基于Raft协议的数据复制机制来实现数据复制和一致性保障。Raft协议是一种类似于Paxos协议的分布式一致性协议,它能够保证所有副本达成一致状态,从而避免了单点故障和脑裂问题。

在数据复制过程中,主副本将数据写入到本地磁盘上的一个特殊的文件夹中,称为“state store”。从副本会定期从主副本的state store中复制数据到一个本地文件夹中,这个文件夹称为“replica store”。当从副本成功将数据写入到replica store后,会向主副本发送一个确认消息,主副本收到确认消息后,会将该数据标记为已复制。

消息追加

Kafka的消息是追加写入的,这也就是说在消息被写入之后还可以继续追加新的消息。这个特性使得Kafka可以更容易地支持多个消费者并行地读取同一个分区的消息,同时也提高了系统的并发处理能力。

当生产者向分区中写入一条消息时,Kafka会将该消息追加到对应分区的log文件夹中的日志文件中。由于log文件夹中的日志文件是按照写入的顺序追加的,因此消费者在读取消息时也是按照写入的顺序依次读取的。

偏移量提交

消费者在读取消息时会记录一个偏移量(offset),这个偏移量标识了消费者当前读取到的位置。如果消费者出现故障,那么它下次可以继续从上次的偏移量处读取消息,避免了消息丢失和重复读取的问题。同时,Kafka还提供了偏移量提交机制,即消费者在每次读取一定数量的消息后都需要向Kafka提交当前偏移量,以避免消费者在故障恢复后重复读取已经消费过的消息。

偏移量提交的过程是自动的,消费者在读取消息时会记录当前的偏移量,当读取到一定数量的消息后,会向Kafka提交当前的偏移量。提交偏移量的过程是可靠的,即使消费者在提交偏移量之前出现故障,也可以通过查看提交的偏移量来确定消费者已经读取到的位置。

Java源码示例和分析

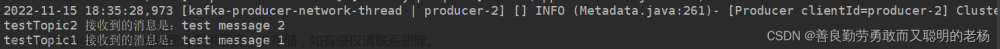

下面是一个简单的Java源码示例来说明Kafka的数据同步原理:

// 创建生产者producer对象,连接Kafka集群

Producer<String, String> producer = new KafkaProducer<>(props);

// 创建主题及分区

String topic = "test-topic";

int partition = 0; // 分区号

// 发送消息到指定分区

producer.send(new ProducerRecord<>(topic, partition, "test-message"));

在上述示例中,我们创建了一个Kafka生产者对象并使用它向指定的主题发送一条消息。这个生产者对象使用KafkaProducer类创建,它封装了与Kafka集群的通信。

当生产者发送消息时,它使用ProducerRecord类指定了要发送消息的主题、分区号和消息内容。这个消息将被追加到指定分区的日志文件中,并由Kafka集群负责将其存储在适当的节点上。

作为消费者,我们可以使用以下代码来读取这个分区中的消息:

// 创建消费者consumer对象,连接Kafka集群

Consumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅指定主题的分区

consumer.subscribe(Collections.singletonList(topic));

// 轮询消息

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100)); // 轮询消息

for (ConsumerRecord<String, String> record : records) { // 遍历每条消息

System.out.println(record.value()); // 输出消息内容

}

}

在这个示例中,我们创建了一个Kafka消费者对象并使用它订阅了指定的主题。这个消费者对象使用KafkaConsumer类创建,它封装了与Kafka集群的通信。

消费者通过调用subscribe()方法订阅指定的主题,然后通过调用poll()方法轮询消息。poll()方法将返回一个ConsumerRecords对象,其中包含了该消费者关注的分区中所有可用的消息。消费者可以遍历这个ConsumerRecords对象来处理每条消息。文章来源:https://www.toymoban.com/news/detail-717512.html

需要注意的是,Kafka的分区同步和副本同步都是由Kafka集群自动处理的。生产者和消费者只需要关注发送和接收消息即可,而不需要关心底层的同步过程。文章来源地址https://www.toymoban.com/news/detail-717512.html

到了这里,关于Kafka数据同步原理详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!