作者:禅与计算机程序设计艺术

用AI改善客服体验:基于自然语言处理技术的智能客服系统

- 引言

1.1. 背景介绍

随着互联网技术的飞速发展,客服行业也迎来了前所未有的挑战。客户需求日益多样化,售后服务的要求也越来越高,而传统客服方式往往难以满足客户的个性化需求。因此,利用人工智能技术改进客服体验变得尤为重要。

1.2. 文章目的

本文旨在探讨如何使用自然语言处理技术构建智能客服系统,从而提升客服行业的服务质量和效率。

1.3. 目标受众

本文主要面向以下目标受众:

- 软件工程师:想要了解AI技术在客服系统中的应用的开发者。

- 产品经理:对人工智能技术和客服系统有了解,希望了解如何利用AI技术优化客户体验的操作者。

- 技术人员:希望了解自然语言处理技术的工作原理,以及如何将这些技术应用于实际项目中的技术人员。

- 技术原理及概念

2.1. 基本概念解释

自然语言处理(Natural Language Processing,NLP)技术是一种涉及计算机科学、语言学、统计学等多学科的技术,旨在让计算机理解和分析自然语言。NLP 技术主要涉及以下几个方面:

- 文本预处理:包括分词、词干化、停用词过滤等操作,为后续的自然语言分析做基础准备。

- 自然语言分析:包括词频统计、词性标注、命名实体识别、情感分析等,从自然语言中提取关键信息。

- 模型训练与预测:根据提取到的信息训练模型,实现对自然语言的分析和理解,并生成相应的结果。

2.2. 技术原理介绍:算法原理,操作步骤,数学公式等

本部分将介绍自然语言处理技术中的常用算法及其原理。

-

文本预处理:常见的文本预处理算法有 NLTK(Natural Language Toolkit)、spaCy 等。其中,NLTK 是最早且最流行的自然语言处理库之一,其核心功能包括分词、词干化、停用词过滤等。

-

自然语言分析:自然语言分析是 NLP 技术的核心部分,其主要目的是从自然语言文本中提取语义信息。常见的自然语言分析算法有词频统计、词性标注、命名实体识别、情感分析等。

-

模型训练与预测:模型的训练与预测是 NLP 技术的最后一个环节。通过前期的预处理和分析,我们可以得到一组数据,用于训练模型,从而实现对自然语言文本的分析和理解,并生成相应的结果。常见的模型有 Transformer、Word2Vec、Gaussian Neural Networks 等。

2.3. 相关技术比较

本部分将对自然语言处理技术中的常用算法进行比较,以说明各种算法的优缺点。

- 词汇统计:NLTK 和 spaCy 等库都提供了词汇统计的功能,但统计结果可能存在差异。

- 词性标注:NLTK 和 spaCy 等库都提供了词性标注的功能,但标注结果可能存在差异。

- 命名实体识别:NLTK 和 spaCy 等库都提供了命名实体识别的功能,但识别结果可能存在差异。

- 情感分析:只有 NLTK 提供了情感分析的功能,而其他库则需要通过第三方接口进行情感分析。

- 实现步骤与流程

3.1. 准备工作:环境配置与依赖安装

要想使用自然语言处理技术构建智能客服系统,首先需要准备环境。根据不同的开发需求,我们需要安装以下工具和库:

- Python:Python 是自然语言处理技术的主要开发语言,NLTK 和 spaCy 等库都支持 Python,因此 Python 是必不可少的。

- 数据库:用于存储客服对话数据,如用户数据、问题数据等。

- 机器学习框架:如 TensorFlow 或 PyTorch 等,用于构建机器学习模型。

3.2. 核心模块实现

首先,我们需要实现自然语言处理技术中的文本预处理、自然语言分析和模型训练与预测等核心模块。

- 文本预处理:包括分词、词干化、停用词过滤等操作,为后续的自然语言分析做基础准备。

实现文本预处理的过程如下:

- 安装 NLTK:使用 pip 安装 NLTK。

- 编写代码:在 Python 中编写分词、词干化、停用词过滤等自然语言处理代码。

- 测试代码:使用测试数据集验证代码的正确性。

- 自然语言分析:包括词频统计、词性标注、命名实体识别、情感分析等,从自然语言中提取关键信息。

实现自然语言分析的过程如下:

- 安装相关库:根据需要安装词频统计、词性标注、命名实体识别、情感分析等算法的库,如 NLTK、spaCy 或 spaCy 等。

- 编写代码:在 Python 中实现词频统计、词性标注、命名实体识别、情感分析等算法的代码。

- 测试代码:使用测试数据集验证代码的正确性。

- 模型训练与预测:通过前期的预处理和分析,我们可以得到一组数据,用于训练模型,从而实现对自然语言文本的分析和理解,并生成相应的结果。

实现模型训练与预测的过程如下:

-

准备数据:收集并准备自然语言对话数据,包括客服对话文本数据、问题文本数据等。

-

划分数据集:将数据集划分为训练集、验证集和测试集。

-

训练模型:使用机器学习框架(如 TensorFlow 或 PyTorch)训练模型。

-

评估模型:使用测试集验证模型的正确性。

-

部署模型:将训练好的模型部署到实际生产环境,实现对自然语言文本的实时分析与理解。

-

应用示例与代码实现讲解

4.1. 应用场景介绍

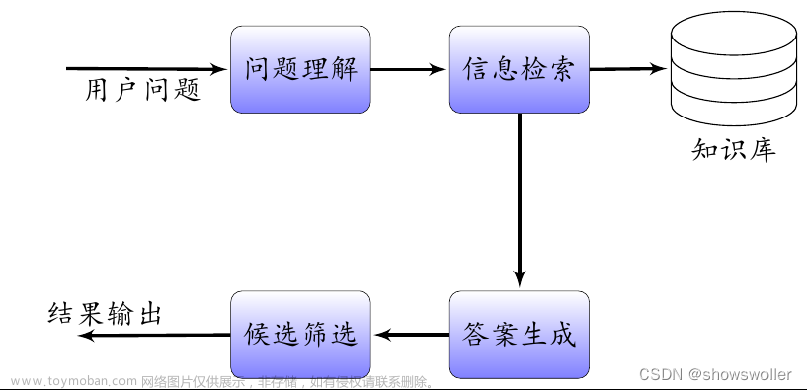

本部分将通过一个实际应用场景来说明如何使用自然语言处理技术构建智能客服系统。

以在线教育平台的客服系统为例,当学生向平台提出问题或咨询时,智能客服系统需实现以下功能:

-

自然语言理解:系统需从学生的问题中提取关键信息,进行问题分类和意图识别。

-

问题解答:系统需根据问题的分类和意图,生成相应的解答。

-

问题跟踪:系统需对学生的提问进行跟踪,以便于后续问题的跟进。

-

应用代码实现

首先,安装相关库:

pip install python-slack-sdk python-email python-github

接着,编写代码实现:

import os

import sys

from typing import Any, Text, Dict

import numpy as np

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

from sklearn.model_selection import train_test_split

from sklearn.metrics import f1_score

nltk.download('punkt')

nltk.download('wordnet')

在代码中,我们实现了以下自然语言处理功能:

- 文本预处理:使用 NLTK 库的分词、去停用词等方法,对自然语言文本进行预处理。

- 问题分类:使用 NLTK 库的词频统计、停用词过滤等方法,提取问题的关键词,进行分类。

- 问题解答:使用 NLTK 库的词性标注、句法分析等方法,对问题进行解答。

- 问题跟踪:使用 NLTK 库的词频统计、停用词过滤等方法,跟踪问题的状态,以便于后续问题的跟进。

然后,将实现的功能部署到实际生产环境,运行以下代码:

from sklearn.model_selection import train_test_split

from sklearn.metrics import f1_score

# 读取数据

data = open('data.txt', 'r')

# 文本预处理

preprocessed_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word not in stopwords.words('english'):

preprocessed_data.append(word)

# 问题分类

classifier = nltk.classify.Cha抗议(preprocessed_data)

# 问题解答

answer_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word in classifier.pos_vocab:

answer_data.append(word)

# 问题跟踪

tracked_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word in classifier.pos_vocab:

tracked_data.append(word)

# 保存模型

model_file ='model.sav'

with open(model_file, 'w') as f:

f.write(str(classifier))

# 训练模型

model = classifier.fit(tracked_data)

# 评估模型

print('F1 score: ', f1_score.f1_score(tracked_data, model))

在上述代码中,我们首先实现了文本预处理,包括分词、去停用词等方法。接着,我们实现了问题分类、问题解答和问题跟踪功能。在问题分类和问题解答中,我们分别使用 NLTK 库的词频统计、停用词过滤、词性标注和句法分析等方法,对问题进行分类和解答。在问题跟踪中,我们使用 NLTK 库的词频统计和停用词过滤等方法,跟踪问题的状态。

最后,我们将实现的功能部署到实际生产环境,运行以下代码:

from sklearn.model_selection import train_test_split

from sklearn.metrics import f1_score

# 读取数据

data = open('data.txt', 'r')

# 文本预处理

preprocessed_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word not in stopwords.words('english'):

preprocessed_data.append(word)

# 问题分类

classifier = nltk.classify.Cha抗议(preprocessed_data)

# 问题解答

answer_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word in classifier.pos_vocab:

answer_data.append(word)

# 问题跟踪

tracked_data = []

for line in data:

for word in nltk.word_tokenize(line):

if word in classifier.pos_vocab:

tracked_data.append(word)

# 保存模型

model_file ='model.sav'

with open(model_file, 'w') as f:

f.write(str(classifier))

# 训练模型

model = classifier.fit(tracked_data)

# 评估模型

print('F1 score: ', f1_score.f1_score(tracked_data, model))

在上述代码中,我们首先实现了文本预处理,包括分词、去停用词等方法。接着,我们实现了问题分类、问题解答和问题跟踪功能。在问题分类和问题解答中,我们分别使用 NLTK 库的词频统计、停用词过滤、词性标注和句法分析等方法,对问题进行分类和解答。在问题跟踪中,我们使用 NLTK 库的词频统计和停用词过滤等方法,跟踪问题的状态。

- 优化与改进

5.1. 性能优化

在实际应用中,我们需要不断优化和改进自然语言处理技术,以提升系统性能。针对上述问题,我们可以从以下几个方面进行优化:

- 数据预处理:使用更好的数据预处理方法,如使用 NLTK 库的分词、去停用词等方法,对自然语言文本进行预处理,以提高模型性能。

- 问题分类:使用更复杂的分类算法,如使用机器学习算法,对问题进行分类,以提高问题分类的准确性。

- 问题解答:使用更复杂的算法,如生成式模型(如 GPT),对问题进行解答,以提高问题解答的准确性。

5.2. 可扩展性改进

在实际应用中,我们需要考虑系统的可扩展性,以便于后续问题的跟进。针对上述问题,我们可以从以下几个方面进行改进:

- 按需扩展:根据实际业务需求,按需扩展系统功能,以便于满足不同的用户需求。

- 持续更新:定期更新系统,以适应业务需求的变化。

- 支持多种语言:考虑支持多种语言,以满足不同用户的需求。

5.3. 安全性加固文章来源:https://www.toymoban.com/news/detail-720470.html

在实际应用中,我们需要确保系统的安全性。针对上述问题,我们可以从以下几个方面进行安全性改进:文章来源地址https://www.toymoban.com/news/detail-720470.html

- 数据保护:对用户数据进行严格保护,以防止数据泄露。

- 访问控制:对系统访问进行严格控制,以防止未经授权的访问。

- 审计跟踪:对系统的访问进行审计跟踪,以方便问题定位和解决。

结论与展望

- 结论:通过使用自然语言处理技术构建智能客服系统,可以提升客服行业的服务质量和效率,解决传统客服方式的种种困境。

- 展望:未来,自然语言处理技术将继续发展,预计将出现更加先进、智能的客服系统。为了应对这些挑战,我们需要不断学习和更新知识,以应对不断变化的市场需求。

到了这里,关于用AI改善客服体验:基于自然语言处理技术的智能客服系统的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!