目录

说明

环境

GTOT测评工具箱使用

结构

准备工作

测评过程

生成ERRresults/xxx.mat

生成PR、SR曲线图

合成跟踪可视化视频

RGBT234测评工具箱使用

说明

结构

准备工作

测评过程

生成ERRresults_TIP/xxx.mat

生成PR、SR曲线图

合成跟踪可视化视频

说明

- 本篇博客是RGBT目标跟踪专题中的其中一篇:

Attribute-based Progressive Fusion Network for RGBT Tracking论文研读笔记

APFNet训练+测试复现过程记录

GTOT和RGBT234测评工具箱使用

环境

- 下载测评工具箱,链接:GitHub - mmic-lcl/Datasets-and-benchmark-code

- 将之前测试模型得到的结果复制过来,如果没有复现模型的训练和测试过程,也可以直接使用上面的链接中给出的Tracking Results进行测评

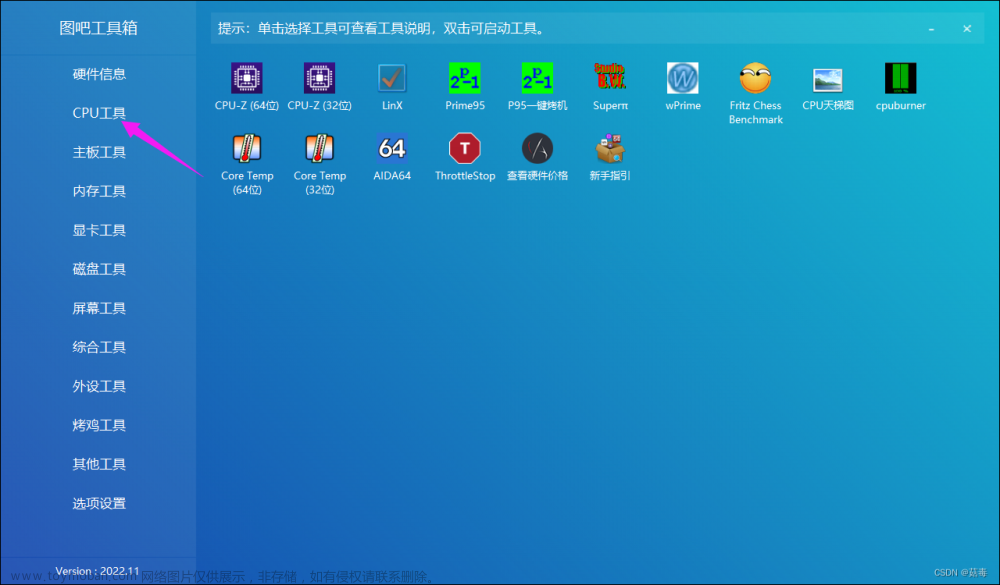

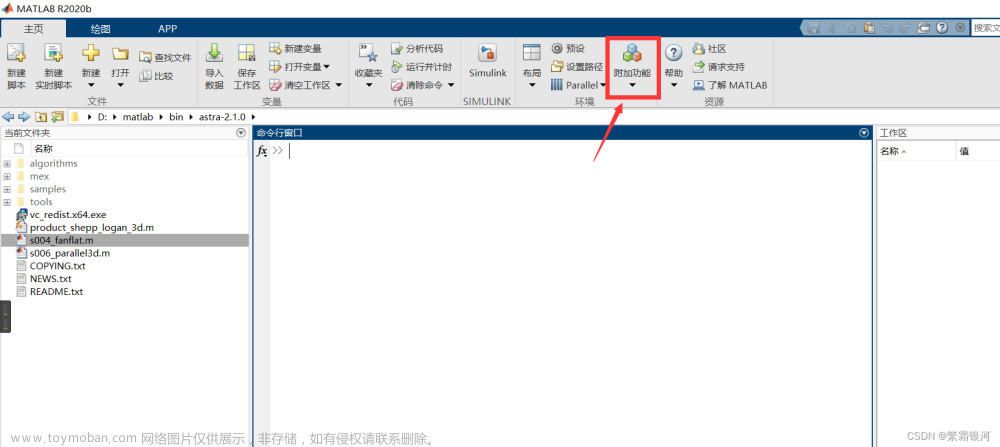

- 安装Matlab,用于绘制PR、SR图,以及生成跟踪结果图片

- Python3:额外的,用于生成测试展示视频

GTOT测评工具箱使用

结构

在GTOT 工具箱中,共有六个文件夹,其中, BBresults 文件夹中存放的是测试生成的目标跟踪框的 txt 文件,ERRresults 文件夹中的是计算生成的错误率文件,sequencesAttr 是工具箱中自带的关于 GTOT 数据集特性的一些文件,trackingResultsDisplay是存放带有跟踪框的结果图像的文件夹,GTOT_APFNet_tracking_result 文件夹存放的是使用RGBT234 数据集作为训练集,GTOT 作为测试集得到的测试跟踪结果(文件中每一行都含有八个数值,前四个和后四个分别代表在 RGB 图像和热红外图上的跟踪框四元数),my_video文件夹是自己建立的,用来存放合成视频的文件夹。

准备工作

在测评工具箱根目录下新建脚本cp_BBres_txts.py,用于将测试APF模型时生成的bbox框文件拷贝并重命名至 BBresults 与 ERRresults/APF 两个文件夹内

import os

input_path = './GTOT_APFNet_tracking_result/'

#output_path = './BBresults/'

output_path = './ERRresults/APF/'

for origin_txt in os.listdir(input_path):

os.system('cp ' + input_path + origin_txt + ' ' + output_path + 'APF_' + origin_txt)修改output_path两次,执行脚本两次

python cp_BBres_txts.py测评过程

生成ERRresults/xxx.mat

- 使用main_GenerateMat.m和calcPlotErr.m两个脚本,其中main_GenerateMat.m 脚本调用了 calcPlotErr.m 脚本,即main_GenerateMat.m 脚本是主程序。该步骤的输入输出分别为:

| input | ERRresults/APF/*.txt |

| output | ERRresults/APF/*.mat |

- 脚本中有一些参数需要修改:

(1)main_GenerateMat.m脚本中:basePath为GTOT数据集的位置,即"xxx/data/GTOT/";trackers为几个追踪算法的名字,这里设置为trackers={'APF'};

(2)calcPlotErr.m脚本中:basePath为GTOT数据集的位置;resultPath为跟踪框txt文件所在位置以及要输出的检测框mat文件所在位置,即resultPath='ERRresults/APF/'; 64行左右处也要改为'APF_',即:

results.res=dlmread([resultPath 'APF_' seq_name '.txt']); %seq_length*8- 运行main_GenerateMat.m 脚本之后,将在ERRresults/APF下得到相应的mat文件

生成PR、SR曲线图

- 使用main_drawResult.m脚本。脚本中有一些参数需要修改:algs为ERRresults文件夹下存有的算法的名字;basePath为GTOT数据集的位置。

%algs={'APF'}; % ours

algs={'APF', 'ADNet', 'MANet', 'DAPNet', 'DAFNet', 'MDNet', 'SGT', 'RT-MDNet+RGBT', 'MDNet+RGBT', 'MACNet'}; % overall

pixelThreshold=5;

basePath='xxx/dataset/GTOT/';- 该步骤的输入输出为:

| input | ERRresults/*.mat |

| output | PR、SR曲线图 |

如上图所示,在PR图中,横轴表示定位损失阈值,单位是像素,纵轴是精确率 PR,论文中说到过,对于 GTOT 数据集,阈值设置为 5 个像素,所以横轴等于 5 像素时,得到APFNet 在GTOT数据集上的精确率为 90.5%。各个 RGBT 目标跟踪算法相互对比,可知 APFNet算法在众多算法当中,性能较为优越。

在SR图中,横轴表示 overlap 阈值,即追踪框和 GT 框之间交并比的大小,纵轴表示成功率 SR。当阈值取 0.7 时,即当 overlap 大于 0.7 时表示成功追踪,APFNet 算法的 SR 为 73.7%。各个 RGBT 目标跟踪算法相互对比,可知 APFNet 算法在众多算法当中,性能较为优越。

合成跟踪可视化视频

- 使用main_drawTrackersResult.m脚本生成追踪结果图片。tracker为追踪算法的名字,basePath为GTOT数据集的位置;sequence为视频序列的名字;sequencePath为GTOT数据集的位置;同时需要注意的是展示出来的图片未全部填充整个窗口,所以需要修改大约80和104行的两处imshow代码使图片完全填充窗口,消除白边。

tracker={'APF'} %使用几种跟踪算法就会同时有几种追踪框

basePath='xxx/dataset/GTOT/';

dirs = dir(basePath);

sequences = {dirs.name};

sequences(strcmp('.', sequences) | strcmp('..', sequences) | strcmp('anno', sequences) | ~[dirs.isdir]) = [];

%sequence='Minibus1';

sequence='Football';

%for ni=8

% sequence=sequences{ni}

trackerResultsPath='BBresults/';

sequencePath='xxx/dataset/GTOT/';

saveBasePath='trackingResultsDisplay/';

%imshow(uint8(im));

imshow(uint8(im),'border','tight');- 更换sequence为GTOT数据集中不同的序列名称,可在trackingResultsDisplay/文件夹下得到不同视频序列在两个模态下的APFNet的跟踪框的可视化图片。

- 在项目根目录下新建my_video文件夹和gen_video.py脚本,gen_video.py用于将trackingResultsDisplay/文件夹下已有的所有序列合成视频,gen_video.py内容如下:

import cv2

import os

import linecache

DEBUG = 1

def gen_video(sequence_path, res_video_path, gt_path):

if not os.path.exists(res_video_path):

os.system('mkdir ' + res_video_path)

f = cv2.VideoWriter_fourcc('X', 'V', 'I', 'D') # 保存视频格式为avi

for sequence_name in os.listdir(sequence_path):

#save_sequence_path = os.path.join(res_video_path, sequence_name)

save_sequence_path = res_video_path + '/' + sequence_name

if DEBUG:

print(save_sequence_path)

if not os.path.exists(save_sequence_path):

os.makedirs(save_sequence_path)

test_frame_v = cv2.imread(os.path.join(sequence_path, sequence_name + '/v/1.jpg') )

video_writter_v = cv2.VideoWriter(os.path.join(save_sequence_path, sequence_name + '_v.avi'), f, 25, (test_frame_v.shape[1], test_frame_v.shape[0]))

test_frame_i = cv2.imread(os.path.join(sequence_path, sequence_name + '/i/1.jpg') )

video_writter_i = cv2.VideoWriter(os.path.join(save_sequence_path, sequence_name + '_i.avi'), f, 25, (test_frame_i.shape[1], test_frame_i.shape[0]))

for channel in ['v', 'i']:

video_path = os.path.join(sequence_path, sequence_name, channel)

label_path = os.path.join(gt_path, sequence_name)

#for frame_name in os.listdir(video_path): # 这样读取是乱序,视频跳帧

# frame = cv2.imread(os.path.join(video_path, frame_name))

for index in range(len(os.listdir(video_path))):

frame = cv2.imread(os.path.join( video_path, str(index+1) + '.jpg') )

if channel == 'v':

now_label = linecache.getline(os.path.join(label_path, 'groundTruth_v.txt'), index+1).strip() # 去掉换行符

else:

now_label = linecache.getline(os.path.join(label_path, 'groundTruth_i.txt'), index+1).strip() # 去掉换行符

ori_data_seq_vis_path = os.path.join(label_path, 'v')

ori_data_seq_vis_img_name = os.listdir(ori_data_seq_vis_path)[0]

ori_data_seq_vis_img = cv2.imread(os.path.join(ori_data_seq_vis_path, ori_data_seq_vis_img_name))

ratio_w = test_frame_v.shape[1] / ori_data_seq_vis_img.shape[1]

ratio_h = test_frame_v.shape[0] / ori_data_seq_vis_img.shape[0]

#print(now_label)

[x, y, x1, y1] = now_label.split(' ')

[x, y, x1, y1] = [int(x), int(y), int(x1), int(y1)]

cv2.rectangle(frame, ( int(x * ratio_w), int(y * ratio_h) ), ( int(x1 * ratio_w), int(y1 * ratio_h)), (255,255,255), 2)

if DEBUG:

cv2.imshow(sequence_name + '_' + channel, frame)

cv2.waitKey(20)

if channel == 'v':

video_writter_v.write(frame)

else:

video_writter_i.write(frame)

cv2.destroyAllWindows()

if __name__ == '__main__':

sequence_path = './trackingResultsDisplay'

res_video_path = './my_video'

gt_path = 'xxx/dataset/GTOT'

gen_video(sequence_path, res_video_path, gt_path)- 脚本中注意的是上一步保存的图片大小与原图大小不一致,所以脚本中有缩放操作,运行gen_video.py脚本之后,将在my_video下得到对应序列名称的所有视频,其中白色框为gt框,红色框为APFNet算法的跟踪框。

RGBT234测评工具箱使用

说明

- 大体流程与GTOT一致,细节有所不同

- 参数设置不同

- 脚本编写略微差异

结构

在RGBT234测评工具箱中,共有七个文件夹,其中, BBresults_TIP 文件夹中存放的是测试生成的目标跟踪框的 txt 文件,ERRresults_TIP 文件夹中的是计算生成的错误率文件,figsResults_TIP文件夹中的是不同属性下的PR、SR曲线评测图,sequencesAttr 是工具箱中自带的关于 RGBT234 数据集特性的一些文件,trackingResultsDisplay是存放带有跟踪框的结果图像的文件夹,RGBT234_APFNet_tracking_result 文件夹存放的是使用GTOT数据集作为训练集, RGBT234作为测试集得到的测试跟踪结果(文件中每一行都含有八个数值,前四个和后四个分别代表在 RGB 图像和热红外图上的跟踪框四元数),my_video文件夹是自己建立的,用来存放合成视频的文件夹。

准备工作

在测评工具箱根目录下新建脚本cp_BBres_txts.py,用于将测试APF模型时生成的bbox框文件拷贝并重命名至 BBresults_TIP 与 ERRresults_TIP/APF 两个文件夹内,需要注意的是RGBT234数据集解压后可能自带有一个rgbt234.txt文件,需要将其删除。

import os

input_path = './RGBT234_APFNet_tracking_result/'

output_path = './BBresults_TIP/'

#output_path = './ERRresults_TIP/APF/'

for origin_txt in os.listdir(input_path):

os.system('cp ' + input_path + origin_txt + ' ' + output_path + 'APF_' + origin_txt)修改output_path两次,执行脚本两次

python cp_BBres_txts.py测评过程

生成ERRresults_TIP/xxx.mat

- 使用main_GenerateMat_TPR.m和calcPlotErr_TPR.m两个脚本,其中main_GenerateMat_TPR.m 脚本调用了calcPlotErr_TPR.m脚本,即main_GenerateMat_TPR.m脚本是主程序。该步骤的输入输出分别为:

| input | ERRresults_TIP/APF/*.txt |

| output | ERRresults_TIP/APF/*.mat |

- 脚本中有一些参数需要修改:

(1)main_GenerateMat_TPR.m脚本中:basePath为GTOT数据集的位置,即"xxx/data/RGBT234/";trackers为几个追踪算法的名字,这里设置为trackers={'APF'};

(2)calcPlotErr_TPR.m脚本中:basePath为RGBT234数据集的位置;resultPath为跟踪框txt文件所在位置以及要输出的检测框mat文件所在位置,即resultPath='ERRresults_TIP/APF/'; 需要提前建好APF文件夹;73行左右处也要改为'APF_',即:

results.res=dlmread([resultPath 'APF_' seq_name '.txt']); %seq_length*8- 运行main_GenerateMat_TPR.m脚本之后,将在ERRresults_TIP/APF下得到相应的mat文件

生成PR、SR曲线图

- 使用main_drawResult_TPR.m脚本。脚本中有一些参数需要修改:algs为ERRresults_TIP文件夹下存有的算法的名字;basePath为RGBT234数据集的位置。

%algs={'APF'}; % ours

algs={'APF', 'CFnet+RGBT', 'MDNet+RGBT', 'DAFNet', 'KCF+RGBT', 'DAPNet', 'DAT', 'ECO', 'SGT', 'SiamDW+RGBT'}; % overall

pixelThreshold=20;

basePath='xxx/dataset/RGBT234/';- 该步骤的输入输出为:

| input | ERRresults_TIP/*.mat |

| output | PR、SR曲线图 |

如上图所示,在PR图中,横轴表示定位损失阈值,单位是像素,纵轴是精确率 PR,论文中说到过,对于RGBT234数据集,阈值设置为20个像素,所以横轴等于20像素时,得到APFNet 在RGBT234数据集上的精确率为 82.7%。各个 RGBT 目标跟踪算法相互对比,可知 APFNet算法在众多算法当中,性能较为优越。文章来源:https://www.toymoban.com/news/detail-721638.html

在SR图中,横轴表示 overlap 阈值,即追踪框和 GT 框之间交并比的大小,纵轴表示成功率 SR。当阈值取 0.7 时,即当 overlap 大于 0.7 时表示成功追踪,APFNet 算法的 SR 为 57.9%。各个 RGBT 目标跟踪算法相互对比,可知 APFNet 算法在众多算法当中,性能较为优越。文章来源地址https://www.toymoban.com/news/detail-721638.html

合成跟踪可视化视频

- 使用main_drawTrackersResult_APF.m脚本生成追踪结果图片。该脚本复制于main_drawTrackersResult_PaGLe.m。其中,tracker为追踪算法的名字,basePath为RGBT234数据集的位置;sequencePath为RGBT234数据集的位置;trackerResultsPath为追踪结果框txt文件所在路径;saveBasePath为连续帧图片保存路径;大约28行的ni为选择某一个序列的序号,也可以直接对sequence赋值决定某一个视频序列。同时需要注意的是展示出来的图片未全部填充整个窗口,所以需要修改大约80和104行的两处imshow代码使图片完全填充窗口,消除白边。

basePath='xxx/dataset/RGB_T234/';

trackerResultsPath='BBresults_TIP/';

sequencePath='xxx/dataset/RGB_T234/';

saveBasePath='trackingResultsDisplay/';

if(isdir(saveBasePath)==0),

mkdir(saveBasePath);

end

tracker={'APF'};

%tracker={'PaGLe','CSR','DSST','HCF','JSR','KCF','L1-PF','MDNet','SGT','SOWP','Staple'};%,'STRUCK','CN','CT','MIL','SCM'};

%all videos, call self with each video name.

%only keep valid directory names

dirs = dir(basePath);

sequences = {dirs.name};

sequences(strcmp('.', sequences) | strcmp('..', sequences) | strcmp('anno', sequences) | ~[dirs.isdir]) = [];

edgeColor={'r','g','b','y','k','m','c','g','b','y','r'};

lineStyle={'-','-','-','-','--','--','--','--','--','--','--'};

% for ni=100:numel(sequences)

for ni=120:120 % 选择第120个文件夹,即manwithluggage

% sequence='walkingtogether1';

sequence=sequences{ni};

%imshow(uint8(im));

imshow(uint8(im),'border','tight');- 更换sequence为RGBT234数据集中不同的序列名称,可在trackingResultsDisplay/文件夹下得到不同视频序列在两个模态下的APFNet的跟踪框的可视化图片。

- 在项目根目录下新建my_video文件夹和gen_video.py脚本,gen_video.py用于将trackingResultsDisplay/文件夹下已有的所有序列合成视频。

- 脚本中注意的是上一步保存的图片大小与原图大小不一致,所以脚本中有缩放操作,运行gen_video.py脚本之后,将在my_video下得到对应序列名称的所有视频,其中白色框为gt框,红色框为APFNet算法的跟踪框。

到了这里,关于GTOT和RGBT234测评工具箱使用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!