一、安装hadoop

1. 将hadoop-3.1.3.tar.gz复制到虚拟机/opt/software目录下:

2.在/opt/software目录下使用tar命令解压hadoop-3.1.3.tar.gz到/opt/module目录下:

tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/执行结果如下:

3.在/opt/module目录下修改文件夹名称:

mv hadoop-3.1.3/ hadoop

执行结果如下:

4.打开环境变量:

vim /etc/profile执行结果如下:

5.将光标移至文件底部,按“i”键编辑并作出如下配置:

#hadoop

export HADOOP_HOME=/opt/module/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

6.按esc键退出编辑,并输入冒号“:wq” ,回车保存退出:

7.将profile文件重新运行:

source /etc/profile8. 运行hadoop version检验安装结果:

hadoop version执行结果如下:

hadoop安装成功!

二、前期准备

1.关闭防火墙:

查看防火墙状态:

systemctl status firewalld.service关闭防火墙:

systemctl stop firewalld.service永久关闭防火墙:

systemctl disable firewalld.service再次查看防火墙状态:

systemctl status firewalld.service执行结果如下:

2.设置免密登录:

ssh-keygen -t rsa -P ''ssh-copy-id localhostssh localhostexit执行结果如下:

3.启用RSA认证:

vim /etc/ssh/sshd_config添加如下配置:

RSAAuthentication yes # 启用 RSA 认证

PubkeyAuthentication yes # 启用公钥私钥配对认证方式

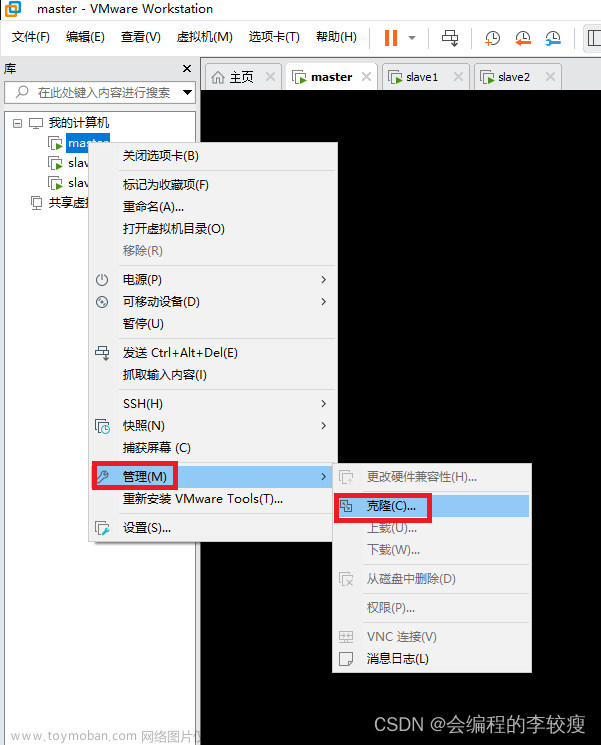

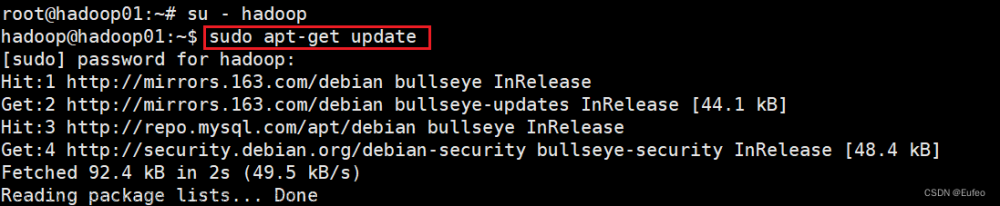

AuthorizedKeysFile %h/.ssh/authorized_keys # 公钥文件路径4.虚拟机关机,克隆虚拟机创建bigdata02、bigdata03节点:

同样的方式创建bigdata03节点这里不再进行演示。

5.开机,三个节点修改主机名:

vim /etc/hostname修改完成后需要重启虚拟机。

6.三个节点设置静态ip(之前博客有发这里不再进行演示)。

7.三个节点设置ip映射:

vim /etc/hosts在文件底部作出如下配置:

8.三个节点都测试⼀下配置是否成功:

ssh bigdata01

ssh bigdata02ssh bigdata03执行结果如下:

准备完毕!

三、配置hadoop完全分布式

1.在/opt/module/hadoop/etc/hadoop/目录下,编辑hadoop-env.sh、yarn-env.sh、mapred-env.sh文件:

vim hadoop-env.shvim yarn-env.shvim mapred-env.sh均添加如下配置:

export JAVA_HOME=/opt/module/jdk2.在/opt/module/hadoop/etc/hadoop/目录下,编辑core-site.xml文件:

vim core-site.xml在<configuration>下添加如下配置:

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop/dfs/tmp/</value>

</property>3.在/opt/module/hadoop/etc/hadoop/目录下,编辑hdfs-site.xml文件:

vim hdfs-site.xml在<configuration>下添加如下配置:

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/opt/module/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/opt/module/hadoop/dfs/data</value>

</property>4.在/opt/module/hadoop/etc/hadoop/目录下,编辑yarn-site.xml文件:

vim yarn-site.xml在<configuration>下添加如下配置:

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>bigdata01</value>

</property>

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>5.在/opt/module/hadoop/etc/hadoop/目录下,编辑mapred-site.xml文件:

vim mapred-site.xml在<configuration>下添加如下配置:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=/opt/module/hadoop</value>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=/opt/module/hadoop</value>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=/opt/module/hadoop</value>

</property>6.在/opt/module/hadoop/etc/hadoop/目录下,编辑works:

vim workers删除原配置,添加如下配置:

bigdata01

bigdata02

bigdata03

7.在/etc/profile下配置hadoop的HDSF和YARN⽤户:

vim /etc/profile在文件底部添加如下配置:

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root8.source使配置⽂件⽣效:

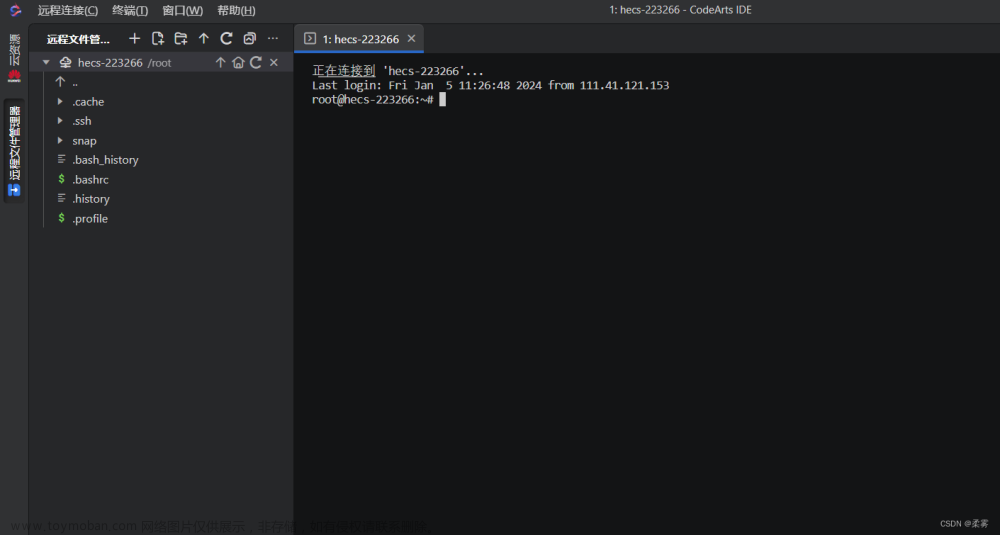

source /etc/profile9.将hadoop和将/etc/profile拷⻉到bigdata02和bigdata03:

scp -r /opt/module/hadoop/ @bigdata02:/opt/module/scp -r /opt/module/hadoop/ @bigdata03:/opt/module/scp -r /etc/profile @bigdata02:/etc/scp -r /etc/profile @bigdata03:/etc/10.格式化namenode:

hdfs namenode -format执行结果如下:

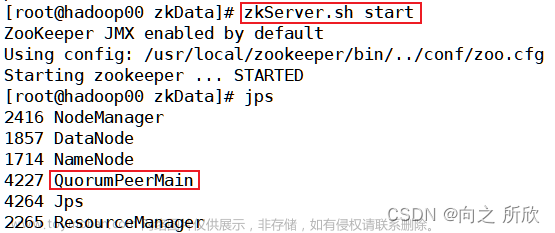

11.启动hadoop集群:

start-all.sh执行结果如下:

12.查看jps进程:

jpsbigdata01:

bigdata02:

bigdata03:

文章来源:https://www.toymoban.com/news/detail-721683.html

文章来源:https://www.toymoban.com/news/detail-721683.html

hadoop完全分布式配置完毕!文章来源地址https://www.toymoban.com/news/detail-721683.html

到了这里,关于Hadoop3.1.3完全分布式安装配置的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!