2022年10月份接到一个小功能,对接kafka将数据写到数据库,开始的需求就是无脑批量insert,随着时间的推移,业务需求有变更,kafka的生产消息频次越来越高,到今年7月份为止就每秒会有几十条甚至上百条,然后消费消息的代码就报错:

Caused by: org.apache.kafka.clients.consumer.CommitFailedException: Offset commit cannot be completed since the consumer is not part of an active group for auto partition assignment; it is likely that the consumer was kicked out of the group.

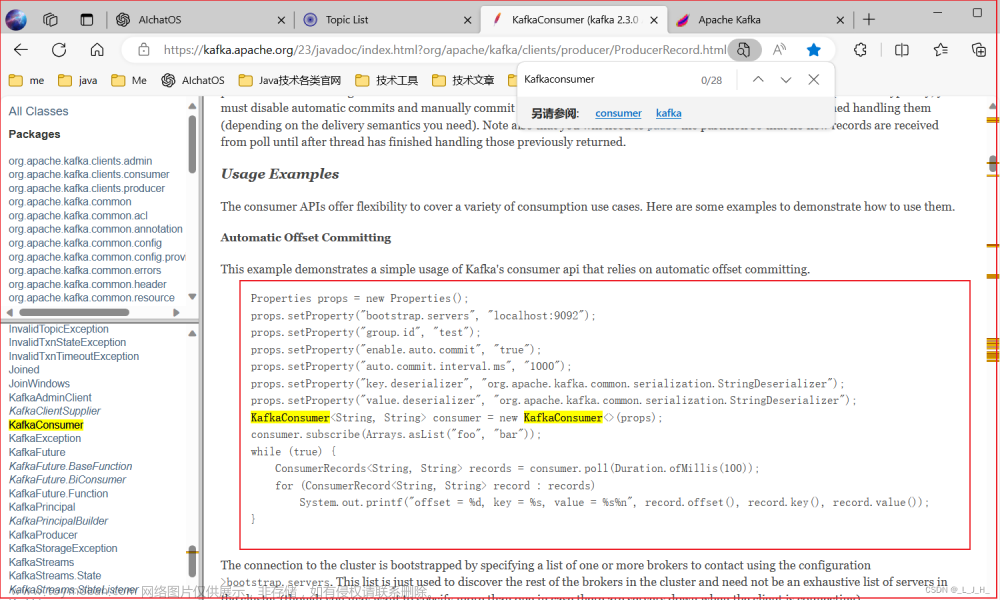

刚开始就在网上查询相关信息的解决办法,有的是让修改max-poll-records这个参数,网上查到的信息是,这个参数主要是消费者每次获取数据的大小,好像是这么解释的,我修改完之后,发现还是报错,报同样的错,因此我就去反查代码,也没有什么问题。这个问题持续了一段时间,每次都是重启应用来解决问题。

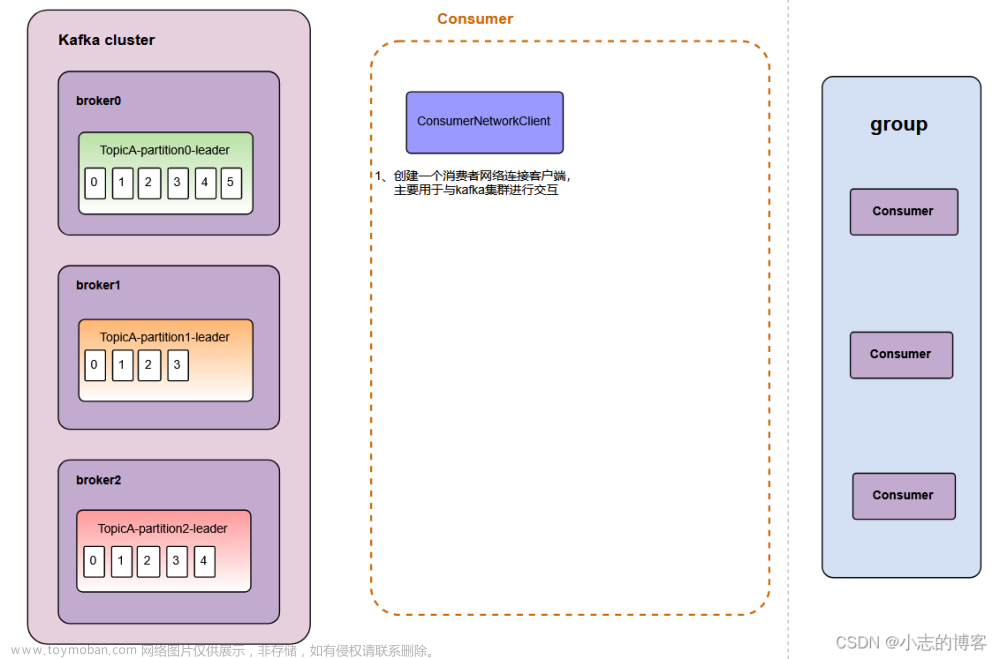

后来被逼无奈,只能痛下决心来解决这个问题,于是我就在网上查询,出现这个错误的原因,最后大概定位到:是因为消费程序的处理能力太慢。于是我就重新梳理了一下数据消费成后的后续业务逻辑,发现有一步批量更新可以不需要,于是就把批量更新的操作去掉了,让消费消息的逻辑又变得简单了,后来就没有出现这个问题了。于是总结了一下,出现这个问题的大数据原因可能是因为我们消费者的代码逻辑牵扯太多或者业务逻辑太负责,导致速度很慢,从而导致消费者与服务器之间发生超时的问题。文章来源:https://www.toymoban.com/news/detail-722187.html

后续如果再出现对接kafka,我会选择通过多线程操作,或者将kafka消费消息与业务逻辑进行异步处理,不要同步实现。文章来源地址https://www.toymoban.com/news/detail-722187.html

到了这里,关于kafka消费者报错Offset commit ......it is likely that the consumer was kicked out of the group的解决的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!