问题描述:在使用Kafka时,当我们向新的消费者组中添加消费者时,可能会遇到重复消费的问题。本文将介绍一些解决这个问题的方法,帮助开发者更好地处理Kafka中的消费者组和消费偏移量。

Kafka是一个强大的分布式消息队列系统,但在使用过程中,我们可能会遇到向新的消费者组中添加消费者导致重复消费的问题。这是因为Kafka中的消费者组通过消费者偏移量来跟踪它们在主题分区中的消费位置。当我们添加一个新的消费者组时,它会从主题的起始位置开始消费消息,而不考虑之前已经被其他消费者组消费过的消息。

为了解决这个问题,我们可以采取以下方法:

-

使用唯一的消费者组ID:

确保每个消费者组都有一个唯一的消费者组ID,这样它们之间不会相互干扰。如果我们使用相同的消费者组ID,Kafka会将新的消费者组视为已经存在的消费者组的一部分,并从之前的消费偏移量位置开始消费。 -

使用Kafka的消费者组协调器:

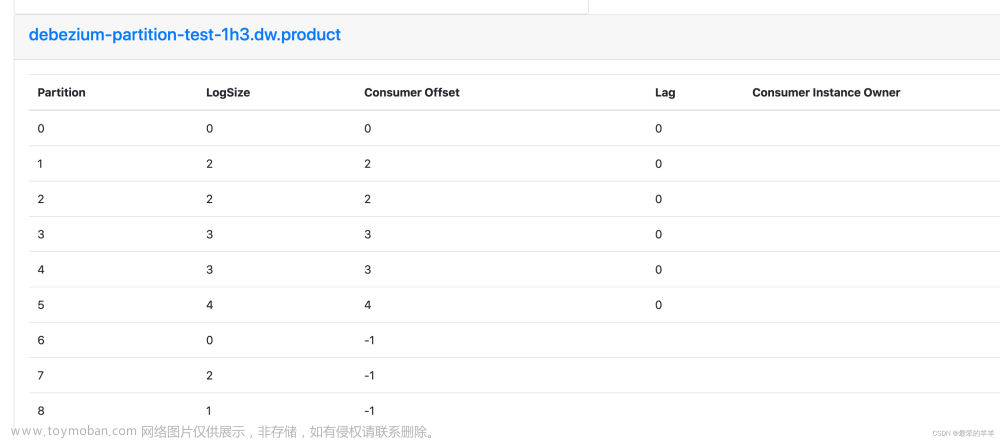

Kafka的消费者组协调器负责跟踪每个消费者组的消费偏移量,并确保每个消费者组都消费不同的消息。它会为新加入的消费者组分配新的分区,避免重复消费的问题。 -

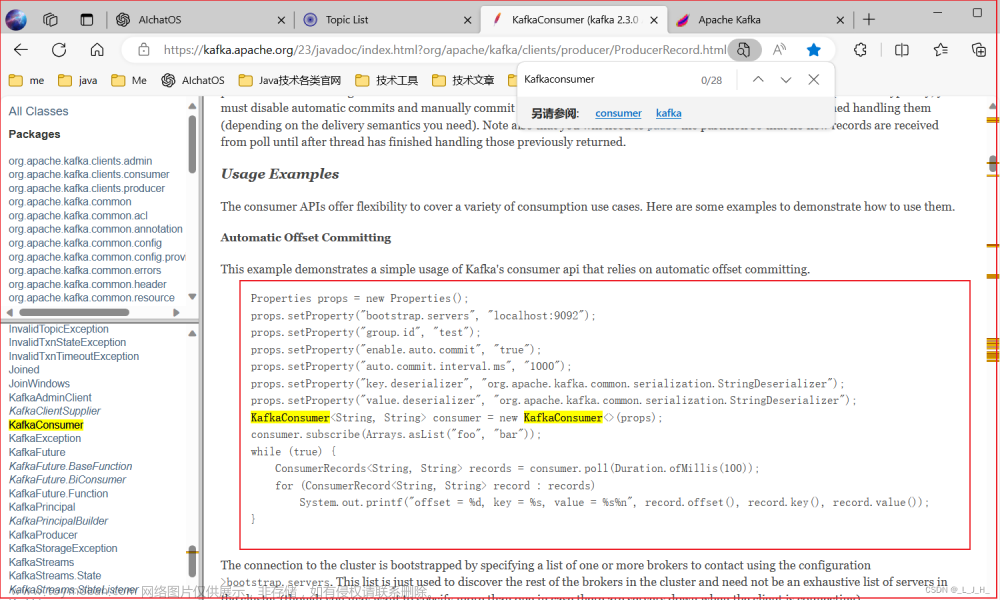

手动管理消费者偏移量:

我们可以选择手动管理消费者偏移量,而不是使用Kafka的自动偏移量管理机制。通过手动管理,我们可以更加精确地控制消费者从哪个偏移量开始消费消息,避免重复消费。

在实际应用中,我们可以根据具体的需求和场景选择适合的方法来解决重复消费的问题。无论是使用唯一的消费者组ID、利用Kafka的消费者组协调器,还是手动管理消费者偏移量,都需要根据团队的实际情况来进行选择和配置。

总结:

Kafka是一个强大的消息队列系统,但在使用过程中,我们需要注意新消费者组导致的重复消费问题。通过使用唯一的消费者组ID、利用Kafka的消费者组协调器或手动管理消费者偏移量,我们可以避免重复消费并确保消息的正常处理。在使用Kafka时,合理配置和管理消费者组是保证消息处理正确性的重要环节。文章来源:https://www.toymoban.com/news/detail-722796.html

希望本文能够帮助开发者更好地理解和解决Kafka新消费者组导致的重复消费问题,提升Kafka的使用效果和可靠性。文章来源地址https://www.toymoban.com/news/detail-722796.html

到了这里,关于解决Kafka新消费者组导致重复消费的问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!