在大数据领域,Merge、Combine和Aggregate这三个词通常描述数据处理过程中的不同操作。下面我们分别了解一下这三个概念:

-

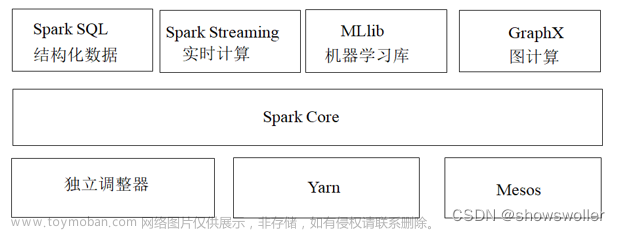

Merge(合并): 合并是指将两个或多个数据集按照某种规则(例如,基于共享的键)组合成一个数据集。在大数据领域,这通常涉及到将不同来源或分布式存储的数据整合在一起。例如,Spark和Hadoop中的Join操作就是一种典型的合并操作。Merge操作有多种类型,例如Inner Join、Left Join、Right Join和Full Outer Join。

-

Combine(组合): 在大数据处理中,组合通常是指在数据分区和处理过程中,将相同键的数据整合在一起。组合的主要目的是减少数据在网络中传输的开销,从而提高处理性能。例如,在MapReduce、Spark等大数据框架中,Shuffle过程中的Combiner可以将同一个节点上的中间结果组合起来,以减少数据在网络中的传输。Combiner操作通常用于那些满足结合律和交换律的操作,例如计数、求和、最大值和最小值等。

-

Aggregate(聚合): 聚合是指将一组数据通过某种操作(例如,求和、计数、平均、最大值、最小值等)汇总成一个值。在大数据处理中,聚合操作通常用于从大量数据中提取有价值的信息。例如,在SQL查询中的GROUP BY子句,以及Spark、Hadoop等大数据框架中的Reduce操作,都涉及到对数据进行聚合。文章来源:https://www.toymoban.com/news/detail-723406.html

总之,在大数据领域,Merge、Combine和Aggregate这三个词描述了数据处理过程中的不同操作,它们分别关注数据的整合、在分区中的优化和汇总。理解这些概念有助于更好地设计和优化大数据处理流程。文章来源地址https://www.toymoban.com/news/detail-723406.html

到了这里,关于大数据领域如何理解 Merge、Combine和Aggregate的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!