随着互联网的发展,数据爬取成为了获取信息的重要手段。本文将以豆瓣网为案例,通过技术问答的方式,介绍如何使用Node.js在Python中实现数据爬取,并提供详细的实现代码过程。

Node.js是一个基于Chrome V8引擎的JavaScript运行时环境,它提供了一种在服务器端运行JavaScript代码的能力。Python是一种高级编程语言,具有简洁易读的语法和丰富的生态系统。将Node.js与Python结合使用,可以发挥两者的优势,实现更强大的功能。

我们的目标是爬取豆瓣网的数据,因此需要找到豆瓣网的数据源和相应的接口。同时,我们还需要分析返回的数据格式和豆瓣网可能采取的反爬机制。最后,我们将使用Node.js和axios库来实现数据爬取,并提供完整的代码示例,详细过程如下:

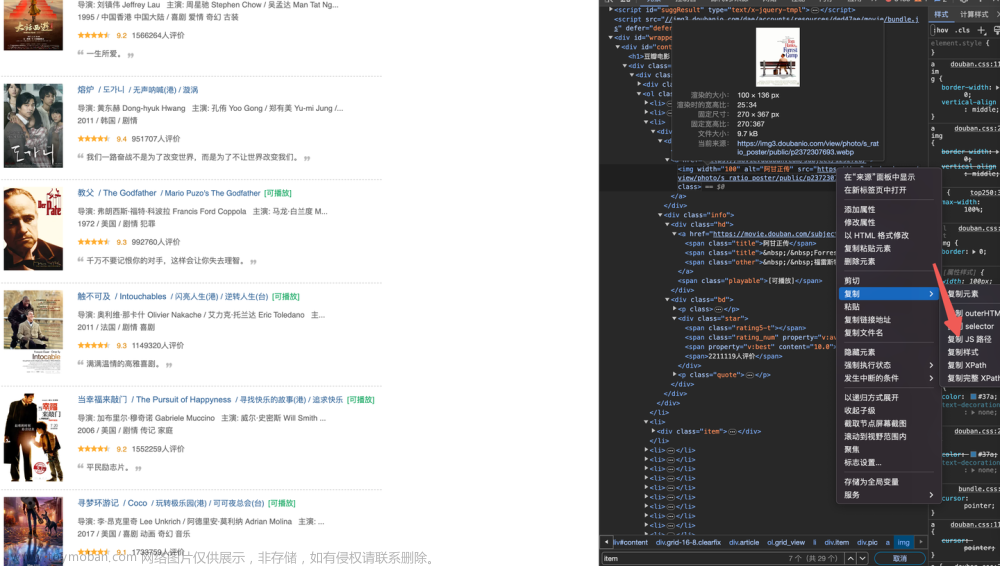

1 找到数据源:我们可以通过访问豆瓣网的官方网站https://www.douban.com/

2 找到接口:在豆瓣网的官方网站上,我们可以找到相应的API接口,这些接口可以用于获取豆瓣网的数据。通过分析接口文档,可以确定需要发送的HTTP请求的URL和参数。

3 分析返回格式:在发送HTTP请求后,豆瓣网会返回相应的数据。我们需要分析返回的数据格式,以便后续的数据处理和分析。通常,豆瓣网返回的数据会以JSON格式进行组织。

4 分析反爬机制:为了保护数据的安全和防止恶意爬取,豆瓣网可能会采取一些反爬机制,例如限制频率、验证码验证等。我们需要分析这些反爬机制,并相应地调整我们的爬取策略。

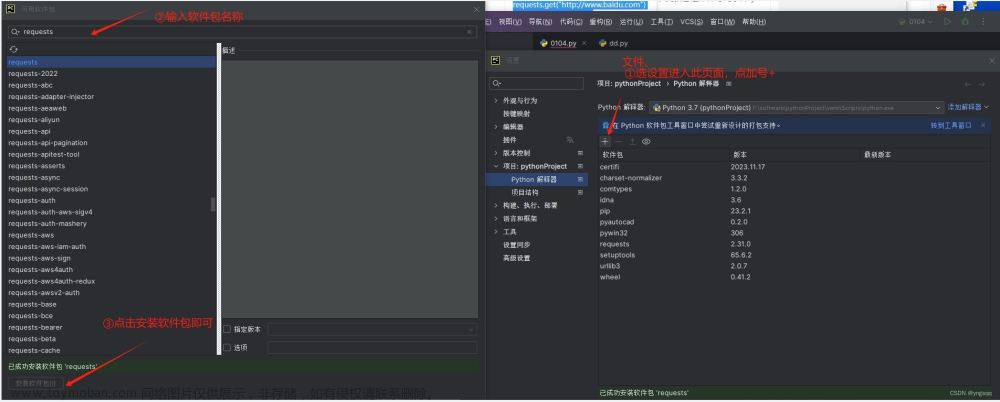

5 实现数据抓取: 在Python中,我们可以使用第三方库如Requests或Scrapy来发送HTTP请求,并解析返回的数据。通过调用豆瓣网的API接口,我们可以获取到需要的数据。

6 实现完整代码: 下面是使用Node.js和Python实现数据抓取的代码示例:文章来源:https://www.toymoban.com/news/detail-723466.html

const axios = require('axios');

const proxyHost = "www.16yun.cn";

const proxyPort = "5445";

const proxyUser = "16QMSOML";

const proxyPass = "280651";

const proxyConfig = {

host: proxyHost,

port: proxyPort,

auth: {

username: proxyUser,

password: proxyPass

}

};

axios.get('https://www.douban.com/', { proxy: proxyConfig })

.then(response => {

const data = response.data;

// 在这里对返回的数据进行处理和分析

console.log(data);

})

.catch(error => {

console.error(error);

});

在实际的数据抓取过程中,可能会遇到各种异常情况,例如请求超时、连接错误等。为了保证程序的稳定性,我们需要适当地处理这些异常情况,并进行错误日志记录或重新试操作。文章来源地址https://www.toymoban.com/news/detail-723466.html

到了这里,关于Node.js在Python中的应用实例解析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!