1. 初识 ElasticSearch

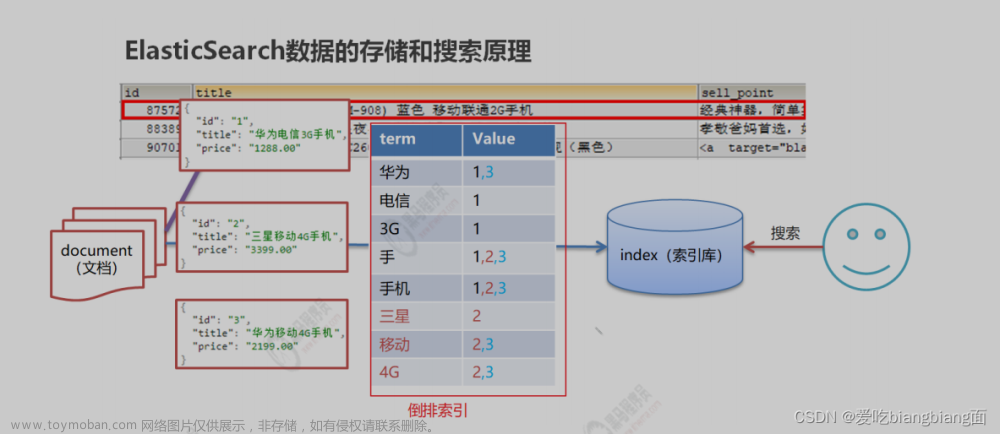

index(索引) :相当于 mysql的表映射:相当于 mysql 的表结构document(文档 ) :相当于 mysql的表中的数据

ES概念详解

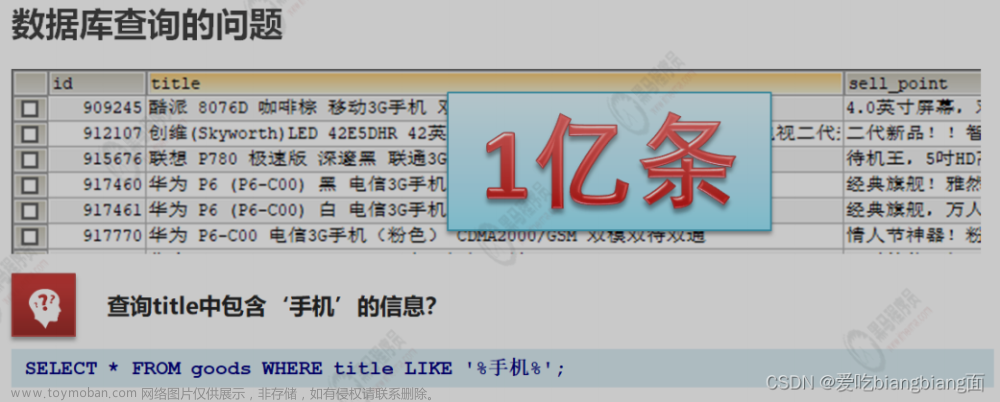

•ElasticSearch 是一个基于 Lucene 的搜索服务器• 是一个分布式、高扩展、高实时的搜索与数据分析引擎• 基于 RESTful web 接口•Elasticsearch 是用 Java 语言开发的,并作为 Apache 许可条款下的开放源码发布,是一种流 行的企业级搜索引擎• 官网: https://www.elastic.co/应用场景• 搜索:海量数据的查询• 日志数据分析• 实时数据分析

2. 安装 ElasticSearch

3. ElasticSearch 核心概念

索引(index)

\- ES 5.x 中一个 index 可以有多种 type 。\- ES 6.x 中一个 index 只能有一种 type 。\- ES 7.x 以后,将逐步移除 type 这个概念,现在的操作已经不再使用,默认 _doc

4. 操作 ElasticSearch

put http://ip: 端口/索引名称 #这里确实是put,不是post

GET http://ip: 端口 / 索引名称 # 查询单个索引信息GET http://ip: 端口 / 索引名称 1, 索引名称 2... # 查询多个索引信息GET http://ip: 端口 /_all # 查询所有索引信息

DELETE http://ip: 端口 / 索引名称

POST http://ip: 端口 / 索引名称 /_closePOST http://ip: 端口 / 索引名称 /_open

text :会分词,不支持聚合keyword :不会分词,将全部内容作为一个词条,支持聚合

integer_range, float_range, long_range, double_range, date_range

PUT person

#添加映射

PUT /person/_mapping

{

"properties":{

"name":{

"type":"text"

},

"age":{

"type":"integer"

}

}

}#创建索引并添加映射

PUT /person1

{

"mappings": {

"properties": {

"name": {

"type": "text"

},

"age": {

"type": "integer"

}

}

}

}#添加字段

PUT /person1/_mapping

{

"properties": {

"adress": {

"type": "text"

},

}

}查询映射

GET person1/_mapping详细的mapping操作请点击这篇文章:

http://t.csdn.cn/Ex2Hxhttp://t.csdn.cn/Ex2Hx

操作文档

添加文档,指定id

POST /person1/_doc/2

{

"name":"张三",

"age":18,

"address":"北京"

}

GET /person1/_doc/1添加文档,不指定id

#添加文档,不指定id

POST /person1/_doc/

{

"name":"张三",

"age":18,

"address":"北京"

}GET /person1/_searchDELETE /person1/_doc/15.分词器

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如““我爱编程”会被分为"我"∵爱"∵"编”"程”,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。如果要使用中文,建议使用ik分词器!

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "乒乓球明年总冠军"

}GET /_analyze

{

"analyzer": "ik_smart",

"text": "乒乓球明年总冠军"

}PUT person2

{

"mappings": {

"properties": {

"name": {

"type": "keyword"

},

"address": {

"type": "text",

"analyzer": "ik_max_word"

}

}

}

}POST /person2/_doc/1

{

"name":"张三",

"age":18,

"address":"北京海淀区"

}

POST /person2/_doc/2

{

"name":"李四",

"age":18,

"address":"北京朝阳区"

}

POST /person2/_doc/3

{

"name":"王五",

"age":18,

"address":"北京昌平区"

}GET person2

GET _analyze

{

"analyzer": "ik_max_word",

"text": "北京海淀"

}GET /person2/_search

{

"query": {

"term": {

"address": {

"value": "北京"

}

}

}

}GET /person2/_search

{

"query": {

"match": {

"address":"北京昌平"

}

}

}6. ElasticSearch JavaAP

SpringBoot整合ES

<!--引入es的坐标-->

<dependency>

<groupId>org.elasticsearch.client</groupId>

<artifactId>elasticsearch-rest-high-level-client</artifactId>

<version>7.4.0</version>

</dependency>

<dependency>

<groupId>org.elasticsearch.client</groupId>

<artifactId>elasticsearch-rest-client</artifactId>

<version>7.4.0</version>

</dependency>

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch</artifactId>

<version>7.4.0</version>

</dependency>@Configuration

@ConfigurationProperties(prefix="elasticsearch")

public class ElasticSearchConfig {

private String host;

private int port;

public String getHost() {

return host;

}

public void setHost(String host) {

this.host = host;

}

public int getPort() {

return port;

}

public void setPort(int port) {

this.port = port;

}

@Bean

public RestHighLevelClient client(){

return new RestHighLevelClient(RestClient.builder(

new HttpHost(host,port,"http")));

}

}测试类

@SpringBootTest

class ElasticsearchDay01ApplicationTests {

@Autowired

RestHighLevelClient client;

/**

* 测试

*/

@Test

void contextLoads() {

System.out.println(client);

}

}索引操作

添加索引

/**

* 添加索引

* @throws IOException

*/

@Test

public void addIndex() throws IOException {

//1.使用client获取操作索引对象

IndicesClient indices = client.indices();

//2.具体操作获取返回值

//2.1 设置索引名称

CreateIndexRequest createIndexRequest=new CreateIndexRequest("itheima");

CreateIndexResponse createIndexResponse =

indices.create(createIndexRequest, RequestOptions.DEFAULT);

//3.根据返回值判断结果

System.out.println(createIndexResponse.isAcknowledged());

}添加索引,并添加映射

/** * 添加索引,并添加映射 */ @Test public void addIndexAndMapping() throws IOException { //1.使用client获取操作索引对象 IndicesClient indices = client.indices(); //2.具体操作获取返回值 //2.具体操作,获取返回值 CreateIndexRequest createIndexRequest = new CreateIndexRequest("itcast"); //2.1 设置mappings String mapping = "{\n" + " \"properties\" : {\n" + " \"address\" : {\n" + " \"type\" : \"text\",\n" + " \"analyzer\" : \"ik_max_word\"\n" + " },\n" + " \"age\" : {\n" + " \"type\" : \"long\"\n" + " },\n" + " \"name\" : {\n" + " \"type\" : \"keyword\"\n" + " }\n" + " }\n" + " }"; createIndexRequest.mapping(mapping,XContentType.JSON); CreateIndexResponse createIndexResponse = indices.create(createIndexRequest, RequestOptions.DEFAULT); //3.根据返回值判断结果 System.out.println(createIndexResponse.isAcknowledged()); }

/**

* 查询索引

*/

@Test

public void queryIndex() throws IOException {

IndicesClient indices = client.indices();

GetIndexRequest getRequest=new GetIndexRequest("itcast");

GetIndexResponse response = indices.get(getRequest,

RequestOptions.DEFAULT);

Map<String, MappingMetaData> mappings = response.getMappings();

//iter 提示foreach

for (String key : mappings.keySet()) {

System.out.println(key+"==="+mappings.get(key).getSourceAsMap());

}

}/**

* 删除索引

*/

@Test

public void deleteIndex() throws IOException {

IndicesClient indices = client.indices();

DeleteIndexRequest deleteRequest=new DeleteIndexRequest("itheima");

AcknowledgedResponse delete = indices.delete(deleteRequest,

RequestOptions.DEFAULT);

System.out.println(delete.isAcknowledged());

}索引是否存在 文章来源:https://www.toymoban.com/news/detail-723651.html

/**

* 索引是否存在

*/

@Test

public void existIndex() throws IOException {

IndicesClient indices = client.indices();

GetIndexRequest getIndexRequest=new GetIndexRequest("itheima");

boolean exists = indices.exists(getIndexRequest,

RequestOptions.DEFAULT);

System.out.println(exists);

}文档操作文章来源地址https://www.toymoban.com/news/detail-723651.html

@Test

public void addDoc1() throws IOException {

Map<String, Object> map=new HashMap<>();

map.put("name","张三");

map.put("age","18");

map.put("address","北京二环");

IndexRequest request=new IndexRequest("itcast").id("1").source(map);

IndexResponse response = client.index(request, RequestOptions.DEFAULT);

System.out.println(response.getId());

}@Test

public void addDoc2() throws IOException {

Person person=new Person();

person.setId("2");

person.setName("李四");

person.setAge(20);

person.setAddress("北京三环");

String data = JSON.toJSONString(person);

IndexRequest request=new

IndexRequest("itcast").id(person.getId()).source(data,XContentType.JSON);

IndexResponse response = client.index(request, RequestOptions.DEFAULT);

System.out.println(response.getId());

}/**

* 修改文档:添加文档时,如果id存在则修改,id不存在则添加

*/

@Test

public void UpdateDoc() throws IOException {

Person person=new Person();

person.setId("2");

person.setName("李四");

person.setAge(20);

person.setAddress("北京三环车王");

String data = JSON.toJSONString(person);

IndexRequest request=new

IndexRequest("itcast").id(person.getId()).source(data,XContentType.JSON);

IndexResponse response = client.index(request, RequestOptions.DEFAULT);

System.out.println(response.getId());

}/**

* 根据id查询文档

*/

@Test

public void getDoc() throws IOException {

//设置查询的索引、文档

GetRequest indexRequest=new GetRequest("itcast","2");

GetResponse response = client.get(indexRequest, RequestOptions.DEFAULT);

System.out.println(response.getSourceAsString());

}/**

* 根据id删除文档

*/

@Test

public void delDoc() throws IOException {

//设置要删除的索引、文档

DeleteRequest deleteRequest=new DeleteRequest("itcast","1");

DeleteResponse response = client.delete(deleteRequest,

RequestOptions.DEFAULT);

System.out.println(response.getId());

}到了这里,关于ElasticSearch从入门到精通(一)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!