Flinkx/Datax/Flink-CDC 优劣势对比_HiBoyljw的博客-CSDN博客

一、FlinkX简介(已改名为chunjun)

FlinkX是一款基于Flink的分布式离线/实时数据同步插件,可实现多种异构数据源高效的数据同步,其由袋鼠云于2016年初步研发完成,目前有稳定的研发团队持续维护,已在Github上开源(开源地址详见文章末尾),并维护该开源社区。目前已完成批流统一,离线计算与流计算的数据同步任务都可基于FlinkX实现。

FlinkX是一个基于Flink的批流统一的数据同步工具,既可以采集静态的数据,比如MySQL,HDFS等,也可以采集实时变化的数据,比如MySQL binlog,Kafka等。

GItHub地址: GitHub - DTStack/chunjun: A data integration framework

FlinkX将不同的数据源库抽象成不同的Reader插件,目标库抽象成不同的Writer插件,具有以下特点:

- 基于Flink开发,支持分布式运行;

- 双向读写,某数据库既可以作为源库,也可以作为目标库;

- 支持多种异构数据源,可实现MySQL、Oracle、SQLServer、Hive、Hbase等20多种数据源的双向采集。

- 高扩展性,强灵活性,新扩展的数据源可与现有数据源可即时互通。

FlinkX目前包含下面这些特性:

● 大部分插件支持并发读写数据,可以大幅度提高读写速度;

● 部分插件支持失败恢复的功能,可以从失败的位置恢复任务,节约运行时间;失败恢复

● 关系数据库的Reader插件支持间隔轮询功能,可以持续不断的采集变化的数据;间隔轮询

● 部分数据库支持开启Kerberos安全认证;Kerberos

● 可以限制reader的读取速度,降低对业务数据库的影响;

● 可以记录writer插件写数据时产生的脏数据;

● 可以限制脏数据的最大数量;

● 支持多种运行模式;

FlinkX目前支持下面这些数据库:

github:https://github.com/oceanos/flinkx

二、DataX简介

DataX 是一个异构数据源离线同步工具,致力于实现包括关系型数据库(MySQL、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等各种异构数据源之间稳定高效的数据同步功能。

● 设计理念

为了解决异构数据源同步问题,DataX将复杂的网状的同步链路变成了星型数据链路,DataX作为中间传输载体负责连接各种数据源。当需要接入一个新的数据源的时候,只需要将此数据源对接到DataX,便能跟已有的数据源做到无缝数据同步。

● 当前使用现状

DataX在阿里巴巴集团内被广泛使用,承担了所有大数据的离线同步业务,并已持续稳定运行了6年之久。目前每天完成同步8w多道作业,每日传输数据量超过300TB。

DataX本身作为离线数据同步框架,将数据源读取和写入抽象成为Reader/Writer插件,纳入到整个同步框架中。

- Reader:Reader为数据采集模块,负责采集数据源的数据,将数据发送给Framework。

- Writer: Writer为数据写入模块,负责不断向Framework取数据,并将数据写入到目的端。

- Framework:Framework用于连接reader和writer,作为两者的数据传输通道,并处理缓冲,流控,并发,数据转换等核心技术问题。

- github:https://github.com/alibaba/DataX

三、FlinkX与DataX对比

在Flink的生态圈里面与DataX对标的就是FlinkX,有可能就是同一批开发人员。

3.1 相同点:

● 支持多种数据库的数据同步

● 支持高并发数据读写

● 支持大批量数据批量读写

3.2 不同点:

- DataX任务是单机多线程的,资源占用多。FlinX提交Flink 任务至Flink 集群,可以分布式运行,且可以使用Yarn进行任务调度,与Hadoop生态无缝结合。

- DataX只支持离线批处理。

- FlinkX支持批处理和部分数据库的流式处理。

3.3 总结:

- FlinkX与DataX 都数据大数据数据同步的第三方插件,但是FlinX很多功能都是对标DataX的,并在其原有基础上进行了改进。

- DataX是一个单机同步工具,核心底层通道的分布式支持不友好,而FlinkX任务是基于Flink集群的,可以无缝结合Hadoop生态。所以在分布式、高效性和易于拓展方面 FlinX是优于DataXD的。

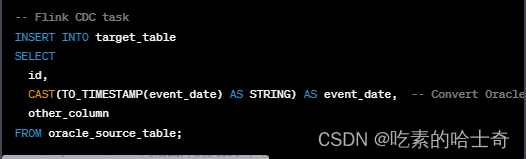

四、Flink-CDC 简介

Flink CDC 连接器是 Apache Flink 的一组源连接器,使用变更数据捕获 (CDC) 从不同数据库中获取变更。

● 支持读取数据库快照并继续读取binlog,即使发生故障也只处理一次。

● DataStream API 的 CDC 连接器,用户可以在单个作业中使用对多个数据库和表的更改,而无需部署 Debezium 和 Kafka。

● Table/SQL API 的 CDC 连接器,用户可以使用 SQL DDL 创建 CDC 源来监视单个表上的更改。

github:https://github.com/oceanos/flinkx/blob/1.8_release/docs/rdbwriter.md

五、FlinkX与Flink-CDC对比

5.1 相同点:

● 都是基于Flink,提交Flink 任务

● 对MySQL/Kafka/Postgres 都支持流式变更(CDC),数据实时变更、实时抓取

● 针对流式处理都是基于日志的CDC

5.2 不同点:

● FlinkX属于第三方插件,而Flink-CDC属于Flink的一组连接器。相对而言,Flink-CDC更轻,且使用更方便。

● FlinkX支持的数据源更多,Flink-CDC目前只支持MySQL/Kafka/Postgres的实时CDC

● FlinkX支持批处理和流处理、Flink-CDC只支持流处理。

5.3 实时处理:

如果需要对数据同步采用实时处理的话,由于数据是存储在Mysql中,所以无论是FlinkX和Flink-CDC都是支持的。它们的底层都是基于Debezium 的binlog来进行数据同步的。

5.4 缺点:

● 需要修改binlog模式,日志存储空间需要增大。

- 离线批处理:

如果需要采用离线批处理方式,建议采用FlinkX。因为其高效、稳定,且支持多种数据源。

缺点:

● 采用离线批处理的话,其本质是基于查询的CDC。与基于日志的CDC还是有所区别的

具体对比如下:

文章来源:https://www.toymoban.com/news/detail-725029.html

文章来源:https://www.toymoban.com/news/detail-725029.html

5.5 总结:

● 实时数据同步带来的风险是需要修改binlog模式,导致日志存储空间增大。且支持的数据库比较少。

● 离线批量同步的本质是基于查询的CDC,需要部署第三方插件,同时其带来的风险是无法实时捕获所有数据变化、相对基于日志的CDC延迟性更高、高频率和大批量的数据同步会增加数据库的负担,因为它在同步的时候需要一直去连接数据库进行数据查询、无法捕获删除事件和旧记录状态。文章来源地址https://www.toymoban.com/news/detail-725029.html

到了这里,关于Flinkx/Datax/Flink-CDC 优劣势对比的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!