Flink基础知识点博文汇总:

- Flink(1):Flink概述

- Flink(2):为什么选择Flink

- Flink(3):Flink安装部署之Local本地模式

- Flink(4):Flink安装部署之Standalone独立集群模式

- Flink(5):Flink安装部署之Standalone-HA高可用集群模式

- Flink(6):Flink安装部署之Flink On Yarn模式

- Flink(7):Flink提交命令之参数总结

- Flink(8):Flink的API说明和pom文件汇总

- Flink(9):Flink的各种创建执行环境的方法

- Flink(10):Flink原理初探

- Flink(11):Flink之流批一体架构

- Flink(12):Flink之Source数据源

- Flink(13):Flink之Transformation算子(上)

- Flink(14):Flink之Transformation算子(下)

- Flink(15):Flink之Sink数据输出

- Flink(16):Flink之Connect Kafka API

- Flink(17):Flink之Connect API

- Flink(18):Flink之累加器

- Flink(19):Flink之广播变量

- Flink(20):Flink之分布式缓存

- Flink(21):Flink之Window

- Flink(22):Flink之Window案例一(基于时间的滚动和滑动窗口)

- Flink(23):Flink之Window案例二(基于数量的滚动和滑动窗口)

- Flink(24):Flink之Window案例三(会话窗口)

- Flink(25):Flink之WindowFunction的使用

- Flink(26):Flink中的时间语议

- Flink(27):Flink中的Watermark

- Flink(28):Flink之Watermark案例演示

- Flink(29):Flink中对迟到数据的处理(Allowed Lateness 和 SideOutput)

- Flink(30):Flink中的状态管理(上)

- Flink(31):Flink中的状态管理(下)

- Flink(32):Flink之Checkpoint

- Flink(33):Flink之状态恢复和重启策略

- Flink(34):Flink之Savepoint

- Flink(35):Flink之并行度详解

- Flink(36):Flink之TableAPI和FlinkSQL的整体介绍

- Flink(37):Flink之TableAPI和FlinkSQL的API调用(上)

- Flink(38):Flink之TableAPI和FlinkSQL的API调用(中)

- Flink(39):Flink之TableAPI和FlinkSQL的API调用(下)

- Flink(40):Flink之TableAPI和FlinkSQL的流处理中的特殊概念

- Flink(41):Flink之TableAPI和FlinkSQL的窗口(Windows)

- Flink(42):Flink之TableAPI和FlinkSQL中的函数(Functions)

- Flink(43):Flink之TableAPI和FlinkSQL中的案例准备

- Flink(44):Flink之TableAPI和FlinkSQL的案例一

- Flink(45):Flink之TableAPI和FlinkSQL的案例二

- Flink(46):Flink之TableAPI和FlinkSQL的案例三

- Flink(47):Flink之TableAPI和FlinkSQL的案例四

- Flink(48):Flink之TableAPI和FlinkSQL中的常用算子

- Flink(49):Flink之综合练习(一)

- Flink(50):Flink之综合练习(二)

- Flink(51):Flink高级特性之广播状态(BroadcastState)

- Flink(52):Flink高级特性之双流Join

- Flink(53):Flink高级特性之端到端精确一次消费(End-to-End Exactly-Once)

- Flink(54):Flink高级特性之异步IO(Async I/O)

- Flink(55):Flink高级特性之流式文件写入(Streaming File Sink)

- Flink(56):Flink高级特性之文件写入(File Sink)

- Flink(57):Flink高级特性之FlinkSQL整合Hive

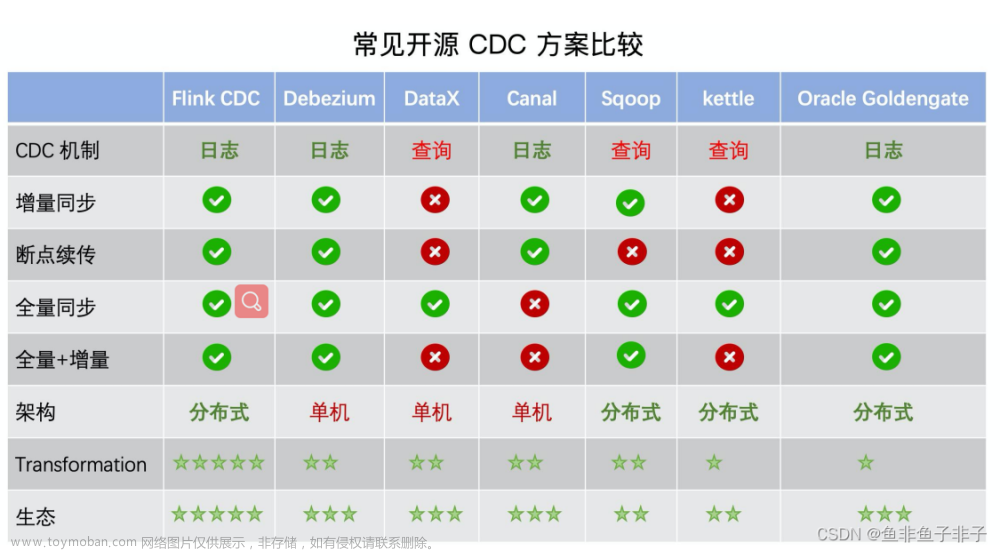

- Flink(58):Flink之FlinkCDC(上)

- Flink(59):Flink之FlinkCDC(下)

- Flink(60):Flink中通用ModelUtil工具类

- Flink(61):Flink中通用KafkaUtil工具类

- Flink(62):Flink中通用MySQLUtil工具类

- Flink(63):Flink中通用RedisUtil工具类

- Flink(64):Flink中异步匹配维度信息(AsyncJoinDimUtil)工具类

未完待续......文章来源:https://www.toymoban.com/news/detail-725345.html

文章来源地址https://www.toymoban.com/news/detail-725345.html

到了这里,关于Flink文章汇总的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!