作者:禅与计算机程序设计艺术

1.简介

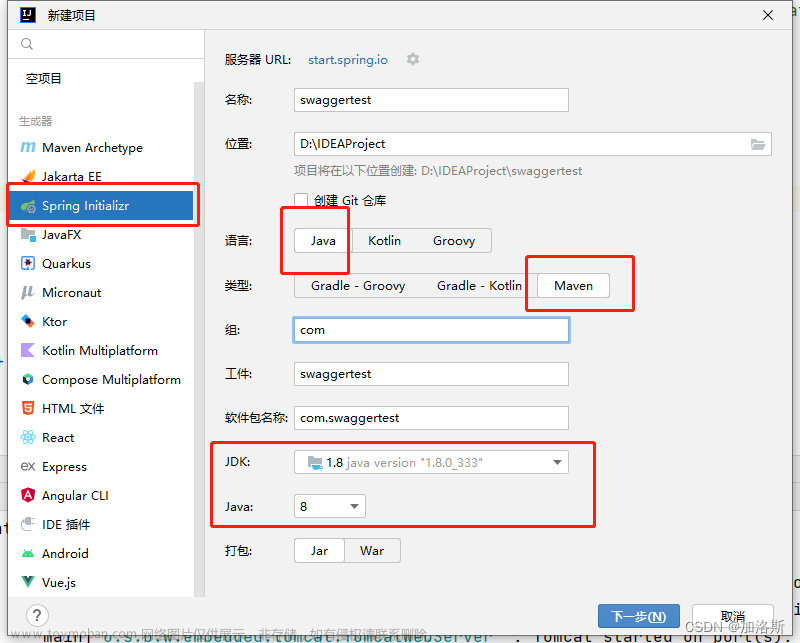

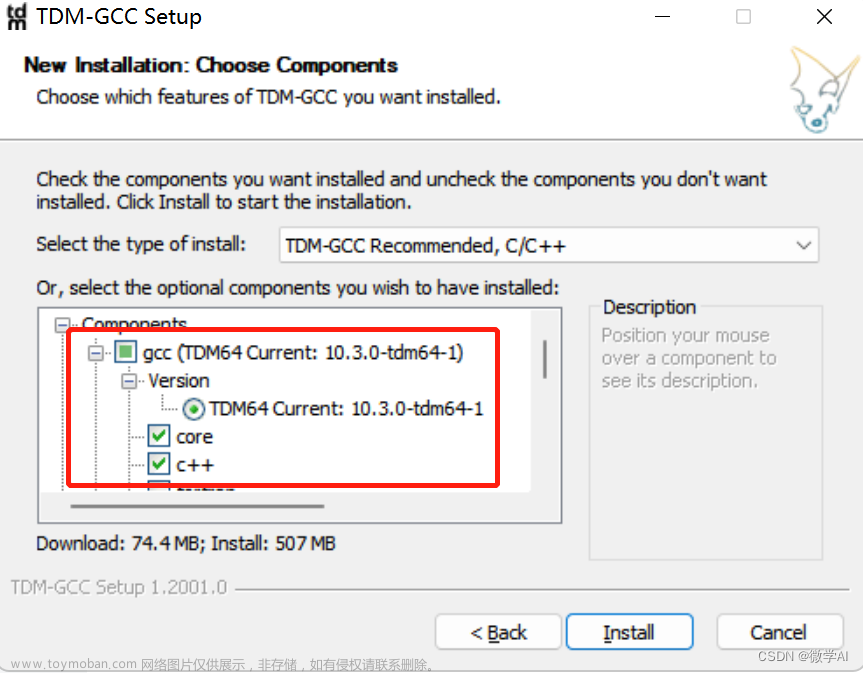

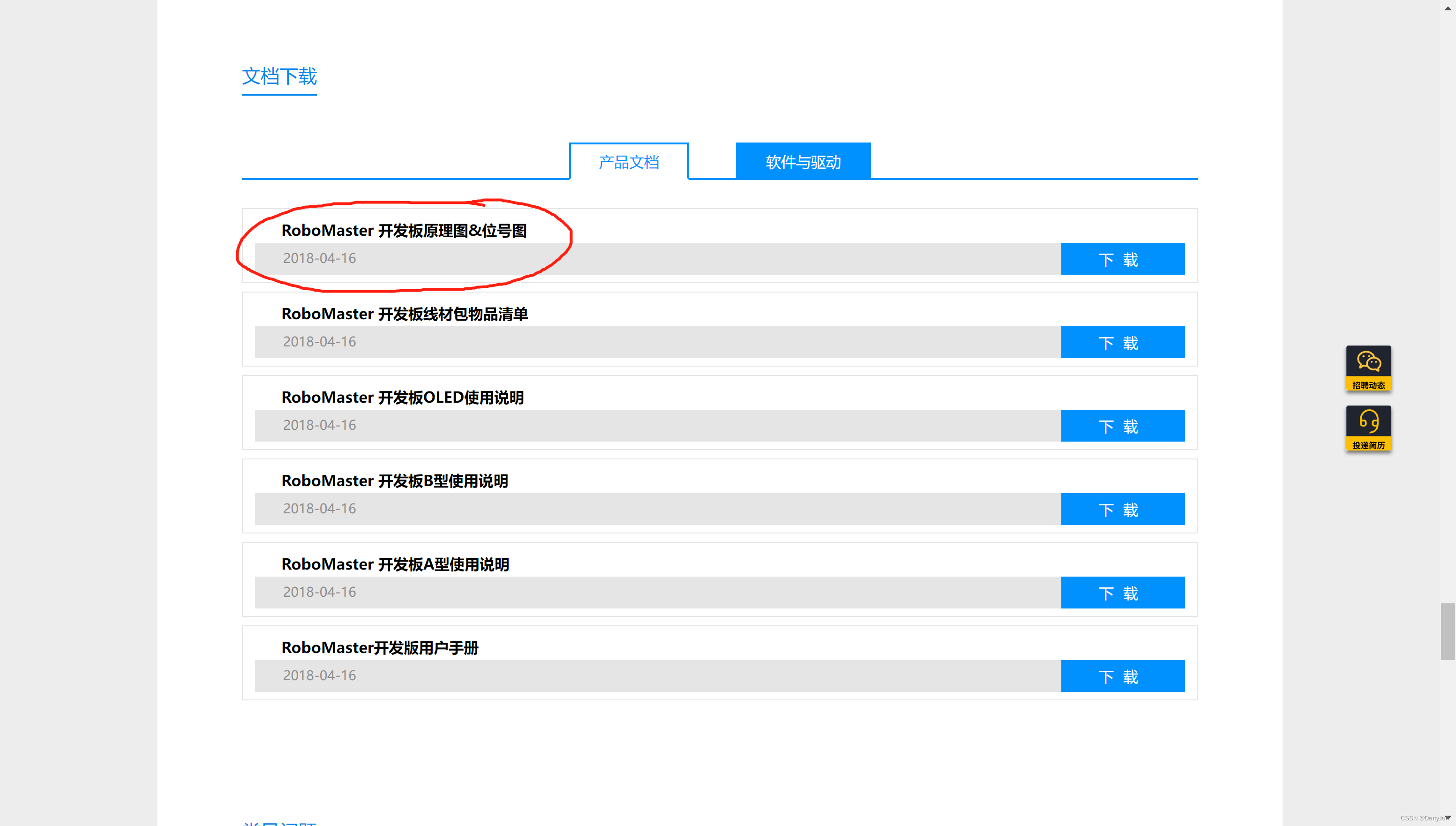

Apache Spark是由加州大学伯克利分校AMP实验室开发的一个开源大数据处理框架。它基于Hadoop MapReduce计算模型实现,可以有效地处理海量数据并将结果存储到外部系统或数据库中。Spark提供高性能、可扩展性、容错性和易用性等优点。在大数据分析场景下,PySpark是Spark的Python API。本文通过一个简单的案例来介绍Pyspark的安装及使用方法。文章将详细介绍Spark编程模型,主要包括RDD、DataFrame、Dataset三种数据结构,对每个数据结构的操作,PySpark的数据转换函数(UDF),以及一些常用的机器学习算法。希望通过本文,读者能够了解Pyspark的基本使用方法,掌握面向对象编程的技巧,同时也会提升自己对Spark的理解。文章来源:https://www.toymoban.com/news/detail-727219.html

2.基本概念术语说明

2.1 Apache Spark概述

Apache Spark是由加州大学伯�利分校AMP实验室开发的一个开源大数据处理框架。它基于Hadoop MapReduce计算模型实现,可以有效地处理海量数据并将结果存储到外部系统或数据库中。Spark提供高性能、可扩展性、容错性和易用性等优点。Spark支持多语言编写的应用,如Scala、Java、Python、R、SQL、Hive SQL、Pig Latin等,而且还提供了超过八十种高级算子API,使得用户可以轻松快速地进行数据处理。其独有的弹性分布式内存计算功能,使得Spark可以在内存中进行数据缓存,并在计算过程中自动进行数据调度,提高了运算速度。Spark由三个组件构成——Spark Core、Spark Streaming、Spark SQL、Spark MLlib和Spark GraphX,其中Co文章来源地址https://www.toymoban.com/news/detail-727219.html

到了这里,关于从零开始手把手学习Pyspark的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!