这里可以查看所有论文。由于作者book只更新到第二章剩下的只有从论文中学习,但书中的目录和论文可以由于对应起来。第一二章可以对应到第一篇论文,这里。

一种博弈论驱动的使用命题逻辑的最优模式识别方法

尽管单独而言很简单,但人工神经元在深度网络中互连时可提供最先进的性能。 可以说,Tsetlin 自动机是一种更简单、更通用的学习机制,能够解决多臂老虎机问题。仅通过单个整数作为内存,它通过递增和递减操作来学习随机环境中的最佳动作。 在本文中,我们介绍了 Tsetlin 机,它通过命题公式解决复杂的模式识别问题,由 Tsetlin 自动机的集合组成。 为了消除信噪比消失这一长期存在的问题,Tsetlin Machine 使用一种新颖的游戏来协调自动机。 此外,输入、模式和输出都表示为位,而识别和学习则依赖于位操作,从而简化了计算。 我们的理论分析表明,游戏的纳什均衡与提供最佳模式识别准确性的命题公式相一致。 这意味着学习没有局部最优,只有全局最优。 在五个基准测试中,与 SVM、决策树、随机森林、朴素贝叶斯分类器、逻辑回归和神经网络相比,Tsetlin 机器提供了具有竞争力的准确性。 我们进一步证明命题公式如何促进解释。 总之,我们相信高精度、可解释性和计算简单性的结合使 Tsetlin 机器成为广泛领域的有前途的工具。

1 介绍

虽然单独看来人工神经元很简单,但当它们在深度网络中相互连接时,可以提供最先进的性能[1]。然而,深度神经网络通常需要大量的训练数据和大规模的计算资源。许多人可能不知道,存在一种被认为比人工神经元更基本和更多才多艺的学习机制,即由M.L. Tsetlin于20世纪60年代初在苏联开发的Tsetlin自动机[2]。在本文中,我们提出了一种基于Tsetlin自动机的大规模和复杂模式识别的新技术。

1.1 Tsetlin自动机

Tsetlin自动机已被用来模拟生物系统,并因其在未知随机环境下学习最优动作而引起了广泛关注[2, 3]。此外,它们结合了快速和准确的收敛性以及低计算复杂性。简而言之,Tsetlin自动机是众所周知的多臂赌博问题[4, 5]和第一个学习自动机[3]的开创性解决方案之一。它在环境中依次执行动作αz,其中z ∈ {1, 2}。每个动作αz触发的结果要么是奖励,要么是惩罚。也就是说,动作以概率pz被奖励,否则会受到惩罚。自动机并不知道奖励概率,而这些概率可能会随时间变化。在这种具有挑战性的情况下,目标是在尽量少的尝试中识别具有最高奖励概率的动作。

图1 用于双动作环境的Tsetlin自动机。

驱动Tsetlin自动机的机制出奇地简单。简言之,如图1所示,Tsetlin自动机只是一个带有不同寻常解释的固定有限状态自动机[6]:

• 自动机的当前状态决定要执行哪个动作。图中的自动机有2N个状态。动作1(α1)在索引1到N的状态中执行,而动作2(α2)在索引N+1到2N的状态中执行。

• 自动机的状态转换管理着学习。在奖励时激活一组状态转换(图中的实线),在惩罚时激活另一组状态转换(图中的虚线)。正如所见,奖励和惩罚触发了从一个状态到另一个状态的特定转换,旨在强化成功的动作(那些引发奖励的动作)。

从形式上来说,一个双动作Tsetlin自动机可以被定义为一个五元组[3]:

{Φ, α, β, F(·, ·), G(·)}.

Φ = {φ1, φ2, . . . , φ2N} 是内部状态的集合。

α = {α1, α2} 是自动机动作的集合。

β = {βPenalty, βReward} 是可以提供给自动机的输入集合。一个输出函数 G(φu) 确定了在给定当前自动机状态φu时自动机执行的下一个动作:

G(φu) =α1, if 1 ≤ u ≤ N ,α2, if N + 1 ≤ u ≤ 2N.

在实现上,Tsetlin自动机简单地维护一个整数(状态索引),学习是通过根据F(φu, βv)指定的状态转换进行增加和减少操作来执行的(如图1所示)。因此,Tsetlin自动机在计算上非常简单,内存占用极小。(暂时先第235章)

2 模式识别问题

机器学习技术的准确性受其模式表示能力的限制。例如,朴素贝叶斯分类器假定在给定输出类别的情况下,输入变量是相互独立的。一般而言,与数字计算机的基础语言,即布尔代数,相比,大多数机器学习技术似乎受到一定限制,神经网络是其中的一个例外。以命题逻辑/布尔代数为出发点,我们在这里定义了Tsetlin机器要解决的模式识别问题。

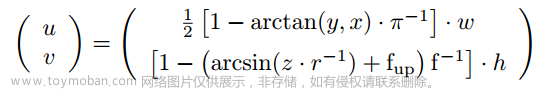

输入和输出。考虑一个包含o个命题变量的输入向量:X = (x1, . . . , xo) ∈ X,X = {0, 1}^o。连同它们的否定对应项,x¯k = ¬xk = 1 - xk,这些变量构成了一个文字集合L = {l1, . . . , l2o} = {x1, . . . , xo, x¯1, . . . , x¯o}。从这些文字中,我们将生成一个包含m个命题变量的输出向量:Y = (y1, y2, . . . , ym) ∈ Y,Y = {0, 1}^m。为了简化表示,我们在本文的其余部分将任何特定的输出变量y_i,i = 1, . . . , m,表示为单个输出变量y,而不失一般性。

在Tsetlin机器学习中,模式被表示为命题逻辑中的合取子句,用Cj表示,其中j是子句的索引。合取子句由文字集合L的子集Lj ⊆ L进行合取操作组成。

举个例子,子句Cj(X) = x1 ∧ x2 = x1x2 由文字集合Lj = {x1, x2} 组成,当且仅当x1 = x2 = 1时,它的输出为1。

需要注意的是,命题逻辑中的任何公式都可以重新表述为合取子句的析取(也称为析取正规式)。对于o个输入变量,你可以表达不少于2(2o) 个独特的命题公式,这使得合取子句成为表达复杂非线性模式的强大构建模块。可以说,它们也对人类来说相对容易理解[28]。

图2 根据输出变量y的后验概率对输入空间进行划分,突出显示了输入空间X中的不同子模式。最有可能属于输出y = 1的子模式位于右侧,而最有可能属于y = 0的子模式位于左侧。

学习问题和子模式。如图2所示,输入空间X可以分为两部分,X1 = {X|P(y = 0|X) ≤ P(y = 1|X)} 和 X0 = {X|P(y = 0|X) > P(y = 1|X)}。对于X1中的输入向量,通过将y赋值为1可以最大化分类准确性。相反,对于X0中的输入向量,通过将y赋值为0可以最大化准确性。因此,我们要解决的学习问题是找到最大化分类准确性的输入空间的划分。

现在,我们来讨论关键的未标记子模式的概念。如图2所示,我们将X0和X1分解为各自的n/2个子分区,分别是X0j,j ∈ {1, . . . , n/2} 和 X1j,j ∈ {1, . . . , n/2}。每个子分区Xωj,ω ∈ {0, 1},都由相应的合取子句定义,其中包含使合取子句评估为1的所有输入,且只包含这些输入。例如,考虑异或关系。然后,X0分解为X01 = {X|x1x2 = 1}和X02 = {X|x¯1x¯2 = 1},而X1分解为X11 = {X|x1x¯2 = 1}和X12 = {X|x¯1x2 = 1}。

在这些假设下,给定n和s,模式识别问题的任务是通过观察来自未知分布P(X, y)的输入-输出样本(X, y)来恢复子句Qωj(X),其中j ∈ {1, . . . n/2},ω ∈ {0, 1}。

需要注意的是,在实际应用中,对于真实世界的数据,n和s可能是未知的。它们可以被视为超参数,通过超参数搜索进行优化。

3 Tsetlin机器

Tsetlin机器将问题分解为以命题逻辑中的合取子句表示的自包含模式。在本节中,我们首先介绍基于子句的推理结构,然后继续介绍负责组成这些子句的Tsetlin自动机团队。这些团队通过一种游戏进行协调,使用所谓的I型和II型反馈,结合资源分配动态来优化准确性。我们在本节中结束讨论游戏的详细内容,包括伪代码。

3.1 Tsetlin机器推理结构

图3 Tsetlin机器的推理结构包括引入子句极性,一个收集“投票”的求和运算符,以及一个裁决最终输出的阈值函数。

Tsetlin机器的推理结构如图3所示。如图所示,o个命题变量的输入向量X = (x1, . . . , xo) ∈ X,其中X = {0, 1}^o,被馈送到多个合取子句进行评估。

所使用的子句数量是用户设定的参数n。一半的子句被分配正极性,用上标1表示:C1j,j ∈ {1, . . . , n/2}。另一半被分配负极性,用上标0表示:C0j,j ∈ {1, . . . , n/2}。在图中,极性用附加在每个子句上的’+‘或’-'符号来表示。

这些子句的作用是根据方程4来捕捉X中的子模式,不过有一些微调。我们允许没有文字的子句,即Lωj = ∅,j ∈ {1, . . . , n/2},ω ∈ {0, 1}。这些子句在学习期间输出1,在分类期间输出0:

换句话说,在分类期间,没有文字的子句不起任何作用,可以从推理结构中剪除。然而,在学习期间,输出1会刺激子句进一步更新,如第3.3节所探讨的。

子句的评估结果被组合成最终的输出决策,通过求和和单位阶跃阈值函数,即u(v) = 1,如果v ≥ 0,否则为0:

也就是说,输出是基于多数投票决定的,正极性子句投票支持y = 1,而负极性子句投票支持y = 0。这样做的目的是达到平衡的输出决策,权衡输入中的正面和负面证据。例如,分类器yˆ = u(x1x¯2 + x¯1x2 − x1x2− x¯1x¯2) 捕捉了XOR关系。

3.2 Tsetlin机器的子句组成集合

回顾一下,Tsetlin自动机可以表示为一个五元组{Φ,α,β,F(·, ·),G(·)}。Tsetlin Machine的每个子句Cωj,ω ∈ {0, 1},j ∈ {1, . . . , n/2},由一个这样的Tsetlin自动机团队组成。该团队由2o个自动机组成,每个自动机分配给L中的一个文字lk。让Φωjk ∈ {φ1, φ2,…,φ2N}表示负责子句Cωj,ω ∈ {0, 1},j ∈ {1, . . . , n/2}的文字lk的Tsetlin自动机的状态。这个状态决定了文字是否被排除(动作α1)或包括在子句中(动作α2)。

图4 两个Tsetlin自动机团队,每个团队生成一个合取子句。最终的输出是基于多数投票决定的。

图4描述了两个子句,一个带有正极性(C1),一个带有负极性(C0)。它们都分配了四个Tsetlin自动机,每个自动机有六个状态,用于控制文字L = {x1, x2, ¬x1, ¬x2}是否包括在内。例如,在图中最左边的Tsetlin自动机已经决定包括文字x1,因为它处于状态φ4。第二个Tsetlin自动机,处于状态φ3,已经决定排除文字x2。根据C1的四个Tsetlin自动机的决策,该子句的形式为x1x¯2。类似地,子句C0的形式为x1x2。

3.3 Tsetlin Machine用于组合子句

3.3.1 Tsetlin Automata Games

Tsetlin自动机的游戏涉及多个自动机,游戏分为多个回合[3]。在游戏的每一轮中,参与的Tsetlin自动机独立地决定他们的下一步行动,从动作集α中选择。因此,如果每个自动机有两个可选的动作,它们将共同选择2^W个独特的动作配置,其中W是自动机的数量。在Tsetlin自动机做出决策后,该回合结束,根据共同选择的动作配置,自动机将被单独处罚/奖励。然后,游戏的下一轮开始。

为了完全规定游戏,我们需要为每个独特的动作配置分配Tsetlin自动机的奖励概率。我们将这些奖励概率称为游戏的支付矩阵。对于W个双动作自动机,我们需要W2W个支付矩阵的奖励概率。

3.3.2 Design of the Payoff Matrix

Tsetlin Machine游戏的潜在复杂性是巨大的,因为每个Tsetlin自动机的决策共同决定了Tsetlin Machine作为一个整体的行为。事实上,在适当的条件下,单个Tsetlin自动机有能力通过引入矛盾来完全破坏子句。因此,游戏的回报必须经过精心设计,以便引导Tsetlin自动机构建解决手头的模式识别问题的子句。为了进一步增加复杂性,由于潜在的巨大支付矩阵的尺寸,明确枚举支付是不切实际的。

为了解决上述挑战,我们根据真正正例、假负例和假正例子句输出的概念,将支付矩阵进行分解,将子句视为独立的分类器。忽略真正负例子句输出以增加自动机的自由度。通过逐步抑制假负例和假正例子句输出,加强真正正例子句输出,我们打算引导Tsetlin自动机最大化模式识别准确性。这种引导基于我们将称之为Type I和Type II反馈的原则。基于本节中介绍的原则,我们将在第4节中正式定义结果游戏。

3.3.3 Type I Feedback – Combating False Negative Output

在这一部分,讨论了Type I反馈,它的目标是对抗假负输出。假负输出是指分类器错误地将正例标记为负例。这种反馈的目的是减少这种类型的错误,以提高模式识别的准确性。反馈机制将有助于Tsetlin自动机逐渐减少假负输出,从而更好地执行其任务。

表格2包含了生成Type I反馈所使用的概率,这些概率基于三个因素:

Tsetlin自动机团队对子句Cωj(X)的整体决策,即子句的输出。

指派给自动机的文字lk的真值。

自动机决定的动作αz = G(Φωjk),其中z ∈ {1, 2}。

这些概率用于确定基于上述因素的组合方式如何生成Type I反馈。例如,如果:

子句Cωj(X)评估为1,

文字lk的真值为1,

自动机状态Φωjk产生包括动作(α2)。

表格2包含了指定在这种具体情况下如何生成Type I反馈的概率。

通过查看表格2中相应的单元格,我们可以观察到获得奖励的概率P(Reward)为s-1/s。此外,不采取行动的概率P(Inaction)为1/s。最后,获得惩罚的概率P(Penalty)为零。

需要注意的是,Inaction反馈是对Tsetlin自动机的新扩展,传统上它只会收到奖励或惩罚。当收到Inaction反馈时,Tsetlin自动机保持不变。

对Type I反馈的简要分析。请注意,Type I反馈的概率会强制产生包含许多文字的子句,直到某个点。我们通过更强烈地强化包含动作,而不是排除动作,使用更偏爱包含的奖励和惩罚概率来实现这一点。正如所见,超参数s,s ≥ 1,控制了我们对包含的偏好程度。实际上,s决定了子句将捕捉多精细的模式。s的值越大,Tsetlin自动机越受刺激,以包含文字在其子句中。对抗力是不匹配的输入,即使让子句评估为0的输入。对于这种输入,将奖励排除动作并惩罚包含动作。显然,随着s的增加(包含更多文字),遇到不匹配的输入的概率会增加。当上述两个相互作用的力量平衡时,我们就有了纳什均衡,如在第4节进一步讨论的那样。这些动态是Tsetlin Machine的关键部分,允许学习任何子模式,无论多么不频繁,都由s决定。

rue Positive Feedback Boosting (表2中的第1列)。表2中的反馈概率是基于数学推导选择的(请参阅第4节)。然而,对于某些真实数据集,进一步提高包含操作可以带来好处。也就是说,在这些操作产生真正积极的结果时,可以通过增加奖励来增加模式识别的准确性。然后相应地调整对排除操作的惩罚。简而言之,我们通过在表2的第1列中将s-1/s替换为1.0和1/s替换为0.0的方式来提高奖励。

3.3.4 Type II Feedback – Combating False Positive Output

表3涵盖了Type II反馈,即用于对抗假阳性输出的反馈。当y≠ω时,Type II反馈被给予子句Cωj的Tsetlin自动机。这种反馈的目的是引入增加区分能力的候选文字。也就是说,当y≠ω时,子句Cωj应该输出0,以区分输出ω∈{0, 1}。然而,如果它错误地评估为1,我们可以通过识别已将零值文字排除在子句之外的Tsetlin自动机来进行更正。仅需包含这些文字中的一个即可使冒犯的子句评估为0。这是因为这些子句是连接的。Type II反馈的简要分析。请注意,Type II反馈仅对子句输出1(假阳性输出)时排除值为0的文字进行惩罚。当子句输出0时(表中的两列最左侧),只会提供Inaction反馈。这是为了避免通过让Type I反馈来加强包含操作来避免局部最小值。因此,Type I反馈和Type II反馈共同作用,以最小化预期的输出错误,朝着第4节中探讨的全局最优解前进。

3.3.5 Allocating Clauses to Sub-Patterns

为了使Tsetlin Machine的输出正确,只需确保方程7的求和部分Pn/2j=1 C1j(X) - Pn/2j=1 C0j(X)具有正确的符号。也就是说,只需一个单一的子句,具有适当的极性,输出1即可。然而,在嘈杂的数据情况下,引入一个称为总目标T的余量可能是有益的。目的是使可用的子句在数据中分布到子模式,以便对于任何特定输入X,T个具有正确极性的子句都评估为1。此外,总目标T为子句之间的互动打开了可能性,包括特殊情况的校正。我们在这里引入的资源分配机制受到了一种基于有限状态自动机的解决方案的启发,用于未知和随机环境下的分数背包问题[29]。该机制的目的是确保Tsetlin Machine仅花费少数可用的子句来表示每个特定的子模式。通过随机选择子句以接收反馈,当接近总目标T时减少强度来实现这一目标。

产生类型 I 反馈。对于类型 I 反馈,我们随机选择子句 Cωj,其中 ω = y。在这些子句中,收到类型 I 反馈的概率是:

这里的 clip 操作将限制求和结果在 -T 和 T 之间。

生成类型 II 反馈。对于类型 II 反馈,我们随机选择子句 Cωj,其中 ω ≠ y。收到类型 II 反馈的概率为:

请注意,当触发子句的数量正确接近 T/-T 时,反馈会消失。这对于有效利用可用的模式表示能力非常重要。举例说明,假设对于输入 X,正确的输出是 y = 1。如果子句输出总和积累达到 T 或更多,将不会为涉及的 Tsetlin 自动机提供奖励或惩罚。这使 Tsetlin 自动机可以自由学习其他子模式。

3.3.6 The Tsetlin Machine Algorithm

算法1提供了学习合取子句的逐步过程。该算法以训练样本集(S)中的样本(X, y)为输入,然后生成一组用于预测输出y的合取子句。我们将逐行详细解释该算法。

3.4 Implementation Using Bitwise Operators

在复杂和大规模的模式识别中,内存占用和操作速度可能至关重要。基于命题公式的Tsetlin机器架构可以自然地用比特表示,并使用位运算符进行操作。然而,如何表示和更新Tsetlin自动机本身并不是很直接。首先,每个Tsetlin自动机的状态索引是一个整数值。此外,自动机的操作是通过使用小于运算符来决定的,而反馈是通过递增和递减操作来处理的。

一种位运算的方法是使用多个比特序列联合表示子句Cωj的所有Tsetlin自动机的状态索引。序列1包含每个状态索引的第一个比特,序列2包含第二个比特,依此类推,如图5所示,用于24个Tsetlin自动机。这种表示的好处是每个Tsetlin自动机的操作可以直接从最重要的比特(图中的序列8)获得。因此,可以使用快速位运算(NOT、AND和CMP-比较)基于输入获取子句的输出。

图中使用了来自第5节的Noisy XOR数据集的示例目的。首先,通过将原始输入与原始输入取反连接,将12位输入扩展为24位。然后,将得到的24位与24个Tsetlin自动机连接。前12个自动机控制非否定输入,后12个自动机控制否定输入。

与使用完整的32位整数来表示每个Tsetlin自动机的状态相比,使用后一种基于比特的表示减少了内存使用四倍。更重要的是,可以通过自定义的递增/递减过程并行地使用位运算递增/递减所有自动机的状态,从而显著提高了学习速度。例如,对于MNIST数据集(见第5节),使用基于比特的表示,总内存使用约小了十倍,学习速度快了3.5倍,分类速度提高了8倍。

在训练后部署时,只需要包含最重要比特的状态比特序列。其他比特序列可以丢弃,因为这些比特仅用于跟踪学习过程。这进一步减小了内存使用。

5 实验

在这一部分,我们通过使用五个数据集对Tsetlin机器进行实证评估:

- 二元鸢尾花数据集。这是经典的鸢尾花数据集,但特征以二进制形式表示。

- 二进制数字数据集。这是经典的数字数据集,同样以二进制形式表示特征。

- Axis & Allies桌游数据集。这个新数据集涉及来自Axis & Allies桌游的极简但错综复杂的小游戏中的最佳移动预测。

- 带有无信息特征的嘈杂XOR数据集。这个人工数据集旨在揭示模式识别算法的特定“盲区”。该数据集捕捉了著名的XOR关系。此外,数据集包含大量随机的无信息特征,以衡量对维度诅咒的敏感性。为了检验对噪声的鲁棒性,我们进一步随机地颠倒了40%的输出。

• MNIST数据集。MNIST数据集是一个广泛用于基准测试机器学习算法的大规模数据集。我们包括了这个数据集来研究Tsetlin机器的可扩展性,以及更长的学习过程的行为。

5.1 The Binary Iris Dataset

首先,我们在经典的鸢尾花数据集上评估Tsetlin机器。这个数据集包含150个示例,具有四个输入(花萼长度、花萼宽度、花瓣长度和花瓣宽度)和三个可能的输出(山鸢尾、变色鸢尾和维吉尼亚鸢尾)。

为增加挑战,我们将这四个输入值转换为一个连续的16位序列,每个浮点数四位。因此,还需要学习如何将这16位分为四个分区,并提取数字信息。我们将这个新数据集称为二进制鸢尾花数据集。

我们将这个数据集分为训练集和测试集,其中80%的数据用于训练。我们随机生成了1000个训练和测试数据分区。对于每个集合,我们还随机重新初始化竞争算法,以获得有关稳定性和鲁棒性的信息。结果报告在表6中。

5.5 The MNIST Dataset

接下来,我们在MNIST手写数字数据集上评估Tsetlin机器,并研究学习过程如何逐个epoch按准确性而言。请注意,这里报告的实验结果可以在以下链接中找到的演示中复制:

https://github.com/cair/fast-tsetlin-machine-with-mnist-demo

原始数据集包括60,000个训练示例和10,000个测试示例。我们通过将像素值大于0.3的部分替换为1来对数据集进行二值化。像素值小于或等于0.3的部分被替换为0。

在这里使用的Tsetlin机器包含40,000个子句,每个类别有4,000个子句,使用s值为10.0,总和目标T为50。此外,每个Tsetlin自动机都有256个状态。Tsetlin机器运行了400个epoch,我们报告的是最后一个epoch后的准确性。

如图10所示,平均测试准确度和训练准确度几乎单调地随着epoch的增加而增加,但受到随机波动的影响。值得注意的是,尽管在训练数据上的平均准确度接近99.9%,但在测试数据上的准确度继续增加,经过400个epoch后达到了98.2%。这与在神经网络上使用反向传播的情况完全不同,后者在某个时刻由于过拟合而导致测试数据的准确度下降,而没有适当的正则化机制。

图表还显示了子句数量和总和目标T的变化如何影响准确性和学习稳定性。有更多的子句可用来表达模式,结合更高的总和目标T,可以提高学习速度、稳定性和准确性。文章来源:https://www.toymoban.com/news/detail-727959.html

6 Tsetlin Machine作为更高级架构中的基本构建模块

6.1 The Multi-Class Tsetlin Machine

在一些模式识别问题中,任务是为每个观察到的模式X分配n个类别中的一个。也就是说,需要决定一个单一的输出值,y ∈ {1, . . . , m}。Tsetlin Machine可以通过将y表示为位,使用多个输出y来处理这种多类别模式识别问题。然而,在本节中,我们提出了一种更直接解决多类别模式识别问题的替代架构。

图11描述了多类别Tsetlin Machine,它使用单个argmax运算符替代每个输出y,i ∈ {1, . . . , m}的阈值函数。使用argmax运算符,Tsetlin Machine的最终输出是最大总和的索引i,其中总和为Pn/2 j=1 C1,i j (X) - Pn/2 j=1 C0,i j (X)。

训练遵循第3节中描述的方式,除了一个关键修改。假设对于当前观察(X,y),我们有y = i。那么与类别i相关的Tsetlin自动机团队将根据原始算法1中的y = 1进行训练。此外,随机选择一个不等于i的类q。然后,类别q的Tsetlin自动机团队将按照原始算法中的y = 0进行训练。

6.2 The Fully Connected Deep Tsetlin Machine

另一个架构家族是“Fully Connected Deep Tsetlin Machine” [40],如图12所示。这种架构的目的是构建复合的命题公式,将一层中组成的命题公式组合成下一层的更复杂的公式。正如图中所示,我们在一个序列中连接多个Tsetlin Machine。序列中每个Tsetlin Machine的子句输出被提供为下一个Tsetlin Machine中的输入。通过这种方式,我们构建了一个多层系统。例如,如果第t层产生两个子句(P∧¬Q)和(¬P∧Q),第t + 1层可以进一步处理它们,将它们视为输入。第t + 1层然后可以形成更复杂的公式,如¬(P∧¬Q)∧(P∧¬Q),它可以重写为(¬P∨Q)∧(P∧¬Q)。训练这种架构的一种简单方法如图所示。正如图中所示,每一层都是独立训练的,直接从输出目标y开始,其过程与第3.3节中描述的内容非常相似。因此,训练过程类似于Hinton等人于2006年用于逐层训练深度信念网络的策略[41]。当每一层产生的子句形成了可以在下一层中利用的抽象时,这种方法可以是有效的。文章来源地址https://www.toymoban.com/news/detail-727959.html

到了这里,关于TM 学习记录--论文阅读1的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!