作者:禅与计算机程序设计艺术

1.简介

Apache Spark 是由 Apache 基金会开源的一款基于内存计算的分布式计算框架。通过它可以快速处理海量的数据并进行实时分析。由于 Spark 在处理实时的流数据方面的能力优势,越来越多的人开始采用 Spark 来开发流式应用程序。目前流计算领域也出现了一些流处理工具,如 Storm、Flink 和 Kafka Streams。但是这些工具都有自己独有的编程模型,并且支持的语言和生态系统不统一。因此,在这种情况下,Apache Spark Streaming(简称 SS)应运而生。SS 是 Apache Spark 中的一个模块,它提供了对实时流数据的高吞吐量、低延迟的处理。本文将详细阐述 SS 的背景、架构及特性,并结合实践案例,分享关于 SS 使用方法、原理及优化技巧等知识。

2.什么是 Spark Streaming?

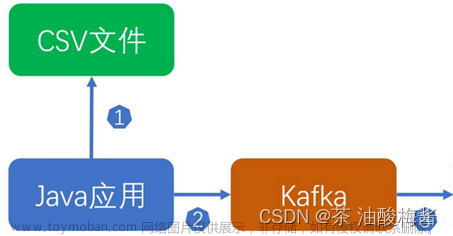

Spark Streaming 是 Apache Spark 中用于处理实时流数据(Streaming Data)的模块。它利用 Spark 的速度和容错性,能够同时从多个源头采集数据,并将数据批量或连续地传输到目标系统中。 Spark Streaming 提供了对实时数据的高吞吐量、低延迟的处理能力,适用于对实时数据进行分析、报告、搜索引擎、推荐引擎等应用场景。其架构如下图所示:文章来源:https://www.toymoban.com/news/detail-728468.html

Spark Streaming 模块由三个主要组件组成:文章来源地址https://www.toymoban.com/news/detail-728468.html

- 输入数据源:Spark Streaming 可以从多个数据源(比如 Kafka、Flume、Kinesis 等)读取数据。

- 数据接收器(Receiver):Receiver 从输入数据源读取数据并

到了这里,关于Spark Streaming 原理与实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!