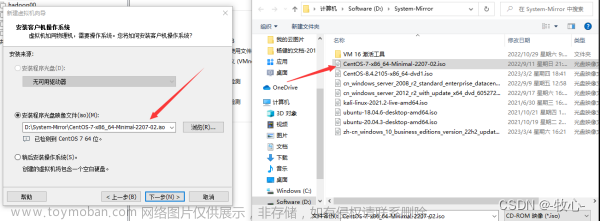

1、在vmware中更改了虚拟机的网络类型,--->NAT方式,(虚拟交换机的ip可以从vmvare的edit-->vertual network editor看到)

2、根据这个交换机(网关)的地址,来设置我们的客户端windows7的ip(Vmnet8这块网卡)

3、启动linux主机,修改linux系统的ip地址(通过图形界面修改),修改完成之后在terminal(命令行终端)中切换到root用户执行命令重启网络服务来让ip生效

4、修改主机名: 在root身份下,用命令修改 vi /etc/sysconfig/network 把hostname改为 yun-10-1

5、添加主机名和ip的映射 在root身份下 vi /etc/hosts 添加一行 192.168.2.100 yun-10-1

6、讲hadoop这个用户添加到sudoers里面去 在root身份下 vi /etc/sudoers ,在文件中找到 root ALL=ALL ALL ,下面加一行hadoop的

7、停止防火墙服务 在root身份下 service iptables stop

8、关闭防火墙的自动启动 在root身份下 chkconfig iptables off

9、reboot

10、用ping命令检测一下windows主机和linux服务器之间的网络连通性

11、进入linux修改图形界面启动配置,不要再启动图形界面了,在root身份下, vi /etc/inittab 将其改为id:3:initdefault:

12、再次reboot,将不会启动到图形界面了

(当以后你想启动图形界面的时候可以在命令行下敲startx (init 5) ,在图形界面下你想关闭图形界面,敲命令init 3)

===========华丽的分割线=============================

1/用终端连接linux服务器进行软件的安装(用secureCRT来连接)

2/安装jdk

--用filezilla工具上传jdk的压缩包

--解压jdk的压缩包到一个专门的安装目录下 /home/hadoop/app

--在hadoop的主目录下敲命令

tar -zxvf jdk-7u65-linux-i586.tar.gz -C ./app --配置java的环境变量 sudo vi /etc/profile

在文件的最后添加:

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_65

export PATH=$PATH:$JAVA_HOME/bin3/让配置生效, source /etc/profile

===========帅酷的分割线=============================

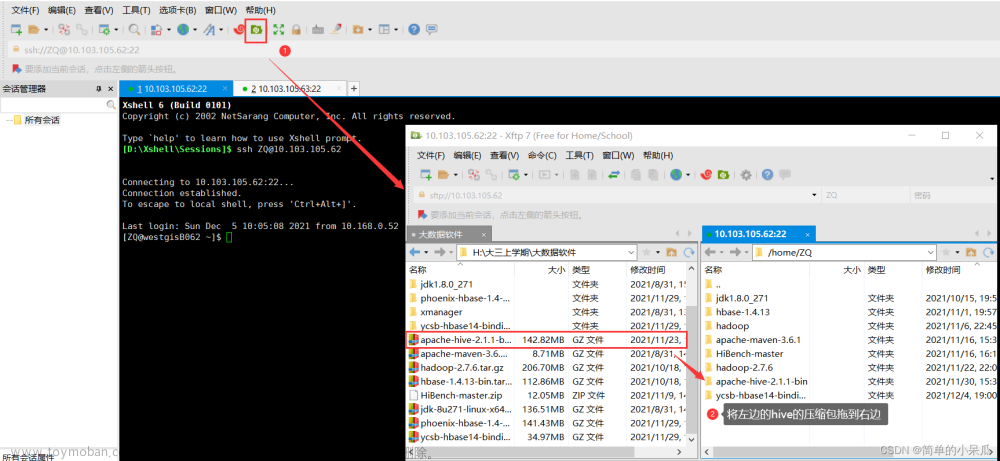

1/用filezilla工具上传hadoop的安装包

2/把hadoop解压到app目录中去

tar -zxvf hadoop-2.4.1.tar.gz -C ./app/

3/修改hadoop的5大配置文件,位置在 /home/hadoop/app/hadoop-2.4.1/etc/hadoop目录下

-- vi hadoop-env.sh 改其中的JAVA_HOME为我们安装jdk的路径

JAVA_HOME=/home/hadoop/app/jdk1.7.0_65-- vi core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://yun-10-1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/hadoop-2.4.1/tmp</value>

</property>

</configuration>-- vi hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

-- 先修改文件名 mv mapred-site.xml.template mapred-site.xml

在编辑 vi mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

-- vi yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>yun-10-1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

4/配置一下hadoop的环境变量

sudo vi /etc/profile

=============优美的分割线====================

1/无密登陆的配置

首先在客户端生成密钥对 ssh-keygen -t rsa 紧接着一直回车

然后在客户端拷贝公钥到远程 ssh-copy-id desthost

=========完美的分割线========hadoop安装完成========

学习资料下载:文章来源:https://www.toymoban.com/news/detail-728489.html

Hadoop-HDFS-Shell-学习资料及文档、Java代码文章来源地址https://www.toymoban.com/news/detail-728489.html

到了这里,关于Hadoop2复安装过程详细步骤的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!