目录

前言:

一.spark读出

1. spark 读出 MySQL表数据

1.2 spark 读出 ClickHouse表数据

二.spark写入

1. spark 写入 MySQL表数据

2.spark 写入 ClickHouse表数据

前言:

这篇文章主要记录的是用spark集成ClickHouse和MySQL,

将数据read出,和将数据write写入表的 (记录笔记)

创建sparkSession

因为这个不是重点,所以先简单创建下,实际是需要按照你的需求创建的

// 创建SparkSession

val spark = SparkSession.builder()

.appName("Write to MySQL")

.config("spark.sql.catalogImplementation", "hive")

.getOrCreate()一.spark读出

1. spark 读出 MySQL表数据

//读取数据

spark.read.format("jdbc")

.option("url","jdbc:mysql://address-ip:3306/ds_db01??characterEncoding=UTF-8") //url

.option("driver","com.mysql.jdbc.Driver") //驱动

.option("user","root") //用户名

.option("password","123456") //密码

.option("dbtable","product_info") //表

.load().createOrReplaceTempView("v")

spark.sql("select * from v") //查询1.2 spark 读出 ClickHouse表数据

// 以jdbc为连接方式进行连接clickhouse

val frame = sc.read.format("jdbc")

.option("driver","ru.yandex.clickhouse.ClickHouseDriver" )// 配置driver

.option("url", "jdbc:clickhouse:/address-ip:8123/shtd_result")// 配置url

.option("dbtable", "cityavgcmpprovince")

.option("user", "default")

.option("password", "123456")

.load()二.spark写入

1. spark 写入 MySQL表数据

// 将数据写入MySQL表

processedData.write

.format("jdbc")

.option("driver", "com.mysql.jdbc.Driver")

.option("url", "jdbc:mysql://mysql-host:3306/database")

.option("dbtable", "mysql_table")

.option("user", "username")

.option("password", "password")

.mode(SaveMode.Append)

.save()2.spark 写入 ClickHouse表数据

// 将数据写入ClickHouse表

processeData.write

.format("jdbc")

.option("driver", "ru.yandex.clickhouse.ClickHouseDriver")

.option("url", "jdbc:clickhouse://clickhouse-host:8123/database")

.option("dbtable", "clickhouse_table")

.option("user", "username")

.option("password", "password")

.mode(SaveMode.Append)

.save()processedData:代表你处理好的数据的DataFrame对象。

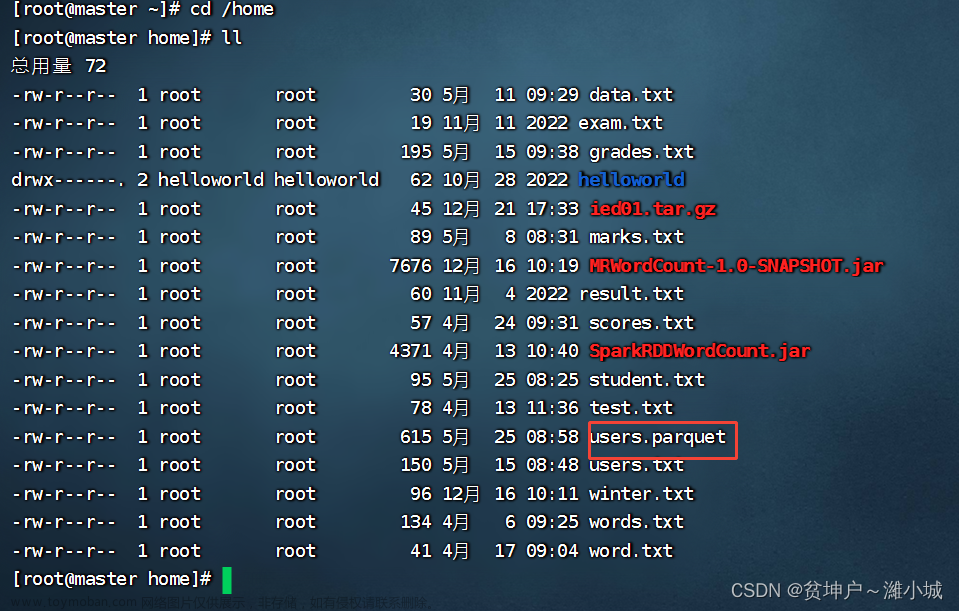

path/to/processedData.parquet:代表你处理好的数据的存储路径,可以是Parquet、CSV等格式。

mysql-host:代表MySQL数据库的主机名或IP地址。

database:代表MySQL数据库的名称。

mysql_table:代表要写入的MySQL表的名称。

username:代表连接MySQL所需的用户名。

password:代表连接MySQL所需的密码mode参数

1. SaveMode.Append:将新数据追加到目标表的末尾。如果表不存在,则创建一个新表并保存数据。

2. SaveMode.Overwrite:完全覆盖目标表的数据。如果表不存在,则创建一个新表并保存数据。

3. SaveMode.ErrorIfExists:如果目标表已经存在,则抛出一个错误。用于避免意外地覆盖已有数据。

4. SaveMode.Ignore:如果目标表已经存在,则忽略保存操作,不做任何处理。文章来源:https://www.toymoban.com/news/detail-729722.html

这些参数用于指定保存数据时的行为。根据具体的需求,选择合适的保存模式可以确保数据正确地保存到目标表中,同时避免意外覆盖或丢失数据。文章来源地址https://www.toymoban.com/news/detail-729722.html

到了这里,关于spark 集成 ClickHouse 和 MySQL (读和写操作)(笔记)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!