问题描述

RuntimeError: FlashAttention is only supported on CUDA 11 and above

解决方案

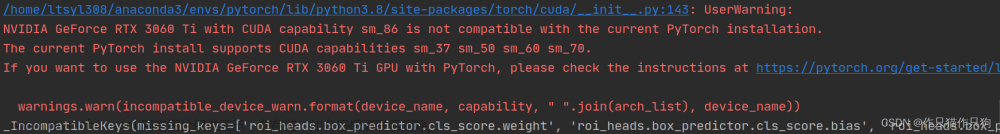

此错误的原因可能是 nvcc 的 CUDA 版本(通过键入“nvcc -V”获得,可能 < 11.0)与 torch (11.7) 的 CUDA 版本不匹配。

类似问题在这里解决:

https://stackoverflow.com/questions/40517083/multiple-cuda-versions-on-machine-nvcc-v-confusion

我解决了这个问题通过:

首先:

vim ~/.bashrc

在最后一行加上:

export PATH=/usr/local/cuda-11.7/bin:$PATH

然后:文章来源:https://www.toymoban.com/news/detail-729892.html

source ~/.bashrc

注意这里的cuda-11.7需要依据自己电脑或者服务器上面的版本来改,找到/usr/local目录下来看。改成自己需要的版本。

感谢:

参考1

的haoychen3的帮助。文章来源地址https://www.toymoban.com/news/detail-729892.html

到了这里,关于RuntimeError: FlashAttention is only supported on CUDA 11 and above的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

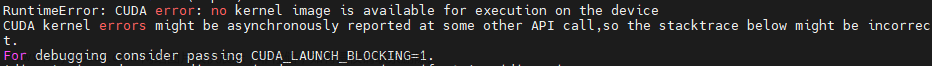

![[已解决]RuntimeError: CUDA error: no kernel image is available for execution on the device](https://imgs.yssmx.com/Uploads/2024/02/782952-1.png)