一、简介

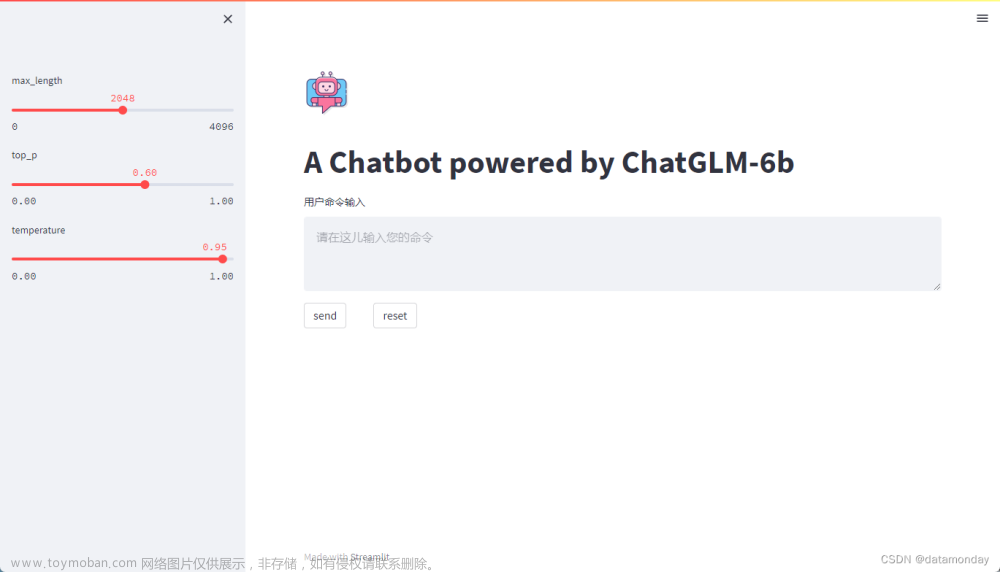

本项目是一个基于GPT-3.5模型的聊天机器人网站,旨在为用户提供一个简便、直接的方式来体验和利用GPT-3.5模型的强大功能。项目以Flask为基础,构建了一个完整的Web应用程序,其中包含了多个前端页面和后端API接口,能够处理用户输入并与GPT-3.5模型进行交互来生成响应。

一个显著的特点是,该项目可以在国内环境下无障碍访问,无需借助任何形式的科学上网工具。这得益于项目的服务器和API都配置在国内,确保了用户可以顺畅、无延迟地使用该服务。用户只需在settings.py文件中配置自己的API信息,便可以快速启动和使用项目。

此外,该项目不仅可以作为一个学习工具,帮助用户更好地了解和学习GPT-3.5模型和Web开发技术,还提供了丰富的扩展可能性。开发者可以在此项目的基础上,继续开发和扩展更多的功能和服务,打造出更加强大和个性化的聊天机器人应用。

项目的代码结构清晰,分模块设计,使得代码易于理解和维护。它包括了一个用户管理系统,可以实现用户的注册和登录功能,还有一个留言板功能,允许用户留下他们的反馈和建议。项目还包含了Docker和Nginx的配置文件,可以帮助用户更方便地部署和管理项目。

在使用该项目前,我们推荐用户有一些Python和Web开发的基本知识,以便更好地理解和利用项目的功能。同时,项目的README.md文件也提供了详细的部署和使用指南,可以帮助用户快速上手和使用项目。

总的来说,该项目是一个功能强大、易于扩展的GPT-3.5聊天机器人应用,可以为用户提供一个简便、高效的方式来体验GPT-3.5模型的强大功能,同时也为开发者提供了一个良好的基础,帮助他们快速构建和部署自己的聊天机器人应用。

二、项目介绍

1. 项目目录结构

本项目的目录结构组织清晰,分模块设计,便于开发和维护。下面我们来详细介绍每个文件和目录的功能和用途:

chat-gpt-website-master/

│ ├── app.py

│ ├── docker-compose.yml

│ ├── Dockerfile

│ ├── LICENSE

│ ├── models.py

│ ├── nginx.conf

│ ├── README.md

│ ├── requirements.txt

│ ├── settings.py

│ └── test.html

│

├── .idea/

│ ├── .gitignore

│ ├── chat-gpt-website-master - v2.iml

│ ├── chat-gpt-website-master.iml

│ ├── deployment.xml

│ ├── misc.xml

│ ├── modules.xml

│ ├── workspace.xml

│ └── inspectionProfiles/

│ └── profiles_settings.xml

│

├── pycache/

│ ├── app.cpython-38.pyc

│ └── models.cpython-38.pyc

│

├── static/

│ ├── css/

│ │ ├── bootstrap.min.css

│ │ ├── github-dark-dimmed.min.css

│ │ ├── style.css

│ │ └── login_css/

│ │ └── normalize.css

│ ├── font-awesome/

│ │ ├── css/

│ │ │ └── font-awesome.min.css

│ │ └── fonts/

│ │ ├── fontawesome-webfont.eot

│ │ ├── fontawesome-webfont.svg

│ │ ├── fontawesome-webfont.ttf

│ │ ├── fontawesome-webfont.woff

│ │ ├── fontawesome-webfont.woff2

│ │ └── FontAwesome.otf

│ ├── images/

│ │ ├── avatar.png

│ │ ├── chatgpt.png

│ │ ├── fail.png

│ │ ├── favicon.ico

│ │ ├── login_background.jpg

│ │ ├── reward.jpg

│ │ ├── reward.png

│ │ └── ╬ó╨┼╢■╬¼┬δ├√╞¼.jpg

│ └── js/

│ ├── bootstrap.min.js

│ ├── custom.js

│ ├── highlight.min.js

│ ├── html2canvas.min.js

│ ├── jquery-2.1.1.js

│ ├── marked.min.js

│ └── login_js/

│ ├── index.js

│ └── prefixfree.min.js

│

└── templates/

├── chat.html

├── console.html

├── login.html

└── recharge.html

-

.idea: 此目录包含项目的IDE配置文件(通常是PyCharm或其他JetBrains IDE),用于存储项目的配置和设置信息。 -

__pycache__: 此目录存储Python的字节编译文件,这些文件是Python在执行时自动生成的,可以提高程序的启动速度。 -

app.py: 此文件是项目的核心文件,包含了项目的所有路由和视图函数。它负责处理用户的请求和响应,并与GPT-3.5模型进行交互。 -

docker-compose.yml: 此文件包含Docker Compose的配置信息,用于帮助用户快速部署和启动项目的所有服务。 -

Dockerfile: 此文件包含Docker的配置信息,描述了如何构建项目的Docker镜像。 -

LICENSE: 此文件包含项目的许可证信息,通常用于描述项目的开源许可证。 -

models.py: 此文件包含项目的数据模型定义,包括用户模型和留言板模型,用于与数据库交互。 -

nginx.conf: 此文件包含Nginx的配置信息,用于设置Web服务器的行为和属性。 -

README.md: 此文件包含项目的基本信息和使用指南,可以帮助用户快速了解和上手项目。 -

requirements.txt: 此文件列出了项目的所有Python依赖,可以通过pip install -r requirements.txt命令快速安装所有依赖。 -

settings.py: 此文件包含项目的配置信息,包括数据库连接信息和OpenAI API的密钥。 -

static: 此目录存储项目的静态文件,如CSS样式表和JavaScript脚本。 -

templates: 此目录存储项目的HTML模板文件,用于生成动态的Web页面。 -

test.html: 此文件是一个测试用的HTML文件,用于测试项目的某些功能。

每个文件和目录都有其特定的用途和功能,共同构成了一个完整的项目。在后续的“代码详解”部分,我们将更加深入地探讨每个文件的具体内容和代码。

2、代码地址

基于flask+html+css+js+mysql实现gpt3.5模型项目文章来源:https://www.toymoban.com/news/detail-731099.html

项目运行地址https://3t1c008963.imdo.co/文章来源地址https://www.toymoban.com/news/detail-731099.html

到了这里,关于搭建部署属于自己的基于gpt3.5的大语言模型(基于flask+html+css+js+mysql实现)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!