-

南洋理工大学、鹏城实验室、香港理工大学在ICCV2023发表的暗图增强论文。用diffusion模型来进行raw图像暗图增强,同时提出了一个自适应的残差层用来对具有不同信噪比的不同区域采取不同的去噪策略。

-

方法的框图如下所示:

-

一张raw图片可以由信号和噪声组成,其中信号是曝光时间、增益和场景光子转化为电子数量三者乘积,噪声是由服从泊松分布的散粒噪声和与信号相独立的噪声的加和:

-

文章定义暗图增强的目标为从一张 λ t = λ T \lambda_t=\lambda_T λt=λT的暗图 X T X_T XT恢复出一张 λ t = λ 0 > λ T \lambda_t=\lambda_0>\lambda_T λt=λ0>λT的正常曝光的图片 X 0 X_0 X0。套用到diffusion的扩散过程,exposure diffusion就是将正常曝光的图片作为 X 0 X_0 X0,将暗图作为 X T X_T XT,用网络来模拟从 X t X_{t} Xt到 X t − 1 X_{t-1} Xt−1的反向过程,从而实现对暗图的增强,如下图所示:

-

与一般diffusion model不同的是,exposure diffusion的目标函数是网络预测的分布和实际分布的KL散度的一个上界:

-

转移函数用的是如下公式,其中P是泊松分布:

而损失函数其实也很简单,如下:

其中 F Θ F_\Theta FΘ如下所示

其中 X ^ \hat X X^和 R ^ \hat R R^分别是对正常光照的图像 X r e f X_{ref} Xref和 残差 R R R的预测值, M M M也是预测的一个soft的mask

-

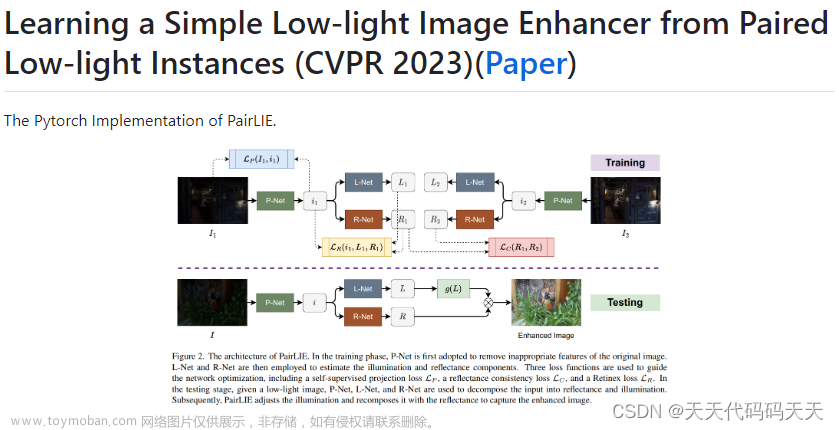

所以其实整体流程上,就暗图增强任务,这篇论文并没有提出一个暗图增强的网络结构,可以用任何现有的暗图增强网络的网络结构来实现,本文只是利用diffusion理论和自己的一些公式推导,提出了一个训练框架,把现有网络的输出接一个卷积层预测X M R三个分量,然后用本文推导的输入和损失函数来训练这个网络,最终使得这个网络的输出配合diffusion的公式和上面的公式(12)能够得到raw image的增强结果:

-

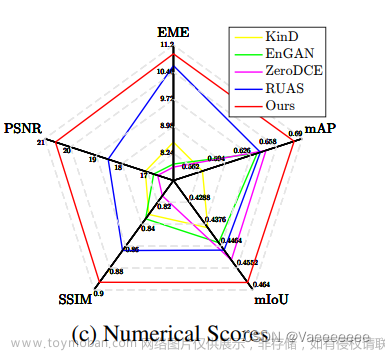

实验结果看,用本文的方法,确实是可以提高网络在raw image上进行暗图增强的性能:

-

但是,个人感觉文章藏了一些东西,比如,明明table给出了不同模型的parameters flops inference time,顺手就可以在下面给出改进后模型的inference time进行对比看看增加了多少,它偏不,非要在table4给出个图,说small model的改进版本是larger model的25%的parameters 和FLOPs而获得了更好的性能(注意,这里就不提inference time,只说小模型用iteration number of 3可以比大模型更快,但是你这里获得更好的性能用的是iteration number of 3 吗?),这种拐弯抹角的方式不得不让我怀疑其实是在隐藏这一改进由于inference需要进行iteration会使得inference time翻很多倍的事实:

文章来源:https://www.toymoban.com/news/detail-734045.html

文章来源:https://www.toymoban.com/news/detail-734045.html -

评价:本身把diffusion和暗图增强这个任务进行了很好的结合,我应该给出很好的评价的。但是对inference time藏着掖着的态度让我又有了点降分。总而言之是一篇很好的文章,个人认为是目前为止看到的用diffusion model做暗图增强做得算好的了,在用diffusion 的框架进行暗图增强的训练的方向上做了一个理论上比较有说服力的工作。文章来源地址https://www.toymoban.com/news/detail-734045.html

到了这里,关于ExposureDiffusion: Learning to Expose for Low-light Image Enhancement论文阅读笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![elastic安装报错:max file descriptors [4096] for elasticsearch process is too low, increase to at least](https://imgs.yssmx.com/Uploads/2024/02/515962-1.png)