Jsoup库是一款Java的HTML解析器,可用于从网络或本地文件中获取HTML文档并解析其中的数据。它可以模拟浏览器的行为,获取网页中的数据,是Java爬虫中常用的工具之一。与浏览器相比,Jsoup库的主要区别在于它不会执行JavaScript代码,因此无法获取通过JavaScript生成的内容。

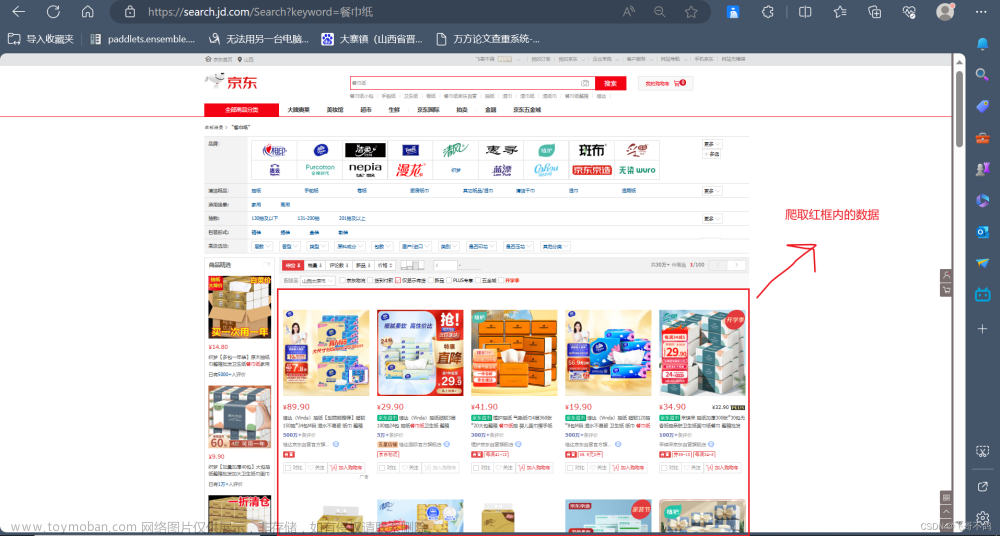

使用Jsoup库进行爬虫,一般需要以下步骤:

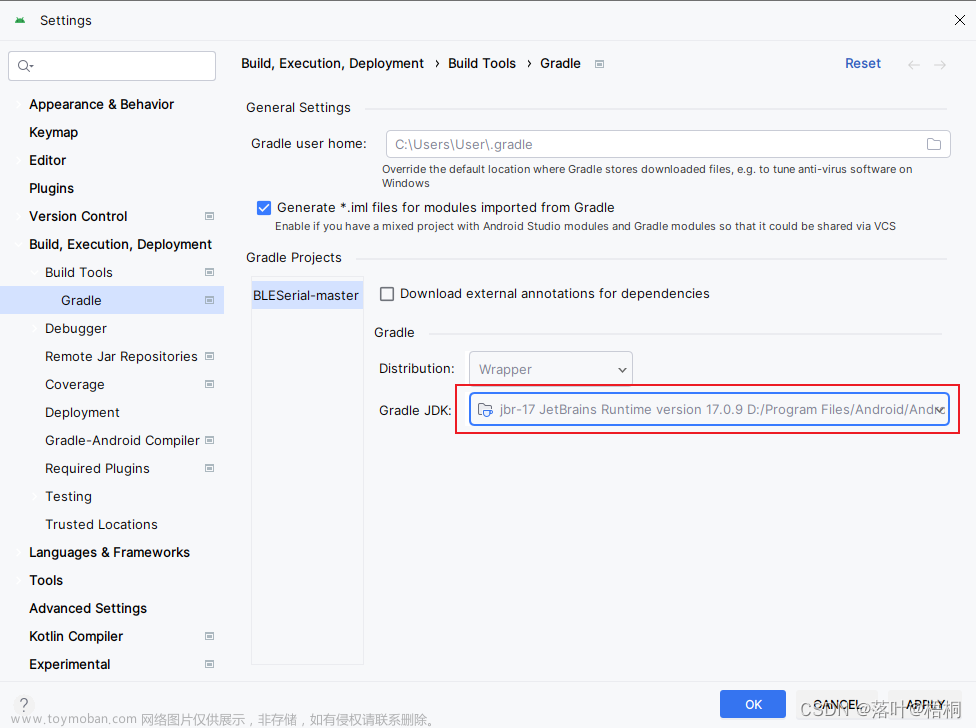

1、导入Jsoup库。

2、构造一个连接对象,指定要爬取的URL地址。

3、发送请求,获取HTML文档。

4、解析HTML文档,获取需要的数据。

以下是一个使用Jsoup库进行爬虫的示例代码:文章来源:https://www.toymoban.com/news/detail-736122.html

// 导入Jsoup库

import org.jsoup.Jsoup

import org.jsoup.nodes.Document

import org.jsoup.nodes.Element

import org.jsoup.select.Elements

fun main() {

// 创建爬虫ip对象

val proxy = Proxy/host/"duoip"/port/8000

// 创建Jsoup对象,指定使用爬虫ip

val jsoup = Jsoup.connect("https://www.pitu.com/")

.userAgent("Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3")

.proxy(proxy)

.get()

// 获取网页内容

val content = jsoup.body()

// 打印网页内容

println(content)

}

上述代码使用Jsoup库创建一个爬虫ip对象,并使用该爬虫ip对象创建一个Jsoup对象。然后使用该Jsoup对象连接到指定的网址,指定User-Agent和Proxy,并获取网页内容。最后,打印获取的网页内容。文章来源地址https://www.toymoban.com/news/detail-736122.html

到了这里,关于Java导入Jsoup库做一个有趣的爬虫项目的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!