这篇文章的基础是《Windows上快速部署Vitis HLS OpenCV仿真库》,我们使用的版本是Vitis HLS 2022.2,其他版本BUG不清楚,目前已知2021版本有BUG,只能使用其他方式,本文不适合。

这次选择中值滤波这个常规算法作为演示算法。

算法原理

算法原理很简单,我们先介绍均值滤波,因为线性滤波的基础是均值滤波,中值滤波是在这个基础上发展过来的。

均值滤波

图像均值滤波是一种基本的图像平滑处理方法,也被称为“盒子滤波”或“平滑滤波”。它的主要思想是对图像中的每个像素取一个局部均值,以降低图像噪声和细节对图像边缘检测和其他计算机视觉算法的影响。

具体来说,图像均值滤波涉及在图像中移动一个固定尺寸的窗口,例如 的窗口。对于每个窗口,计算窗口内所有像素的平均值,并将该值分配给窗口中心的像素。这个过程将重复应用于整个图像,用于生成平滑的输出图像。

在进行图像处理时,一张图片可以看做一个矩阵,假设有个6x6图片,如下:

处理内核如下:

动画演示处理过程如下:

图片演示:

特点

-

具有非常不具代表性的值的单个像素会显着影响其邻域中所有像素的平均值。

-

当滤波器邻域跨越边缘时,滤波器将为边缘上的像素插入新值,从而模糊该边缘。如果输出中需要尖锐的边缘,这可能是个问题。

这两个问题都由中值滤波器解决,中值滤波器通常是比均值滤波器更好的降噪滤波器,但计算时间更长。

通常,均值滤波器充当低通频率滤波器 ,因此减少了图像中存在的空间强度导数。

上图描绘了一个包含更广泛不同空间频率的场景。用 3×3 均值滤波器平滑一次后,我们得到

背景中的低空间频率信息并未受到过滤的显着影响,但前景对象的(曾经清晰的)边缘已被明显平滑。用 7×7 均值滤波器过滤后,得到下图

将此结果与通过在原始图像上传递 3×3 均值滤波器三次获得的结果进行比较

上两图说明一个问题:对一幅图像应用大窗口的滤波器和应用多次小窗口滤波器效果差不多。

常见变体

此处讨论的均值平滑滤波器的变体包括:阈值平均,其中仅当其原始值与平均值之间的差大于预设阈值时才改变中心像素值的条件下应用平滑。这具有平滑噪声的效果,图像细节的损失较小。

其他不计算邻域均值的卷积滤波器也经常用于平滑。其中最常见的一种是高斯平滑滤波器。

中值滤波

图像中值滤波是一种常用的非线性滤波方法,也被称为排序滤波器。它的主要原理是将图像中每个像素周围的像素排序,并将排序后的中间值作为该像素的输出值。

中值滤波可以有效地抑制图像中的噪声,同时保留图像中细节和边缘信息。相对于其他线性滤波器(如均值滤波器),它可以在更好地去除噪声的同时保留图像的细节和边缘上提供更好的性能。

具体地,对于每个像素,中值滤波器会包括 个邻域像素,其中 和 是正奇数。它们将以该像素为中心构成一个矩形窗口或一个圆形窗口。

窗口大小是中值滤波器的重要参数。在选择窗口大小时,应该考虑噪声的特性以及需要保留的图像细节。通常情况下,窗口大小越大,中值滤波器能够去除的噪声越大,但也会导致图像模糊。

然后,对于每个像素,将邻域像素按灰度值进行排序,取排序后的中间值作为该像素的输出值。这个输出值将取代原始图像中的像素值,从而产生一个平滑且噪声减少的图像。

中值滤波器的优点是它可以在去除噪声的同时保留图像中的边缘和细节,但它的缺点是计算成本较高,并且可能导致图像的细节丢失。此外,当噪声水平很高时,这种滤波器可能无法完全去除噪声。

所有平滑技术都可以有效去除信号平滑块或平滑区域中的噪声,但会对边缘产生不利影响。通常,在降低信号噪声的同时,保留边缘也很重要。例如,边缘对于图像的视觉特性至关重要。对于小到中等水平的高斯噪声,中值滤波器在去除噪声方面明显优于高斯滤波,同时为给定的固定窗口大小保留边缘。然而,对于高水平的噪声,它的性能并不比高斯模糊好多少,而对于散斑噪声和椒盐噪声(脉冲噪声),它特别有效。正因为如此,中值滤波在数字图像处理中得到了非常广泛的应用。

OpenCV实现

使用OpenCV进行算法验证和Matlab进行算法验证其实思路差不多,先验证算法的效果再验证算法的正确性,这一步使用OpenCV和MatLab一样,我们就使用OpenCV进行验证,这一步就不实际展开了,代码如下:

//-----------------------------------【头文件包含部分】---------------------------------------

// 描述:包含程序所依赖的头文件

//----------------------------------------------------------------------------------------------

#include "opencv2/core/core.hpp"

#include "opencv2/highgui/highgui.hpp"

#include "opencv2/imgproc/imgproc.hpp"

//-----------------------------------【命名空间声明部分】---------------------------------------

// 描述:包含程序所使用的命名空间

//-----------------------------------------------------------------------------------------------

using namespace cv;

//-----------------------------------【main( )函数】--------------------------------------------

// 描述:控制台应用程序的入口函数,我们的程序从这里开始

//-----------------------------------------------------------------------------------------------

int main()

{

// 载入原图

Mat image = imread("1.jpg");

//创建窗口

namedWindow("中值滤波【原图】");

namedWindow("中值滤波【效果图】");

//显示原图

imshow("中值滤波【原图】", image);

//进行中值滤波操作

Mat out;

medianBlur(image, out, 7);

//显示效果图

imshow("中值滤波【效果图】", out);

waitKey(0);

}

HLS加速和仿真

上面就完成了算法的介绍和论证,其中论证过程并没有详细介绍,因为本篇文章重点不是这个,后续在介绍这个算法的时候再详细展开。

HLS工程搭建

新建工程

如下:

第二页和第三页不用管,后续再进行设置

最后一页,需要设置两个地方,注意一个地方

其中,Uncertainty参数含义见下,默认不设置即可。

在UG1399的set_clock_uncertainty章节有详细介绍。

【uncertainty】:以 ns 为单位指定,表示时钟周期中有多少被用作余量。不确定性也可以指定为时钟周期的百分比。默认的不确定性是时钟周期的 27%。

也可以使用函数:

set_clock_uncertainty <uncertainty> <clock_list>【uncertainty】:以 ns 为单位指定,表示时钟周期中有多少被用作余量。不确定性也可以指定为时钟周期的百分比。默认的不确定性是时钟周期的 27%。

【clock_list】:应用不确定性的时钟列表。如果未提供,它将应用于所有时钟。

添加源文件

新建xf_median_blur_accel.cpp

#include "xf_median_blur_config.h"

static constexpr int __XF_DEPTH = (HEIGHT * WIDTH * (XF_PIXELWIDTH(TYPE, NPC1)) / 8) / (PTR_WIDTH / 8);

void median_blur_accel(ap_uint<PTR_WIDTH>* img_in, int rows, int cols, ap_uint<PTR_WIDTH>* img_out) {

// clang-format off

#pragma HLS INTERFACE m_axi port=img_in offset=slave bundle=gmem0 depth=__XF_DEPTH

#pragma HLS INTERFACE m_axi port=img_out offset=slave bundle=gmem1 depth=__XF_DEPTH

#pragma HLS INTERFACE s_axilite port=rows bundle=control

#pragma HLS INTERFACE s_axilite port=cols bundle=control

#pragma HLS INTERFACE s_axilite port=return bundle=control

// clang-format on

xf::cv::Mat<TYPE, HEIGHT, WIDTH, NPC1, XF_CV_DEPTH_IN> imgInput(rows, cols);

xf::cv::Mat<TYPE, HEIGHT, WIDTH, NPC1, XF_CV_DEPTH_OUT> imgOutput(rows, cols);

// clang-format off

#pragma HLS DATAFLOW

// clang-format on

// Retrieve xf::cv::Mat objects from img_in data:

xf::cv::Array2xfMat<PTR_WIDTH, TYPE, HEIGHT, WIDTH, NPC1, XF_CV_DEPTH_IN>(img_in, imgInput);

// Run xfOpenCV kernel:

xf::cv::medianBlur<WINDOW_SIZE, XF_BORDER_REPLICATE, TYPE, HEIGHT, WIDTH, NPC1, XF_CV_DEPTH_IN, XF_CV_DEPTH_OUT>(

imgInput, imgOutput);

// Convert _dst xf::cv::Mat object to output array:

xf::cv::xfMat2Array<PTR_WIDTH, TYPE, HEIGHT, WIDTH, NPC1, XF_CV_DEPTH_OUT>(imgOutput, img_out);

return;

} // End of kernel添加仿真文件

新建xf_median_blur_tb.cpp

#include "common/xf_headers.hpp"

#include "xf_median_blur_config.h"

int main(int argc, char** argv) {

if (argc != 2) {

fprintf(stderr, "Usage: %s <INPUT IMAGE PATH 1>", argv[0]);

return EXIT_FAILURE;

}

cv::Mat in_img, out_img, ocv_ref, diff;

// Reading in the image:

#if GRAY

in_img = cv::imread(argv[1], 0); // reading in the gray image

#else

in_img = cv::imread(argv[1], 1); // reading in the color image

#endif

if (in_img.data == NULL) {

fprintf(stderr, "ERROR: Cannot open image %s\n ", argv[1]);

return EXIT_FAILURE;

}

// create memory for output image

#if GRAY

ocv_ref.create(in_img.rows, in_img.cols, CV_8UC1);

out_img.create(in_img.rows, in_img.cols, CV_8UC1); // create memory for output image

diff.create(in_img.rows, in_img.cols, CV_8UC1);

#else

ocv_ref.create(in_img.rows, in_img.cols, CV_8UC3);

out_img.create(in_img.rows, in_img.cols, CV_8UC3); // create memory for output image

diff.create(in_img.rows, in_img.cols, CV_8UC3);

#endif

// OpenCV reference:

cv::medianBlur(in_img, ocv_ref, WINDOW_SIZE);

// OpenCL section:

#if GRAY

size_t image_in_size_bytes = in_img.rows * in_img.cols * 1 * sizeof(unsigned char);

#else

size_t image_in_size_bytes = in_img.rows * in_img.cols * 3 * sizeof(unsigned char);

#endif

size_t image_out_size_bytes = image_in_size_bytes;

// Call the top function

median_blur_accel((ap_uint<PTR_WIDTH>*)in_img.data, in_img.rows, in_img.cols, (ap_uint<PTR_WIDTH>*)out_img.data);

// Write down output images:

cv::imwrite("hls_out.jpg", out_img); // kernel output

cv::imwrite("ref_img.jpg", ocv_ref); // reference image

absdiff(ocv_ref, out_img, diff);

// Save the difference image for debugging purpose:

cv::imwrite("error.png", diff);

float err_per;

xf::cv::analyzeDiff(diff, 10, err_per);

if (err_per > 0.0f) {

fprintf(stderr, "ERROR: Test Failed.\n ");

return 1;

} else

std::cout << "Test Passed " << std::endl;

return 0;

}设置仿真库

在下面界面设置相关参数:

在这个界面设置

1、Top Function

设置主函数的,点击Browse进行选择即可。

2、设置设计文件Edit cflags,添加调用的设计头文件

添加

-I E:/vitis_hls_image/Vitis_Libraries-2020.2/Vitis_Libraries-2020.2/vision/L1/include -std=c++0x -I H:/FILE/HLS/meanblur/src/build -I./. -D__SDSVHLS__ -std=c++0x3、设置设计文件Edit csimflags

-I E:/vitis_hls_image/Vitis_Libraries-2020.2/Vitis_Libraries-2020.2/vision/L1/include -std=c++0x -I H:/FILE/HLS/meanblur/src/build -I./. -D__SDSVHLS__ -std=c++0x接下来设置仿真库路径

1、设置仿真文件Edit cflags

-I E:/vitis_hls_image/opencv_lib/opencv/build_2/install/include -I E:/vitis_hls_image/Vitis_Libraries-2020.2/Vitis_Libraries-2020.2/vision/L1/include -I H:/FILE/HLS/meanblur/src/build -I. -std=c++0x -D__SDSVHLS__ -std=c++0x2、设置仿真文件Edit csimflags

-I E:/vitis_hls_image/opencv_lib/opencv/build_2/install/include -I E:/vitis_hls_image/Vitis_Libraries-2020.2/Vitis_Libraries-2020.2/vision/L1/include -I H:/FILE/HLS/meanblur/src/build -I. -std=c++0x -D__SDSVHLS__ -std=c++0x3、设置Linker Flags,调用OpenCV库文件

-L E:/vitis_hls_image/opencv_lib/opencv/build_2/install/x64/mingw/lib -llibopencv_imgcodecs455 -llibopencv_imgproc455 -llibopencv_core455 -llibopencv_highgui455 -llibopencv_flann455 -llibopencv_features2d4554、 设置Input Arguments,这个是调用仿真图片,可以后续再设置

H:/FILE/HLS/meanblur/src/128x128.png综合

点击综合按钮即可开始综合,结果如下:

仿真

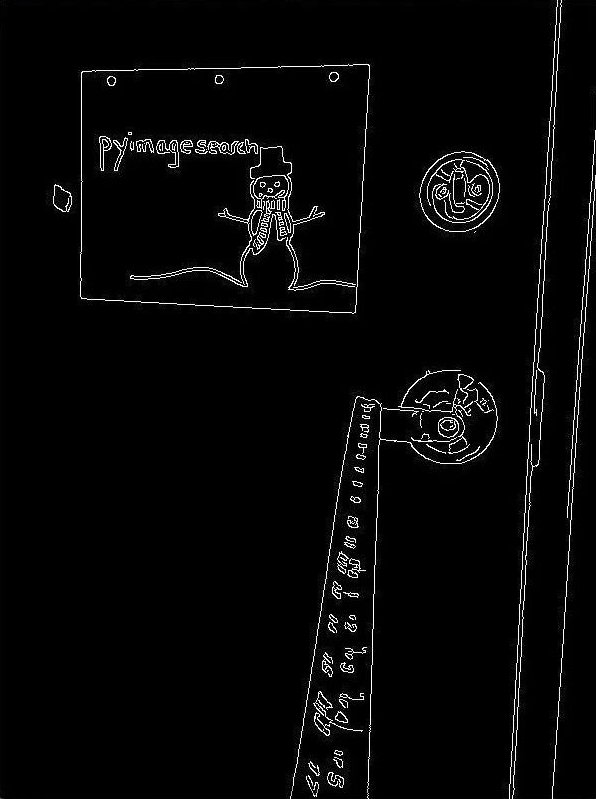

点击仿真按钮得到下图仿真结果,原始图像如下:

下图从左到右分别为:OpenCV处理的结果、HLS处理的结果以及最后的两个图像差(无差别即全黑)。

联合仿真

点击联合仿真按钮后等待仿真结束,然后点击下面按钮查看波形:

导出IP

点击导出IP按钮等待导出即可。文章来源:https://www.toymoban.com/news/detail-739130.html

总结

今天的例程演示完毕,从建立工程到最后导出IP,基本比较详细。但是,上面的例程是不能直接应用到视频里的,原因是上面的接口没经过改动,需要从AXI转成AXI-STREAM接口后再再接入到视频架构中即可,这部分我们后续再详细说明。文章来源地址https://www.toymoban.com/news/detail-739130.html

到了这里,关于如何用 Vitis HLS 实现 OpenCV 仿真的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!