1. 激活函数

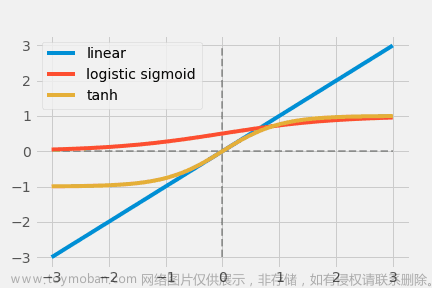

1. 神经网络中的每个神经元节点接受上一层神经元的输出值作为本神经元的输入值,并将输入值传递给下一层,输入层神经元节点会将输入属性值直接传递给下一层(隐层或输出层)。在多层神经网络中,上层节点的输出和下层节点的输入之间具有一个函数关系,这个函数称为激活函数(又称激励函数)。

2. 线性的表达能力太有限了,如果不用激励函数(其实相当于激励函数是 f ( x ) = x f(x) = x f(x)=x ),在这种情况下你每一层节点的输入都是上层输出的线性函数,很容易验证,即使经过多层网络的叠加,输出都是输入的线性组合,与没有隐藏层效果相当。激活函数的作用:激活函数是用来加入非线性因素的,因为线性模型的表达能力不够,引入非线性函数作为激励函数,这样深层神经网络表达能力就更加强大(不再是输入的线性组合,而是几乎可以逼近任意函数)。

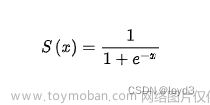

2. Sigmoid函数

S i g m o i d Sigmoid Sigmoid 函数是一种常用的激活函数,它将输入映射到一个介于 0 0 0 和 1 1 1 之间的值。它的公式和图像如下所示:

3. RelU函数

R e L U ReLU ReLU 函数是一种非常简单和有效的激活函数。它的公式和图像如下所示:

4. Softmax函数

S o f t m a x Softmax Softmax 函数是一种用于多分类问题的激活函数。它将输入映射到一个概率分布上,使得所有输出值之和为 1 1 1。 S o f t m a x Softmax Softmax 函数的公式如下所示:文章来源:https://www.toymoban.com/news/detail-740737.html

文章来源地址https://www.toymoban.com/news/detail-740737.html

文章来源地址https://www.toymoban.com/news/detail-740737.html

到了这里,关于最常见的激活函数的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[深度学习入门]什么是神经网络?[神经网络的架构、工作、激活函数]](https://imgs.yssmx.com/Uploads/2024/02/584734-1.png)