在Flink程序中,可以通过设置日志级别来控制控制台输出的信息。要让控制台只打印结果信息,可以将日志级别设置为ERROR。这样,只有错误信息和print()方法输出的结果会显示在控制台上。

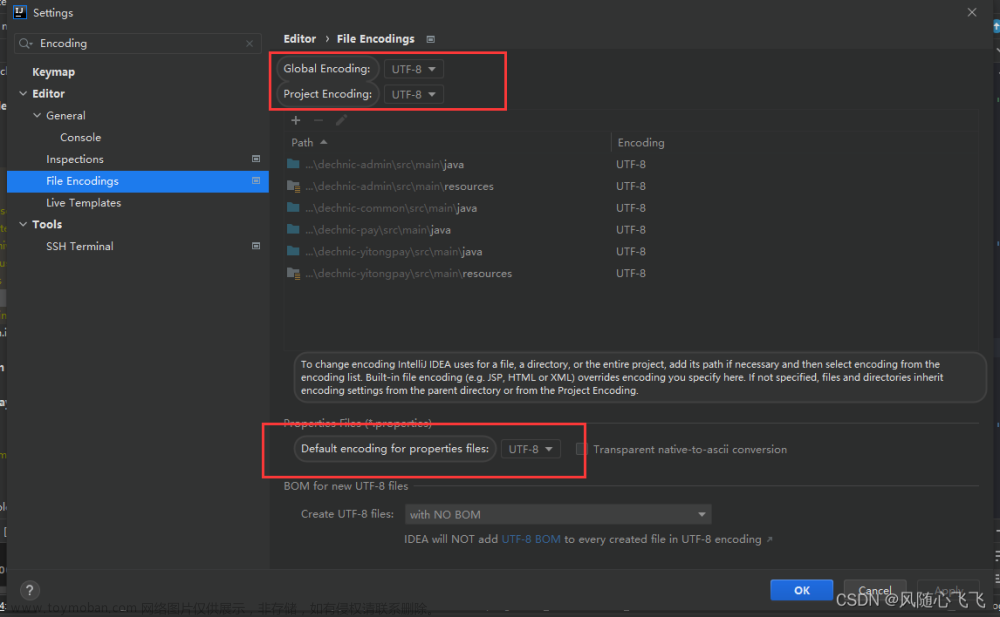

要设置日志级别,请在Flink项目的resources目录下创建一个名为log4j.properties的文件(如果已经存在,请修改相应的配置)。将以下内容添加到log4j.properties文件中:

log4j.rootLogger=ERROR, console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L - %m%n

这将把日志级别设置为ERROR,并将日志输出到控制台。在这种配置下,控制台将只显示错误信息和print()方法输出的结果。

注意:如果项目中使用的是logback而不是log4j,则需要创建或修改logback.xml文件,如下所示:文章来源:https://www.toymoban.com/news/detail-741023.html

<configuration>

<appender name="console" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss} %-5level %logger{36} - %msg%n</pattern>

</encoder>

</appender>

<root level="ERROR">

<appender-ref ref="console" />

</root>

</configuration>

这将把日志级别设置为ERROR,并将日志输出到控制台。在这种配置下,控制台将只显示错误信息和print()方法输出的结果。文章来源地址https://www.toymoban.com/news/detail-741023.html

到了这里,关于如何控制Flink代码运行时控制日志级别的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!