一、工具介绍

logrotate是一个linux系统日志的管理工具。可以对单个日志文件或者某个目录下的文件按时间/大小进行切割,压缩操作;指定日志保存数量;还可以在切割之后运行自定义命令。

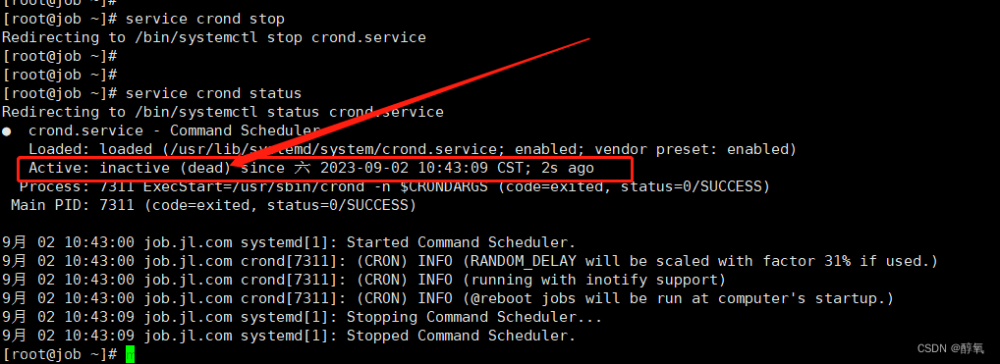

logrotate是基于crontab运行的,所以这个时间点是由crontab控制的,具体可以查询crontab的配置文件/etc/anacrontab。系统会按照计划的频率运行logrotate,通常是每天。在大多数的Linux发行版本上,计划每天运行的脚本位于/etc/cron.daily/logrotate。

主流Linux发行版上都默认安装有logrotate包,如果你的linux系统中找不到logrotate, 可以使用apt-get或yum命令来安装

yum install -y logrotate一般linux都已经自带logrotate,下列命令可以查看是否已安装

rpm -ql logrotate通用的Linux系统默认安装logrotate工具,如果没有请手动安装,它默认的配置文件在:

/etc/logrotate.conf //主配置文件

/etc/logrotate.d/ //配置文件目录,该目录里的所有文件都会被主动的读入/etc/logrotate.conf中执行。

# 以下设定是 "logrotate 的默认值" ,如果別的文件设定了其他的值,

# 就会以其它文件的设定为主

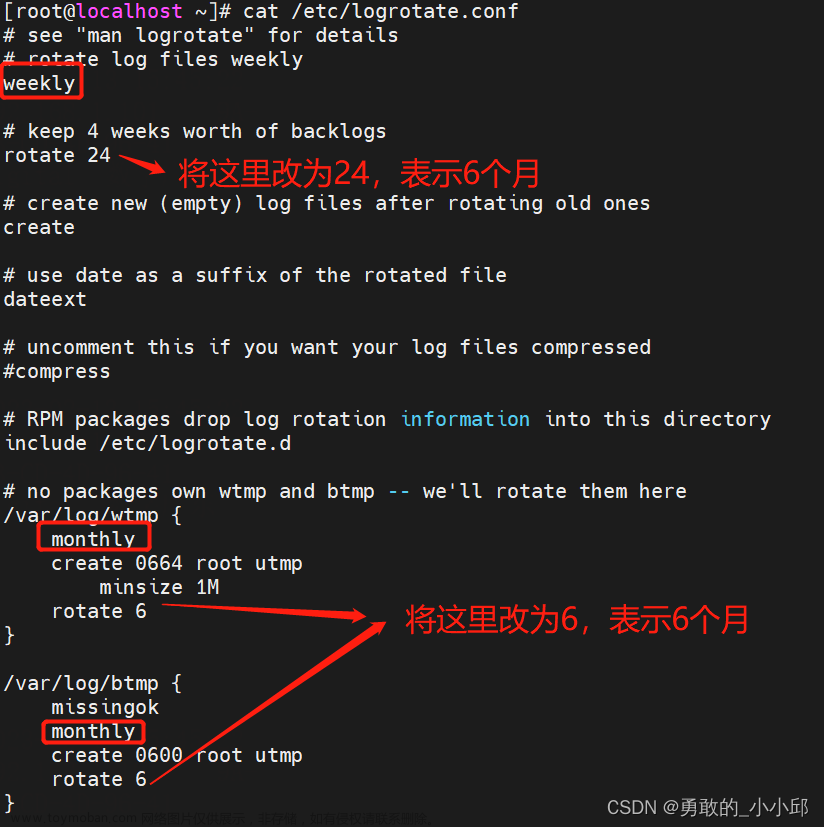

weekly //默认每一周执行一次rotate轮转工作

rotate 4 //保留多少个日志文件(轮转几次).默认保留四个.就是指定日志文件删除之前轮转的次数,0 指没有备份

create //自动创建新的日志文件,新的日志文件具有和原来的文件相同的权限;因为日志被改名,因此要创建一个新的来继续存储之前的日志

dateext //这个参数很重要!就是切割后的日志文件以当前日期为格式结尾,如xxx.log-20131216这样,如果注释掉,切割出来是按数字递增,即前面说的 xxx.log-1这种格式

compress //是否通过gzip压缩转储以后的日志文件,如xxx.log-20131216.gz ;如果不需要压缩,注释掉就行

include /etc/logrotate.d # 将 /etc/logrotate.d/ 目录中的所有文件都加载进来

/var/log/wtmp { //仅针对 /var/log/wtmp 所设定的参数

monthly //每月一次切割,取代默认的一周

minsize 1M //文件大小超过 1M 后才会切割

create 0664 root utmp //指定新建的日志文件权限以及所属用户和组

rotate 1 //只保留一个日志,不设置就默认为1 , 即只会保存一个滚动压缩的文件和一个正在输出日志文件

}

# 这个 wtmp 可记录用户登录系统及系统重启的时间

# 因为有 minsize 的参数,因此不见得每个月一定会执行一次喔.要看文件大小。

注意:

1)配置文件里一定要配置 rotate 文件数目这个参数。如果不配置默认是 0 个,也就是只允许存在一份日志,刚切分出来的日志会马上被删除。

2) logrotate 命令执行最好加 -f 参数,不防止偶然配置文件修改的内容不生效情况。

由上可以知/etc/logrotate.d其实就是由/etc/logrotate.conf 所规划出来的目录,虽然可以将所有的配置都写入 /etc/logrotate.conf ,但是这样一来这个文件就变的太复杂,尤其是当使用很多的服务很多时,而在etc/logrotate.d/目录下,为想要分隔日志的服务单独创建一个目录,那么每个要切割日志的服务, 就可以独自成为一个文件,并且放置到 /etc/logrotate.d/ 当中。

配置文件其他配置项含义:

compress #通过gzip 压缩转储以后的日志

nocompress #不做gzip压缩处理

copytruncate #用于还在打开中的日志文件,把当前日志备份并截断;是先拷贝再清空的方式,拷贝和清空之间有一个时间差,可能会丢失部分日志数据。

nocopytruncate #备份日志文件不过不截断

create mode owner group #轮转时指定创建新文件的属性,如create 0777 nobody nobody

nocreate #不建立新的日志文件

delaycompress #和compress 一起使用时,转储的日志文件到下一次转储时才压缩

nodelaycompress #覆盖 delaycompress 选项,转储同时压缩。

missingok #如果日志丢失,不报错继续滚动下一个日志

errors address #专储时的错误信息发送到指定的Email 地址

ifempty #即使日志文件为空文件也做轮转,这个是logrotate的缺省选项。

notifempty #当日志文件为空时,不进行轮转

mail address #把转储的日志文件发送到指定的E-mail 地址

nomail #转储时不发送日志文件

olddir directory #转储后的日志文件放入指定的目录,必须和当前日志文件在同一个文件系统

noolddir #转储后的日志文件和当前日志文件放在同一个目录下

sharedscripts #运行postrotate脚本,作用是在所有日志都轮转后统一执行一次脚本。如果没有配置这个,那么每个日志轮转后都会执行一次脚本

prerotate #在logrotate转储之前需要执行的指令,例如修改文件的属性等动作;必须独立成行

postrotate #在logrotate转储之后需要执行的指令,例如重新启动 (kill -HUP) 某个服务!必须独立成行

daily #指定转储周期为每天

weekly #指定转储周期为每周

monthly #指定转储周期为每月

rotate count #指定日志文件删除之前转储的次数,0 指没有备份,5 指保留5 个备份

dateext #使用当期日期作为命名格式

dateformat .%s #配合dateext使用,紧跟在下一行出现,定义文件切割后的文件名,必须配合dateext使用,只支持 %Y %m %d %s 这四个参数

size(或minsize) log-size #当日志文件到达指定的大小时才转储,log-size能指定bytes(缺省)及KB (sizek)或MB(sizem).

当日志文件 >= log-size 的时候就转储。 以下为合法格式:(其他格式的单位大小写没有试过)

size = 5 或 size 5 (>= 5 个字节就转储)#满足size就滚动一次,size参数跟滚动周期参数:hourly、daily、monthly、yearly完全是互斥的。即一旦设置了size参数,滚动周期参数就自动无效了,只要每次执行logrotate指令时,日志文件大小超过size,就会触发一次滚动,没有滚动周期一说了

size = 100k 或 size 100k

size = 100M 或 size 100M

maxsize 100k #一般用于多次轮询;当执行logrorate指令时,只要日志的大小超过100k,即使时间没到下一个滚动周期内,也会发生滚动。那么同一小时内0:00--0:59就会发生多次滚动。换句话说,如果demo.txt的大小一直没有达到maxsize,那么一个滚动周期就只会发生一次滚动,即当前滚动周期内第一次执行logrorate指令就会触发滚动。以后的59分钟都不会发生滚动。maxsize可以使滚动提前发生,再下一个滚动周期到来之前发生多次滚动。即每满足maxsize就滚动一次,不满足则滚动1次,(每个滚动周期内,n次或1次)

【maxsize size】: Log files are rotated when they grow bigger than size bytes even before the additionally specified time interval (daily, weekly, monthly, or yearly). The related size option is similar except that it is mutually exclusive with the time interval options, and it causes log files to be rotated without regard for the last rotation time. When maxsize is used, both the size and timestamp of a log file are considered.

minsize 100k #一个滚动周期内只会发生一次滚动,在当前滚动周期后面的时间里,即使日志大小再次超过100k,也不会再发生滚动,即minsize不能使滚动提前发生。如果日志的大小一直没有达到minsize,那么这个滚动周期内是不会触发滚动的。即满足minsize则滚动一次,不满足则滚动0次,(每个滚动周期内,1次或0次)。

maxage 60 #自动删除掉超过maxage指定天数的切割后的归档文件,即最大保留60天;相对于rotate按文件数,它是以天数为单位的

二、工具使用

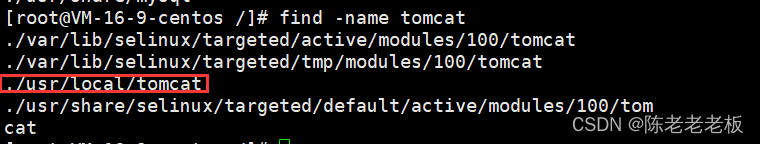

进入logrotate的配置目录/etc/logrotate.d,新建一个文件,以分割”nginx”日志为例,则新建一个名为“nginx”的文件,内容如下:

/home/docker/apps/nginx/logs/*.log {

daily # 每天分割一次

#size 5M # 源文件小于5M时不分割

rotate 180

copytruncate

notifempty # 当日志文件为空时不分割

missingok

dateext # 切割后的文件添加日期作为后缀

dateyesterday # 配合dateext使用,添加前一天的日期作为分割后日志的后缀

dateformat -%Y-%m-%d

}/home/docker/apps/nginx/logs/*.log 表示你要分割的文件路径

脚本文件写好后,先手动执行一次,看脚本文件是否可行。

logrotate -vf /etc/logrotate.d/nginx若能正常分割即可。

定时任务进行日志分割:

1.先编写shell脚本log_day.sh

#! /bin/sh

logs_path=/home/project/XXX-plat/logs/

if [ -n ${logs_path}base-admin.log ] ###判断base-admin.log是否不为空

then

rm -rf ${logs_path}base-admin_$(date -d "yesterday" +"%Y%m%d").log

cp ${logs_path}base-admin.log ${logs_path}base-admin_$(date -d "yesterday" +"%Y%m%d").log

> ${logs_path}base-admin.log

fi

if [ -n ${logs_path}base-gateway.log ] ###判断base-gateway.log是否不为空

then

rm -rf ${logs_path}base-gateway_$(date -d "yesterday" +"%Y%m%d").log

cp ${logs_path}base-gateway.log ${logs_path}base-gateway_$(date -d "yesterday" +"%Y%m%d").log

> ${logs_path}base-gateway.log

fi

if [ -n ${logs_path}member-business.log ] ###判断member-business.log是否不为空

then

rm -rf ${logs_path}member-business_$(date -d "yesterday" +"%Y%m%d").log

cp ${logs_path}member-business.log ${logs_path}member-business_$(date -d "yesterday" +"%Y%m%d").log

> ${logs_path}member-business.log

fi

exit 02.设定定时任务文章来源:https://www.toymoban.com/news/detail-742856.html

crontab -e每天0点开始分割 ,这是定时任务配置文章来源地址https://www.toymoban.com/news/detail-742856.html

00 00 * * * /bin/bash /home/project/XXX-plat/script/log_day.sh到了这里,关于Linux进阶(日志分割工具logrotate)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!