作者:禅与计算机程序设计艺术

1.简介

一、什么是模型蒸馏?

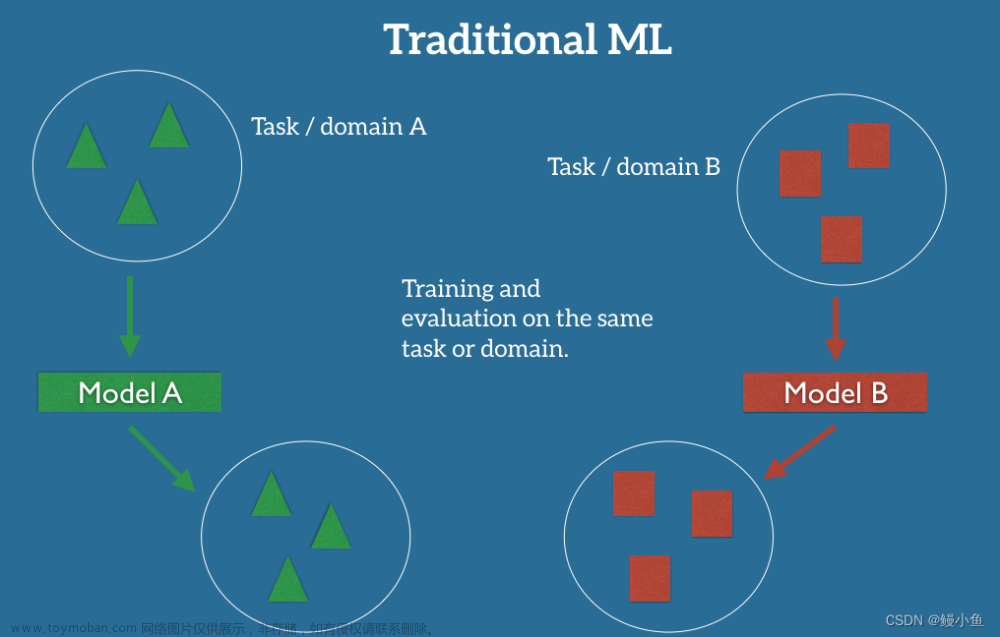

模型蒸馏(Model Distillation)是将一个复杂的大型机器学习模型压缩到更小且效率更高的模型上的一种技术。它可以让用户获得更高质量的模型,同时降低计算资源占用和部署成本。目前国内外多种公司在使用模型蒸馏技术,如阿里巴巴在内部业务线上使用,腾讯QQ群聊天机器人的模型蒸馏;京东智科在基于大数据、云端的图像搜索产品中使用;亚马逊推出了Alexa Prize评委团队提出的“系统级模型蒸馏”(SysMT)竞赛。

二、什么是知识蒸馏?

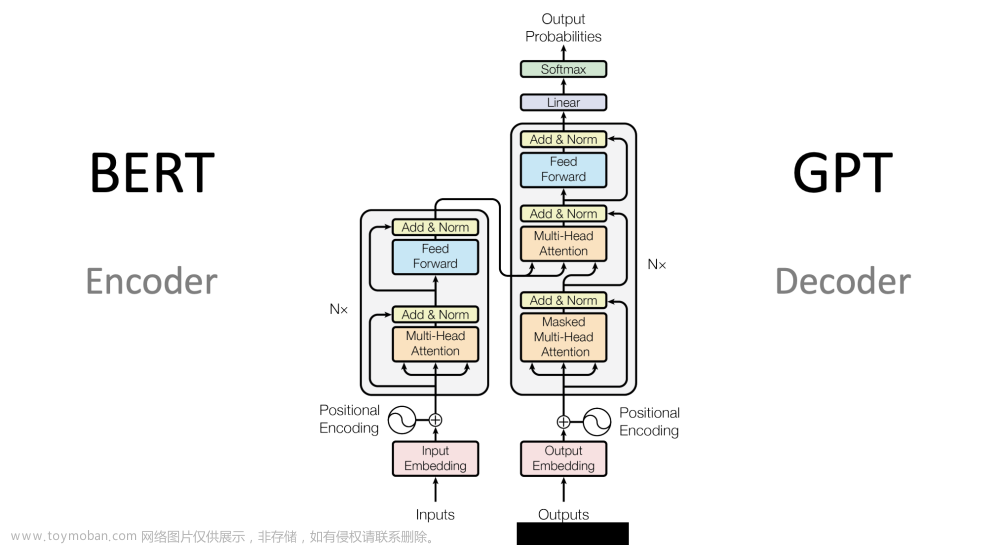

知识蒸馏(Knowledge Distillation)是指通过训练一个小型模型来模仿一个大型预训练好的模型的表征学习能力。其目的是压缩大模型中的信息并转移到小模型中,从而达到知识迁移的目的。近年来,深度神经网络(DNNs)的大规模应用促进了知识蒸馏技术的快速发展。Google、Facebook等科技巨头纷纷将知识蒸馏技术应用于自身产品中,例如搜索引擎、垃圾邮件过滤、图像识别等领域。基于公开可用的大模型,Google和Facebook开发了一种名为DistilBERT的小模型,这种模型可以在较少的计算资源下取得与高性能模型相媲美的结果。此外,还有一些初创企业也加入了知识蒸馏的行列,如微软的Project Cogito。文章来源:https://www.toymoban.com/news/detail-743662.html

三、为什么要蒸馏模型?

蒸馏模型的最大优点是可以在较小的计算资源下获取与训练完整模型相当的精度。比如,当训练一个深度神经网络时,需要大量的计算资源(GPU算力),因此在资文章来源地址https://www.toymoban.com/news/detail-743662.html

到了这里,关于人工智能大模型技术基础系列之:模型蒸馏与知识蒸馏的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!