【1】偏应力张量

通常将应力张量分为两个部分,一部分是球应力张量,另一部分是偏应力张量。其中偏应力张量表示为

p

δ

i

j

p \delta _{ij}

pδij(这里的

δ

i

j

\delta _{ij}

δij是克罗内克函数)的张量,其中平均应力

p

p

p为

p

=

1

3

c

k

k

=

1

3

(

σ

x

+

σ

y

+

σ

z

)

=

1

3

I

1

(1)

p = \frac { 1 } { 3 } c _ { k k } = \frac { 1 } { 3 } ( \sigma _ { x } + \sigma _ { y } + \sigma _ { z } ) = \frac { 1 } { 3 } I _ { 1 } \tag{1}

p=31ckk=31(σx+σy+σz)=31I1(1) 显然由式(1)得知,

p

p

p对于坐标轴可能的所有方向都是相同的,所以称作球应力。偏应力张量

s

i

j

s_{ij}

sij定义为从实际应力状态中减去球面应力状态。因此,有

s

i

j

=

σ

i

j

−

p

δ

i

j

(2)

s _ { i j } = \sigma _ { i j } - p \delta _ { i j }\tag{2}

sij=σij−pδij(2) 式(2)给出了偏应力张量

s

i

j

s _ { i j }

sij所需要的定义,这个张量的分量为

s

i

j

=

[

s

11

s

12

s

13

s

21

s

22

s

23

s

31

s

32

s

33

]

=

[

(

σ

11

−

p

)

σ

12

σ

13

σ

21

(

σ

22

−

p

)

σ

23

σ

31

a

32

(

σ

33

−

p

)

]

(3)

s _ { i j } = \left[ \begin{array} { l l l } { s _ { 11 } } & { s _ { 12 } } & { s _ { 13 } } \\ { s _ { 21 } } & { s _ { 22 } } & { s _ { 23 } } \\ { s _ { 31 } } & { s _ { 32 } } & { s _ { 33 } } \end{array} \right]\tag{3}=\left[ \begin{array} { l l l } { ( \sigma _ { 11 } - p ) } & { \sigma_ { 12 } } & { \sigma _ { 13 } } \\ { \sigma _ { 21 } } & { ( \sigma_ { 22 } - p ) } & { \sigma _ { 23 } } \\ { \sigma _ { 31 } } & { a _ { 32 } } & { ( \sigma _ { 33 } - p ) } \end{array} \right]

sij=

s11s21s31s12s22s32s13s23s33

=

(σ11−p)σ21σ31σ12(σ22−p)a32σ13σ23(σ33−p)

(3) 注意,在式(2)中,对于

i

≠

j

i \neq j

i=j,有

δ

i

j

=

0

\delta _ { i j }=0

δij=0和

s

i

j

=

σ

i

j

s_{ij}= \sigma _{ij}

sij=σij.

【1.1】偏应力张量是一个纯剪状态

从式(2)可得,

σ

i

i

=

s

i

i

+

p

δ

i

i

(4)

\sigma _{ii}=s_{ii}+p \delta _{ii}\tag{4}

σii=sii+pδii(4)

代换

δ

i

j

\delta _ { i j }

δij并用式(1),可以从式(4)中得到

σ

i

i

=

s

i

i

+

1

3

σ

i

i

(5)

\sigma _{ii}=s_{ii}+ \frac{1}{3}\sigma _{ii}\tag{5}

σii=sii+31σii(5)或

s

i

i

=

s

11

+

s

22

+

s

33

=

0

(6)

s_{ii}=s_{11}+s_{22}+s_{33}=0\tag{6}

sii=s11+s22+s33=0(6)

固偏应力张量是一个纯剪状态。文章来源:https://www.toymoban.com/news/detail-744878.html

【1.2】 s i j s_{ij} sij的主方向

显然,在所有方向上减去一个常数正应力不会改变其主方向,所以偏应力张量与原应力张量的方向是一致的。用主应力表示,偏应力张量为

s

i

j

=

[

σ

1

−

p

0

0

0

σ

2

−

p

0

0

0

0

σ

3

−

p

]

(7)

s _ { i j } = \left[ \begin{array} { l l l } {\sigma _ { 1 } - p } & { 0 } & { 0 } \\ { 0 } & {\sigma _ { 2 } - p } & { 0 } \\ { 0 } & { 0 } & { 0 } & { \sigma_ { 3 } - p } \end{array} \right]\tag{7}

sij=

σ1−p000σ2−p0000σ3−p

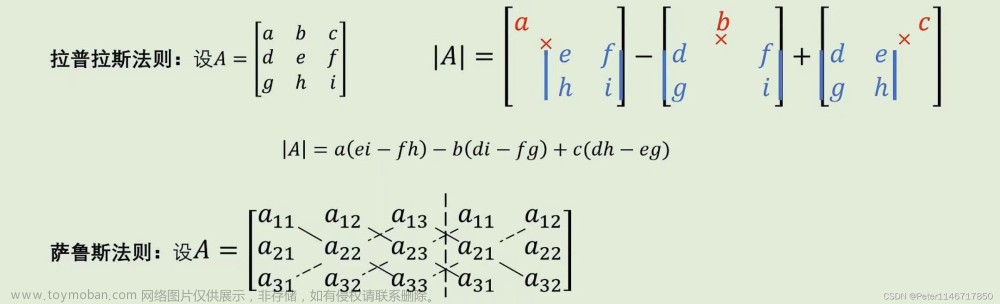

(7)为了获得偏应力张量s的不变量,采用推导式(2.45)的类似方法,从而可以写出

∣

s

i

j

−

s

δ

i

j

∣

=

0

(8)

|s_{ij}-s \delta _{ij}|=0\tag{8}

∣sij−sδij∣=0(8)或

s

3

−

J

1

s

2

+

J

2

s

−

J

3

=

0

(9)

s^{3}-J_{1}s^{2}+J_{2}s-J_{3}=0\tag{9}

s3−J1s2+J2s−J3=0(9)其中,

J

1

{J_1}

J1、

J

2

{J_2}

J2和

J

3

{J_3}

J3为偏应力张量的不变量。不变量

J

1

{J_1}

J1、

J

2

{J_2}

J2和

J

3

{J_3}

J3可以表达成以

s

{s}

s的分量或主值

s

1

{s_1}

s1、

s

2

{s_2}

s2和

s

3

{s_3}

s3表示的不同形式,或者以应力张量的分量或主值

σ

1

{\sigma_1}

σ1、

σ

2

{\sigma_2}

σ2和

σ

3

{\sigma_3}

σ3表示的不同形式。所以有

J

1

=

s

i

i

=

s

11

+

s

22

+

s

33

=

s

1

+

s

2

+

s

3

=

0

J_{1}=s_{ii}=s_{11}+s_{22}+s_{33}=s_{1}+s_{2}+s_{3}=0

J1=sii=s11+s22+s33=s1+s2+s3=0

J

2

=

1

2

S

i

j

S

j

i

=

1

2

(

S

11

2

+

S

22

2

+

S

33

2

+

S

12

s

21

+

S

21

s

12

+

⋯

)

=

1

2

(

s

1

2

+

s

2

2

+

s

3

2

)

J _ { 2 } = \frac { 1 } { 2 } S _ { i j } S _ { j i } = \frac { 1 } { 2 } ( S _ { 1 1 } ^ { 2 } + S _ { 2 2 } ^ { 2 } + S _ { 3 3 } ^ { 2 } + S _ { 1 2 } s _ { 2 1 } + S _ { 2 1 } s _ { 1 2 } + \cdots )= \frac{1}{2}(s_{1}^{2}+s_{2}^{2}+s_{3}^{2})

J2=21SijSji=21(S112+S222+S332+S12s21+S21s12+⋯)=21(s12+s22+s32)

J

3

=

1

3

s

i

j

s

j

k

s

k

i

=

1

3

(

s

1

3

+

s

2

3

+

s

3

3

)

=

s

1

s

2

s

3

J_{3}= \frac{1}{3}s_{ij}s_{jk}s_{ki}= \frac{1}{3}(s_{1}^{3}+s_{2}^{3}+s_{3}^{3})=s_{1}s_{2}s_{3}

J3=31sijsjkski=31(s13+s23+s33)=s1s2s3文章来源地址https://www.toymoban.com/news/detail-744878.html

到了这里,关于偏应力张量的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!