在这篇文章中,我们将分享7个Python爬虫的小案例,帮助大家更好地学习和了解Python爬虫的基础知识。以下是每个案例的简介和源代码:

1. 爬取豆瓣电影Top250

这个案例使用BeautifulSoup库爬取豆瓣电影Top250的电影名称、评分和评价人数等信息,并将这些信息保存到CSV文件中。

import requests

from bs4 import BeautifulSoup

import csv

# 请求URL

url = '<https://movie.douban.com/top250>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

soup = BeautifulSoup(html, 'lxml')

movie_list = soup.find('ol', class_='grid_view').find_all('li')

for movie in movie_list:

title = movie.find('div', class_='hd').find('span', class_='title').get_text()

rating_num = movie.find('div', class_='star').find('span', class_='rating_num').get_text()

comment_num = movie.find('div', class_='star').find_all('span')[-1].get_text()

writer.writerow([title, rating_num, comment_num])

# 保存数据函数

def save_data():

f = open('douban_movie_top250.csv', 'a', newline='', encoding='utf-8-sig')

global writer

writer = csv.writer(f)

writer.writerow(['电影名称', '评分', '评价人数'])

for i in range(10):

url = '<https://movie.douban.com/top250?start=>' + str(i*25) + '&filter='

response = requests.get(url, headers=headers)

parse_html(response.text)

f.close()

if __name__ == '__main__':

save_data()

2. 爬取猫眼电影Top100

这个案例使用正则表达式和requests库爬取猫眼电影Top100的电影名称、主演和上映时间等信息,并将这些信息保存到TXT文件中。

import requests

import re

# 请求URL

url = '<https://maoyan.com/board/4>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

pattern = re.compile('<p class="name"><a href=".*?" title="(.*?)" data-act="boarditem-click" data-val="{movieId:\\\\d+}">(.*?)</a></p>.*?<p class="star">(.*?)</p>.*?<p class="releasetime">(.*?)</p>', re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'电影名称': item[1],

'主演': item[2].strip(),

'上映时间': item[3]

}

# 保存数据函数

def save_data():

f = open('maoyan_top100.txt', 'w', encoding='utf-8')

for i in range(10):

url = '<https://maoyan.com/board/4?offset=>' + str(i*10)

response = requests.get(url, headers=headers)

for item in parse_html(response.text):

f.write(str(item) + '\\\\n')

f.close()

if __name__ == '__main__':

save_data()

3. 爬取全国高校名单

这个案例使用正则表达式和requests库爬取全国高校名单,并将这些信息保存到TXT文件中。

import requests

import re

# 请求URL

url = '<http://www.zuihaodaxue.com/zuihaodaxuepaiming2019.html>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

pattern = re.compile('<tr class="alt">.*?<td>(.*?)</td>.*?<td><div align="left">.*?<a href="(.*?)" target="_blank">(.*?)</a></div></td>.*?<td>(.*?)</td>.*?<td>(.*?)</td>.*?</tr>', re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'排名': item[0],

'学校名称': item[2],

'省市': item[3],

'总分': item[4]

}

# 保存数据函数

def save_data():

f = open('university_top100.txt', 'w', encoding='utf-8')

response = requests.get(url, headers=headers)

for item in parse_html(response.text):

f.write(str(item) + '\\\\n')

f.close()

if __name__ == '__main__':

save_data()

4. 爬取中国天气网城市天气

这个案例使用xpath和requests库爬取中国天气网的城市天气,并将这些信息保存到CSV文件中。

import requests

from lxml import etree

import csv

# 请求URL

url = '<http://www.weather.com.cn/weather1d/101010100.shtml>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

selector = etree.HTML(html)

city = selector.xpath('//*[@id="around"]/div/div[1]/div[1]/h1/text()')[0]

temperature = selector.xpath('//*[@id="around"]/div/div[1]/div[1]/p/i/text()')[0]

weather = selector.xpath('//*[@id="around"]/div/div[1]/div[1]/p/@title')[0]

wind = selector.xpath('//*[@id="around"]/div/div[1]/div[1]/p/span/text()')[0]

return city, temperature, weather, wind

# 保存数据函数

def save_data():

f = open('beijing_weather.csv', 'w', newline='', encoding='utf-8-sig')

writer = csv.writer(f)

writer.writerow(['城市', '温度', '天气', '风力'])

for i in range(10):

response = requests.get(url, headers=headers)

city, temperature, weather, wind = parse_html(response.text)

writer.writerow([city, temperature, weather, wind])

f.close()

if __name__ == '__main__':

save_data()

5. 爬取当当网图书信息

这个案例使用xpath和requests库爬取当当网图书信息,并将这些信息保存到CSV文件中。

import requests

from lxml import etree

import csv

# 请求URL

url = '<http://search.dangdang.com/?key=Python&act=input>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

selector = etree.HTML(html)

book_list = selector.xpath('//*[@id="search_nature_rg"]/ul/li')

for book in book_list:

title = book.xpath('a/@title')[0]

link = book.xpath('a/@href')[0]

price = book.xpath('p[@class="price"]/span[@class="search_now_price"]/text()')[0]

author = book.xpath('p[@class="search_book_author"]/span[1]/a/@title')[0]

publish_date = book.xpath('p[@class="search_book_author"]/span[2]/text()')[0]

publisher = book.xpath('p[@class="search_book_author"]/span[3]/a/@title')[0]

yield {

'书名': title,

'链接': link,

'价格': price,

'作者': author,

'出版日期': publish_date,

'出版社': publisher

}

# 保存数据函数

def save_data():

f = open('dangdang_books.csv', 'w', newline='', encoding='utf-8-sig')

writer = csv.writer(f)

writer.writerow(['书名', '链接', '价格', '作者', '出版日期', '出版社'])

response = requests.get(url, headers=headers)

for item in parse_html(response.text):

writer.writerow(item.values())

f.close()

if __name__ == '__main__':

save_data()

6. 爬取糗事百科段子

这个案例使用xpath和requests库爬取糗事百科的段子,并将这些信息保存到TXT文件中。

import requests

from lxml import etree

# 请求URL

url = '<https://www.qiushibaike.com/text/>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

selector = etree.HTML(html)

content_list = selector.xpath('//div[@class="content"]/span/text()')

for content in content_list:

yield content

# 保存数据函数

def save_data():

f = open('qiushibaike_jokes.txt', 'w', encoding='utf-8')

for i in range(3):

url = '<https://www.qiushibaike.com/text/page/>' + str(i+1) + '/'

response = requests.get(url, headers=headers)

for content in parse_html(response.text):

f.write(content + '\\\\n')

f.close()

if __name__ == '__main__':

save_data()

7. 爬取新浪微博

这个案例使用selenium和requests库爬取新浪微博,并将这些信息保存到TXT文件中。

import time

from selenium import webdriver

import requests

# 请求URL

url = '<https://weibo.com/>'

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

# 解析页面函数

def parse_html(html):

print(html)

# 保存数据函数

def save_data():

f = open('weibo.txt', 'w', encoding='utf-8')

browser = webdriver.Chrome()

browser.get(url)

time.sleep(10)

browser.find_element_by_name('username').send_keys('username')

browser.find_element_by_name('password').send_keys('password')

browser.find_element_by_class_name('W_btn_a').click()

time.sleep(10)

response = requests.get(url, headers=headers, cookies=browser.get_cookies())

parse_html(response.text)

browser.close()

f.close()

if __name__ == '__main__':

save_data()

关于Python的技术储备

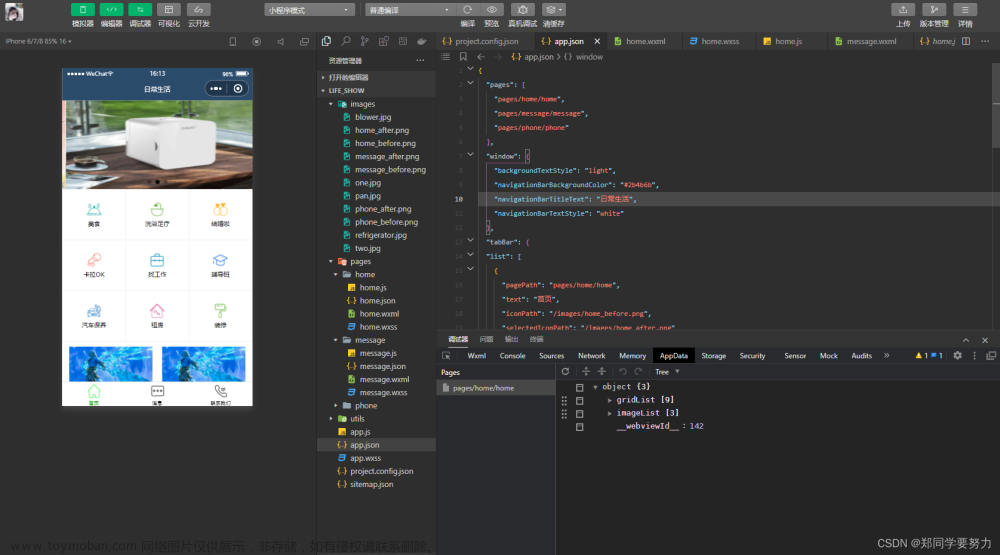

在这里给大家分享一些免费的课程供大家学习,下面是课程里面的截图,扫描最下方的二维码就能全部领取

1.Python所有方向的学习路线

2.学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

3.学习资料

4.实战资料

实践是检验真理的唯一标准。这里的压缩包可以让你再闲暇之余帮你提升你的个人能力。

5.视频课程

好啦今天的分享就到这里结束了,快乐的时光总是短暂呢,想学习更多课程的小伙伴不要着急,有更多惊喜哦~文章来源:https://www.toymoban.com/news/detail-744932.html

文章来源地址https://www.toymoban.com/news/detail-744932.html

文章来源地址https://www.toymoban.com/news/detail-744932.html

到了这里,关于【python爬虫】给你分享几个日常生活中可以用到的爬虫小程序的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!