目录

一、爬虫入门基础

1、什么是爬虫?

2、爬虫的分类

3、爬虫的基本流程

二、Selenium简介

1、Selenium是什么?

2、Selenium的用途

三、应对反爬虫的Selenium策略

1、使用代理IP

2、模拟用户行为

3、设置合理的请求间隔时间

4、随机化请求参数

5、使用JavaScript渲染引擎

四、Selenium的局限性和注意事项

1、Selenium的局限性

2、使用Selenium的注意事项

3、应对动态加载的反爬虫策略

4、应对文本混淆的反爬虫策略

5、应对分布式爬虫的限制

总结

随着互联网的普及和信息量的爆炸式增长,网络爬虫技术应运而生,逐渐成为了数据获取、信息提取的重要手段。然而,在数据抓取的过程中,我们常常会遇到各种反爬虫措施的阻挠。这时,如何运用Selenium自动化测试工具,模拟真实的用户操作,以绕过反爬虫限制,便成为了关键问题。本文将介绍一些基于Selenium的反爬虫策略,帮助您在数据抓取过程中取得成功。

一、爬虫入门基础

1、什么是爬虫?

爬虫(Web Crawler)是一种自动化的网页抓取工具,它按照一定的规则和算法,遍历互联网上的网页,将网页数据保存到本地,以供后续分析和处理。爬虫可以用于很多不同的领域,例如搜索引擎、数据挖掘、竞争情报、价格监测等等。

2、爬虫的分类

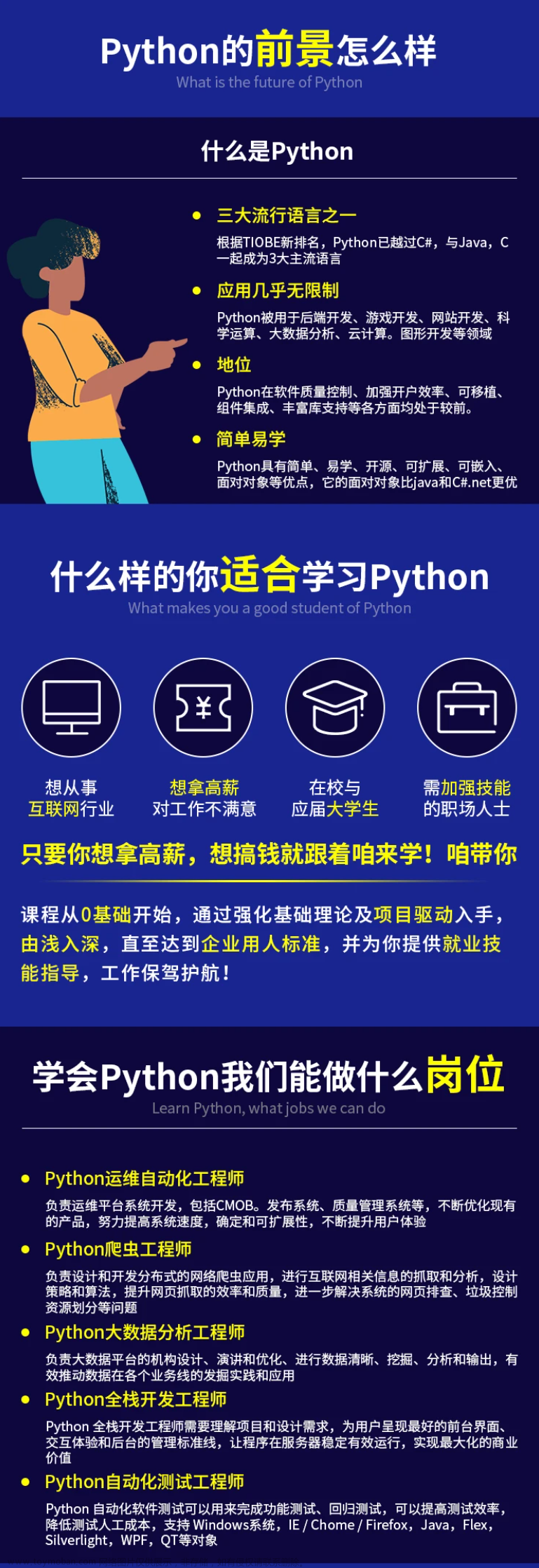

按照实现原理,爬虫可以分为两种:基于文本的爬虫和基于图像的爬虫。

基于文本的爬虫(Text-based Crawler)是指通过解析网页文本信息,获取所需内容的爬虫。这种爬虫使用得较多,它可以通过HTML解析器(如BeautifulSoup、lxml等)提取网页中的文本信息,再根据一定的规则进行筛选和分类。

基于图像的爬虫(Image-based Crawler)是指通过识别和分析图像内容,获取所需内容的爬虫。这种爬虫使用得较少,它需要使用OCR(Optical Character Recognition)技术将图片中的文字转换成可编辑的文本。

3、爬虫的基本流程

爬虫的基本流程包括以下步骤:

(1)发送请求:爬虫首先向目标网站发送请求,获取网页的HTML代码。

(2)解析网页:爬虫接收到HTML代码后,需要使用HTML解析器将代码转换成可读取的结构化数据。

(3)提取数据:爬虫根据需求从解析后的网页中提取所需的数据。

(4)存储数据:爬虫将提取到的数据保存到本地或数据库中。

(5)去重:为了避免重复抓取同一个网页,爬虫需要使用一定的算法去重处理。

二、Selenium简介

1、Selenium是什么?

Selenium是一种自动化测试工具,它支持多种浏览器和操作系统,可以模拟真实的用户操作,如点击、输入、滚动页面等等。Selenium广泛应用于Web应用程序的测试和调试,它可以自动化测试流程,提高测试效率和准确度。

2、Selenium的用途

Selenium的主要用途包括:

(1)自动化测试:Selenium可以模拟用户操作,执行测试用例,检查应用程序的功能和性能。

(2)网站调试:Selenium可以帮助开发人员和测试人员模拟用户操作,发现和修复网站中的bug和问题。

(3)数据抓取:Selenium可以用于抓取网站中的数据,例如登录某个网站后抓取其中的表格数据等等。

三、应对反爬虫的Selenium策略

1、使用代理IP

网站可以通过IP地址限制访问频率和访问时间间隔来防止恶意爬取。为了绕过这种限制,我们可以使用代理IP。代理IP即利用第三方服务器进行网络请求转发,以隐藏真实IP地址。使用代理IP后,我们可以通过不断更换代理IP来避免被网站发现。

2、模拟用户行为

网站通常会检测请求是否来自于真实的用户操作。为了绕过这种限制,我们需要模拟用户行为。具体来说,我们需要在抓取数据时按照真实的用户操作方式进行操作,例如先进行页面滚动,再点击链接等等。这样可以避免被网站发现。

3、设置合理的请求间隔时间

网站可能会对来自同一IP地址的请求进行时间间隔限制,以防止恶意爬取。为了绕过这种限制,我们可以设置合理的请求间隔时间。例如每次请求之后等待一段时间再进行下一次请求,以避免被网站发现。一般来说,这个时间间隔应该大于网站的限制时间。具体等待时间可以通过试验来找到合适的值。

4、随机化请求参数

网站可以通过检查请求参数来判断是否为爬虫请求。为了绕过这种限制,我们可以随机化请求参数。例如,每次请求时都随机生成一个或多个参数,以避免被网站发现。

5、使用JavaScript渲染引擎

有些网站会使用JavaScript来动态生成内容,这就无法通过直接发送HTTP请求来获取数据。为了获取这些数据,我们需要使用JavaScript渲染引擎来模拟浏览器操作。Selenium提供了JavaScript渲染引擎,可以模拟真实的用户操作,例如点击按钮、输入文本等等。

四、Selenium的局限性和注意事项

1、Selenium的局限性

虽然Selenium可以模拟真实的用户操作,但是在某些情况下还是存在局限性。例如,有些网站会使用反爬虫技术来检测和阻止爬虫,例如文本混淆、动态加载等等。这些技术可能会让Selenium无法正确识别和处理网页内容。

此外,Selenium虽然可以模拟用户操作,但是并不能完全替代人工测试。有些复杂的逻辑和边界条件可能无法通过Selenium来测试。

2、使用Selenium的注意事项

在使用Selenium进行爬虫或测试时,需要注意以下事项:

(1)合理使用代理IP和请求间隔时间,避免被网站发现和封锁。

(2)在模拟用户行为时,要尽可能真实地模拟用户操作,避免被网站发现。

(3)在抓取数据时,要尊重网站的规则和隐私条款,避免侵犯他人的合法权益。

(4)在测试时,要尽可能覆盖各种场景和边界条件,以发现潜在的问题。

(5)在使用JavaScript渲染引擎时,要注意性能和稳定性,避免影响测试效率和准确性。

3、应对动态加载的反爬虫策略

有些网站会使用动态加载技术来延迟加载网页内容,以防止爬虫抓取。为了应对这种反爬虫策略,我们可以使用Selenium提供的等待功能。具体来说,我们可以在抓取数据之前,先等待一段时间,以等待动态加载完成。在等待期间,我们可以使用Selenium提供的隐式等待或显式等待功能。

4、应对文本混淆的反爬虫策略

有些网站会使用文本混淆技术来防止爬虫识别和理解网页内容。为了应对这种反爬虫策略,我们可以使用Selenium提供的JavaScript渲染引擎来处理混淆的文本。具体来说,我们可以使用JavaScript来获取和解析混淆的文本,然后再将其还原为可读的文本。

5、应对分布式爬虫的限制

有些网站会对来自同一IP地址的请求进行限制,以防止分布式爬虫攻击。为了应对这种限制,我们可以使用代理IP和请求间隔时间来避免被网站发现。另外,我们也可以通过增加请求的随机性和使用负载均衡技术来避免被网站发现。文章来源:https://www.toymoban.com/news/detail-751755.html

总结

Selenium作为一种自动化测试工具,在数据抓取方面也具有非常实用的价值。通过模拟用户操作和采用一些反爬虫策略,我们可以有效地绕过网站的反爬虫措施,并高效地抓取所需的数据。同时,在使用Selenium时也需要注意一些局限性和注意事项,以确保数据抓取和测试的效率和准确性。文章来源地址https://www.toymoban.com/news/detail-751755.html

到了这里,关于爬虫入门基础与Selenium反爬虫策略的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!