1. 反爬

有时候,我们利用 Selenium 自动化爬取某些网站时,极有可能会遭遇反爬。

实际上,我们使用默认的方式初始化 WebDriver 打开一个网站,下面这段 JS 代码永远为 true,而手动打开目标网站的话,则为:undefined

# 通过这段 JS 脚本区分是爬虫还是人工操作

window.navigator.webdriver

稍微有一点反爬经验的工程师利用上面的差别,很容易判断访问对象是否为一个爬虫,然后对其做反爬处理,返回一堆脏数据或各种验证码。

如果要实现后面的自动化操作,首先要解决的就是这个反爬的问题。

常见的反反爬方案包含:设置参数 excludeSwitches、mitmproxy 拦截过滤、cdp 命令,下面分别来说说。

2.设置参数 excludeSwitches

Chrome79 之前可以通过配置 ChromeOptions 驱动参数,来达到反反爬的目的。

只需要将参数打开,设置 excludeSwitches 值为 enable-automation 即可。

from selenium.webdriver import Chrome

from selenium.webdriver import ChromeOptions

option = ChromeOptions()

# 打开参数

option.add_experimental_option('excludeSwitches', ['enable-automation'])

driver = Chrome(options=option)

driver.implicitly_wait(10)

driver.get("http://www.google.com")

这个参数是实验性参数,所以右上角会提示:请停用开发者模式运行的扩展程序,不能点击停用。

这样,设置这个参数后:

window.navigator.webdriver 的值就变成 undefined 了。

3. mitproxy 拦截

众所周知,mitproxy 可以拦截到网络请求,做其他处理,这里只需要进行 JS 代码注入即可。

# 待执行的 JS 代码,修改 window.navigator.webdriver 的值

js_exec = 'Object.defineProperties(navigator,{webdriver:{get:() => false}});'

# 重写 response,截获网络请求,js注入

def response(slef,flow: mitmproxy.http.HTTPFlow):

if 'google' in flow.request.url:

flow.response.text = js_exec + flow.response.text

然后启动 mitmdump

# 启动mitmproxy

mitmdump -p 8888 -s 111.py

最后,配置 ChromeOptions 指向 mitmdump代码即可。

# 配置ChromeOptions

option.add_argument("--proxy-server=http://127.0.0.1:8888")

4. cdp 命令(经验证可以)

cdp 全称是:Chrome Devtools-Protocol

通过 addScriptToEvaluateOnNewDocument() 方法可以在页面还未加载之前,运行一段脚本。

如此,我们只需要提前设置:

window.navigator.webdriver 的值为 undefined 即可。

from selenium.webdriver import Chrome

from selenium.webdriver import ChromeOptions

option = ChromeOptions()

# 打开参数

# option.add_argument("--proxy-server=http://127.0.0.1:8888")

# driver = Chrome(options=option)

driver = Chrome()

driver.execute_cdp_cmd("Page.addScriptToEvaluateOnNewDocument", {

"source": """

Object.defineProperty(navigator, 'webdriver', {

get: () => undefined

})

"""

})

driver.implicitly_wait(10)

driver.get("http://www.google.com")

5. 其他

通过上面的 3 种方法可以很好的解决 Selenium 自动化被反爬的问题。

感兴趣的小伙伴,赠送全套Python学习资料,包含面试题、简历资料等具体看下方。

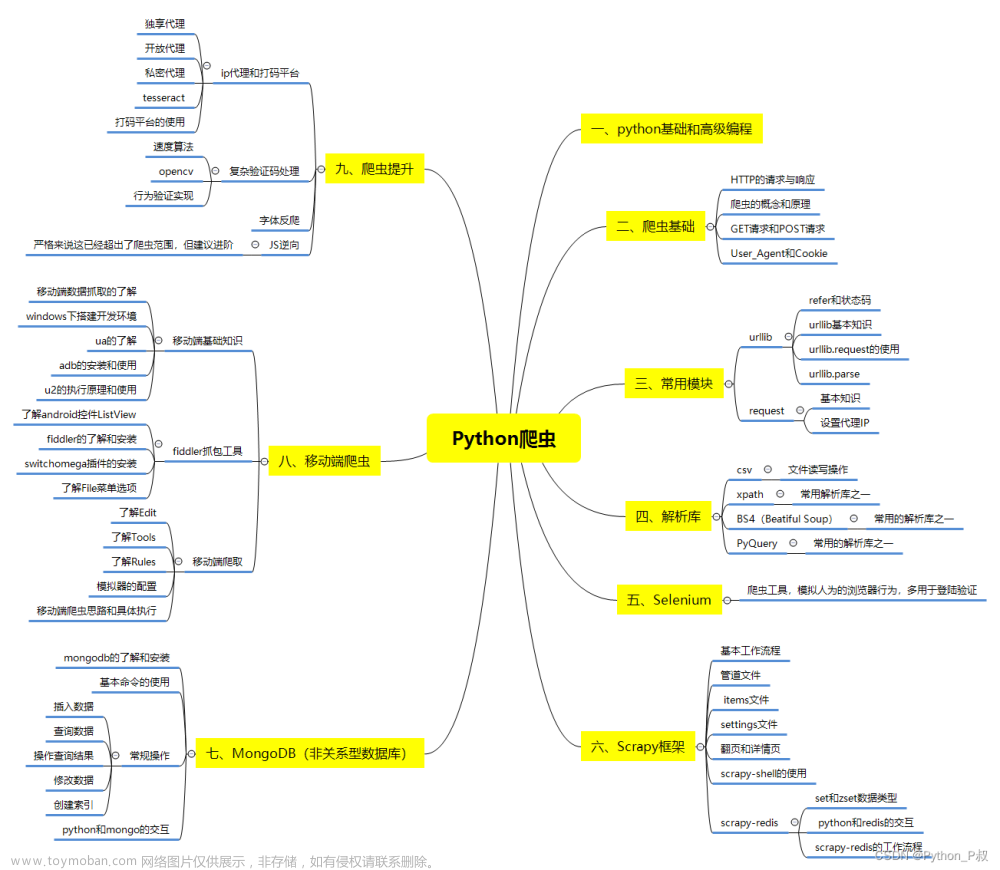

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python必备开发工具

工具都帮大家整理好了,安装就可直接上手!

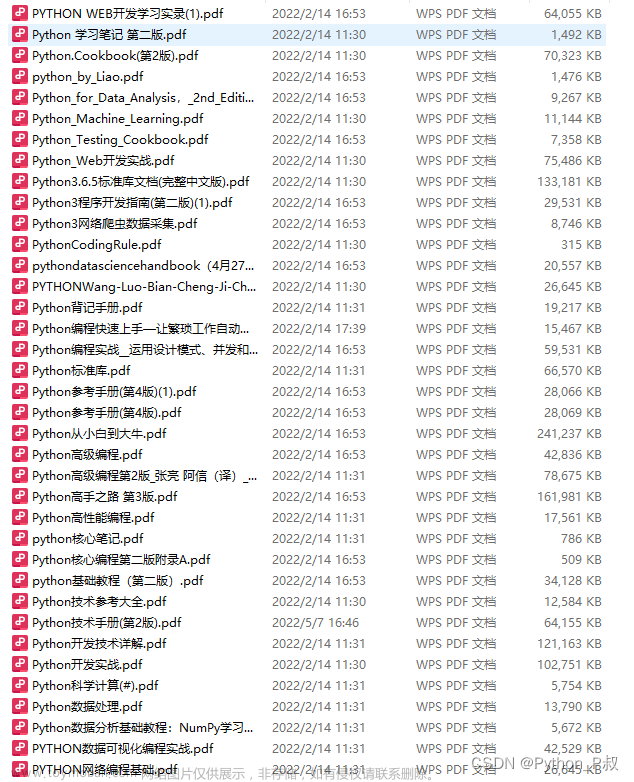

三、最新Python学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

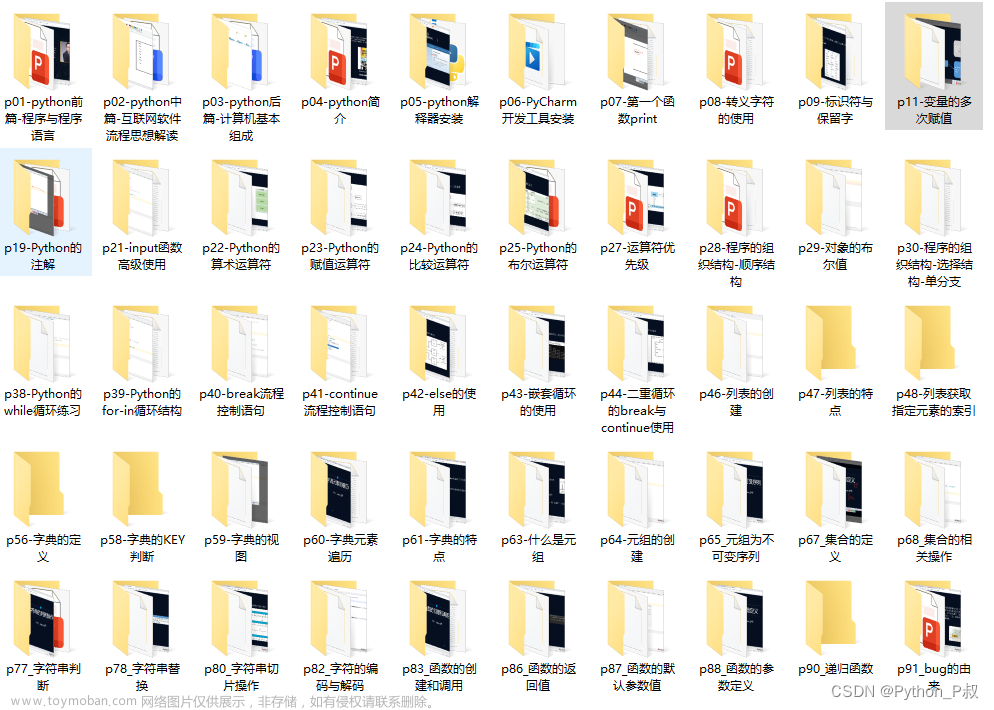

四、Python视频合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

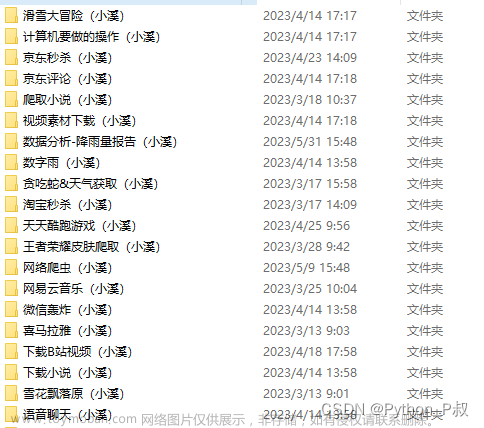

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试宝典

文章来源:https://www.toymoban.com/news/detail-752012.html

文章来源:https://www.toymoban.com/news/detail-752012.html

文章来源地址https://www.toymoban.com/news/detail-752012.html

文章来源地址https://www.toymoban.com/news/detail-752012.html

简历模板

若有侵权,请联系删除

若有侵权,请联系删除 到了这里,关于Python反反爬篇--selenium被检测到的解决办法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!