自ChatGPT面世以来,以它为代表的闭源 AI 备受关注,简单易用的特性使其占据了行业主导。尽管以LLaMA 为代表的开源 AI 进展迅猛,但业内也流行三个反对开源的观点:开源 AI 无法与行业实验室的优势资源竞争;开源 AI 缺乏安全性;开源 AI 无法进行推理(reasoning)。

本文作者 Varun Shenoy 在 AI 基础设施公司 Baseten 从事机器学习推理工作,他并不认同当前闭源 AI 垄断的发展态势,并一一反驳了上述看法。在他看来,开源 AI 通过微调可用于各种领域各种细分场景和任务;相比推理,上下文长度和内容的真实性更为重要;通过亲自微调,用户能够获得更高的控制权和可见度,因此开源也能够提供隐私和安全性方面的保障。

基于此,随着开源模型日渐成熟,因其用户友好性和可定制性,开源将成为众多应用的最佳选择。

(以下内容经授权后由OneFlow编译发布,转载请联系授权。原文:https://varunshenoy.substack.com/p/why-open-source-ai-will-win)

作者 | Varun Shenoy

OneFlow编译

翻译|宛子琳、杨婷

Linux 具有颠覆性。五年前(1991年),谁曾想过一款世界级操作系统会以如此神奇的方式诞生,它由遍布全球、仅通过脆弱的互联网纽带连接的数千名兼职开发人员的努力构建而成。这完全出乎我的意料。

——《大教堂与集市》序言,作者Eric Raymond

在不久的将来,每家公司都将从模型提供者(如OpenAI、Anthropic)那里租用一个“大脑”,并构建基于其认知能力的应用程序。换句话说,AI 正在朝着垄断寡头的方向发展,只有少数重要的语言大模型(LLM)供应商能够存续。

我并不认同这一观点。我坚信,开源对于未来的语言大模型和图像模型的影响将远超公众的预期。

我总会反复看到以下几个反对开源的论点。

1.开源 AI 无法与行业实验室的资源相竞争。构建基础模型的成本十分高昂,因此想要构建 AI 功能的非 AI 公司会将其智能层外包给专门从事该领域的公司。普通公司无法像一个资金充足的优秀研究团队那样,扩展语言大模型或产出创新结果。比如在图像生成领域,Midjourney 遥遥领先于其他任何公司的技术。

2.开源 AI 并不安全。那些在 GPU 上构建智能的疯狂科学家不会使其模型与人类的整体利益对齐,因为对齐可能会降低模型整体性能。

3.开源 AI 缺乏推理(reasoning)能力。开源模型不仅在基准测试中表现比闭源模型较差,而且缺乏涌现功能,例如实现智能体 workflow(agentic workflow)的能力。

这些观点看似合理,但我认为,它们缺乏充分的依据。

1

LLM 对业务至关重要

将任务外包是可行的,前提是非关键业务。

基础设施产品能够帮助用户节省学习 Kubernetes 或雇佣 DevOps 工程师团队的时间和成本。没有公司会自行开发人力资源/账单支付软件。基础设施类产品能够让公司专注于自己的核心业务,“让自家的啤酒口感更好”。

大部分情况下,LLM 并不属于这一类别。一些公司在现有产品上构建 AI 功能,会通过使用 OpenAI 的服务来节省雇佣机器学习工程师的成本。对他们来说,闭源 AI 是最合理的选择。

但还有一整个新的 AI 原生业务类别,对他们来说这种风险太大了。难道他们真的想将依赖于机密数据的核心业务外包给 OpenAI 或 Anthropic?或愿意将未来几年时间花费在“GPT 封装器”上?

当然不会。

如果你正在构建一个 AI 原生产品,其主要目标是尽快摆脱对 OpenAI 的依赖。理想情况下,你可以使用闭源供应商来启动智能层,通过与用户的互动建立数据飞轮,并对自己的模型进行微调,从而提高任务的准确性、降低时延并增强控制力。

每个企业都需要拥有自己的核心产品,对于 AI 原生初创公司来说,他们的核心产品就是基于专有数据训练的模型。在长期使用闭源模型供应商的过程中,会给 AI 原生公司带来不必要的风险。

开源语言模型身上背负太多的期许而不能失败,它的发展关乎许多公司的命运,甚至谷歌也承认,在这个开源大模型的新世界中,他们并没有护城河。

2

推理(reasoning)其实并不重要

LLM 的通用能力使其能够适用于各类用例。其中最重要的任务显而易见:总结、解释并从一段文本中创建列表(或其他结构)等。

对于 85% 的用例,推理并不重要,这种推理通过扩大这些模型规模而获得。研究人员乐于分享其模型的强大能力:2000 亿参数的模型可以解决复杂的数学问题或根据草图构建网站,但我认为,对于大多数用户(或开发者)来说,这种能力并非刚需。

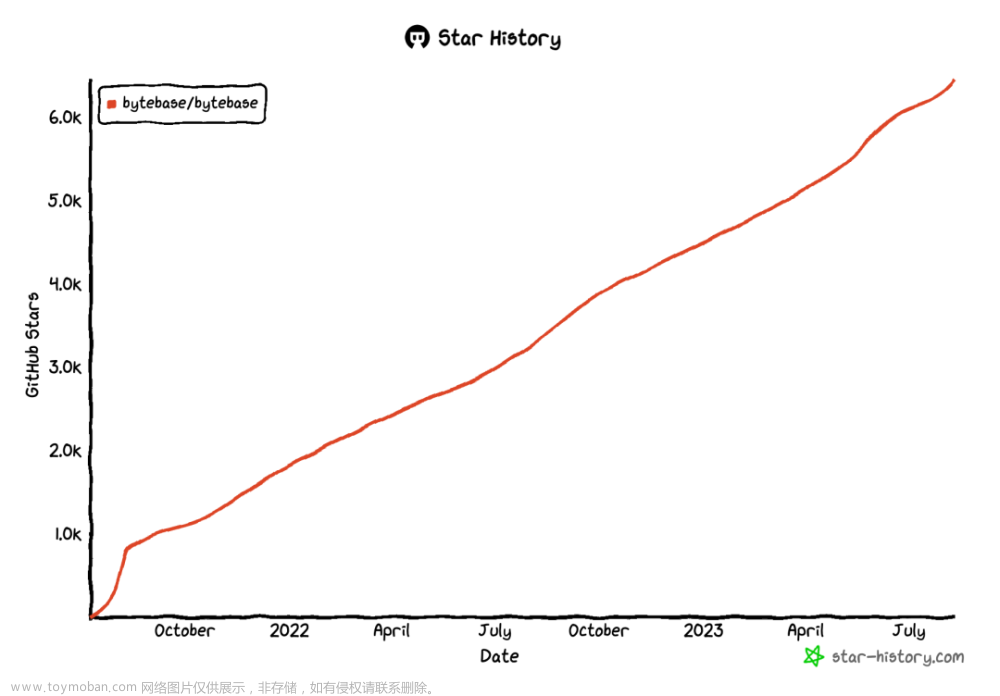

实际上,开源模型在最具价值的任务上表现十分出色,在产品收集到足够的标记数据后,还可以进行微调,以覆盖可能 99% 的用例。

经微调的 Llama 2 vs. GPT-4 (来自 Anyscale)

作为研究人员追求的圣杯,推理可能并没有人们想象的那么重要。

相比推理,上下文长度和内容的真实性更为重要。

我们先从上下文长度谈起。语言模型的上下文长度越长,能输入的提示和聊天记录就越长。

原始 Llama 模型的上下文长度为 2k,Llama 2 为 4k。今年早些时候,一位独立的 AI 黑客发现,对 Llama 2 的 RoPE 嵌入进行一行代码修改,就可以直接扩展上下文长度至 8 K,而无需额外训练。

上周,另一个独立研究项目发布了 YaRN,将 Llama 2 的上下文长度扩展至 128k,而我甚至还没来得及体验 32k 的 GPT-4 ,这体现了开源模型迅猛的发展速度。

尽管上下文长度不断扩展,但运行大模型所需的硬件要求也在不断降低。借助 Llama.cpp 等项目,你现在可以在自己的 MacBook 上运行最先进的语言大模型,能够在本地使用这些模型可以显著提高安全性、降低成本。极端情况下,你可以在用户的硬件上运行自己的模型。模型的规模不断缩小,同时质量保持不变。微软的 Phi-1.5 模型仅有 13 亿个参数,但在多个基准测试中达到了 Llama2 7B 的水平。随着消费者硬件和 GPU 匮乏趋势带来的挑战,开源 LLM 实验将继续蓬勃发展。

关于真实性(truthfulness):相对于闭源模型,开源模型在真实性方面可能会更差,但这在某些情况下实际上是可以接受的,特别是在涉及到讲故事等创造性任务时,幻觉可以被看作是一种特性而不是缺陷。

闭源的 AI 模型有一定的过滤机制,使其内容听起来人工感更强,但趣味性也随即降低。仅有130 亿参数的 MythoMax-L2 讲的故事比 Claude 2 或 ChatGPT 好得多。关于事实性,最新的开源 LLM 在检索增强生成方面表现良好,并且它们还会不断改进。

3

控制性至上

接下来简要了解一下图像生成领域。

我认为,Stable Diffusion XL(SDXL)这个最佳开源模型的性能几乎与 Midjourney 持平。

SDXL 根据提示“一名宇航员和一只羊驼在火星上一起弹吉他”生成的图像。(这些图像均未经挑选,是模型首次生成的结果)

尽管 SDXL 在使用中略显不便,但它的用户可获得数百个社区制作的 LoRA、微调和文本嵌入。用户很快发现 SDXL 在处理手部图像时存在问题,随后的几周时间内,网上就出现了一个修复手部问题的 LoRA。

ControlNet 等其他开源项目在用户构建输出方面为 Stable Diffusion 的用户提供了更强大的助力,而 Midjourney 则不够出色。

Stable Diffusion 和 ControlNet 的工作流程图

此外,Midjourney 模型没有提供 API 接口。因此,如果你想构建一个带有图像扩散功能的产品,就需要以某种方式使用 Stable Diffusion 模型。

这张图片在 Twitter 和 Reddit 上走红。它采用了 Stable Diffusion 与 ControlNet 技术。目前,Midjourney 模型还无法生成这类图片。

开源语言模型 LLM 提供了类似的可控特性和优化功能。

LLM 的 logits,即每次迭代的 token-wise 概率质量函数,可用于生成结构化输出。换句话说,你可以保证生成 JSON,而无需进入可能比较昂贵的“验证重试”循环,但如果你使用 OpenAI 的服务,则需要执行此操作。

来自 NVIDIA 的 logits 示例。

开源模型更轻量级,并且在自己的专用实例上运行,从而降低了端到端的时延。你可以通过批处理查询和使用 vLLM 等推理服务器来提高吞吐量。

还可以应用更多技巧(如推测性采样、并发模型执行、KV 缓存)来改善时延和吞吐量。OpenAI 端点上的时延是封闭模型所能做到的最短时延,这使得它无法用于许多对时延有高要求的产品,而对于大型消费产品来说,它的成本又太高。

除此之外,你还可以在开源模型上使用最高程度的控制微调或训练自己的 LoRA。Axolotl 和 TRL 等框架简化了这一过程。虽然闭源模型供应商也有自己的微调端点,但与自己亲自进行微调相比,你无法获得同等的控制度和可见性。

迄今为止最强大的开源模型 Falcon 180B 于上周发布。几小时内,主要由匿名开发者组成的Discord 频道开始探索如何使用这个新模型作为基础层来重建 GPT-4。

开源也提供了隐私和安全性方面的保障。

你对开源模型中数据的流入和流出进行控制。选择自主托管对许多用户来说是必需的,特别是那些在受监管的领域(如医疗保健)的用户。许多应用程序还需要在专有数据上进行训练和推理。

林纳斯定律(Linus's Law)可以很好地解释安全性:

如果有足够多的测试者和共同开发者,那么就可以快速发现几乎每个问题,并迅速将其解决。

也就是说“如果有足够多的眼睛,那么错误将无处遁形”。

开源是 Linux 成功的原因。用户可以准确地了解到他们将获得什么,并且可以报告错误或尝试通过社区的支持自行修复。

开源模型也是如此。即便是软件2.0,也需要进行审计。否则,底层变化可能会拖应用程序的后腿。这对大多数商业用例无法接受。

最近一份论文显示,OpenAI 的端点会随时间而发生变动。我们无法确定一个完美运行的提示是否能在一个月后产生相同效果。

采用开源进行 AI 技术的研发可以打造一个广泛的监督和平衡网络。全球的科学家和开发者可以互相评议、批评、研究和理解底层机制,从而提高安全性、可靠性、可解释性和信任度。此外,广泛传播知识可以有效推进技术的发展,同时减轻其被滥用的风险。HuggingFace 就是新的 RedHat。

你只能信任你所拥有和控制的模型,黑盒 API 则与此不同。这表明,反对开源 AI 安全性的论点毫无道理。历史经验表明,开源 AI 实际上更安全。

4

炒作才是问题所在

为何人们近期更偏向于模型闭源?主要有两个原因:简单易用,有知名度。

相较于闭源模型,开源模型更难上手一些。相比使用 OpenAI 的 API,使用开源模型,还需雇佣一个机器学习工程师团队进行开发。这在短期内不可避免,这是掌握控制权和提升创新速度的代价。愿意在前沿领域投入时间的人将有机会构建更优质的产品,其使用体验也将得到不断改进。

更棘手的是,闭源已经占据市场主导地位。

闭源模型供应商已经在这个 AI 炒作周期中占据了主导地位。人们没时间研究开源模型,也没有意识到开源模型的潜力。人们所熟知的为数不多的工具提供商是 OpenAI、Pinecone 和 LangChain。

“OPL”堆栈,来自Wen Yang。

人们常常误认为最出名的工具即为最合适的工具。在当前的大规模炒作下,闭源 AI 备受关注,可谓是人尽皆知。但随着开源模型的日益成熟,因其对用户的友好性和可定制性,将成为许多应用的更优选择。

与其被炒作所席卷,有前瞻性的组织将利用这一时期深入了解自身需求,并为充分利用开源 AI 奠定基础。他们将在开源技术上构建具备竞争优势和差异化的 AI 体验。长期来看,这将为他们带来可持续的竞争优势。

对于那些看穿炒作的实用主义者来说,他们始终聚焦于真正开源 AI 的巨大价值,前景依然光明。

其他人都在看

-

通向无监督学习之路

-

英伟达的AI霸主地位会持久吗

-

大模型长上下文运行的关键问题

-

PyTorch创始人:开源成功的方法论

-

LLM的多模态能力、幻觉与研究经验

-

OpenAI首席科学家:直面AGI的可能性

-

NCCL源码解析:机器间Channel连接文章来源:https://www.toymoban.com/news/detail-752611.html

试用OneFlow: github.com/Oneflow-Inc/oneflow/http://github.com/Oneflow-Inc/oneflow/文章来源地址https://www.toymoban.com/news/detail-752611.html

到了这里,关于为什么开源大模型终将胜出?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!