在11月7日OpenAI的首届开发者大会上,除了推出一系列重磅产品之外,还开源了两款产品,全新解码器Consistency Decoder(一致性解码器)和最新语音识别模型Whisper v3。

据悉,Consistency Decoder可以替代Stable Diffusion VAE解码器。该解码器可以改善所有与Stable Diffusion 1.0+ VAE兼容的图像,尤其是在文本、面部和直线方面有大幅度提升。仅上线一天的时间,在Github就收到1100颗星。

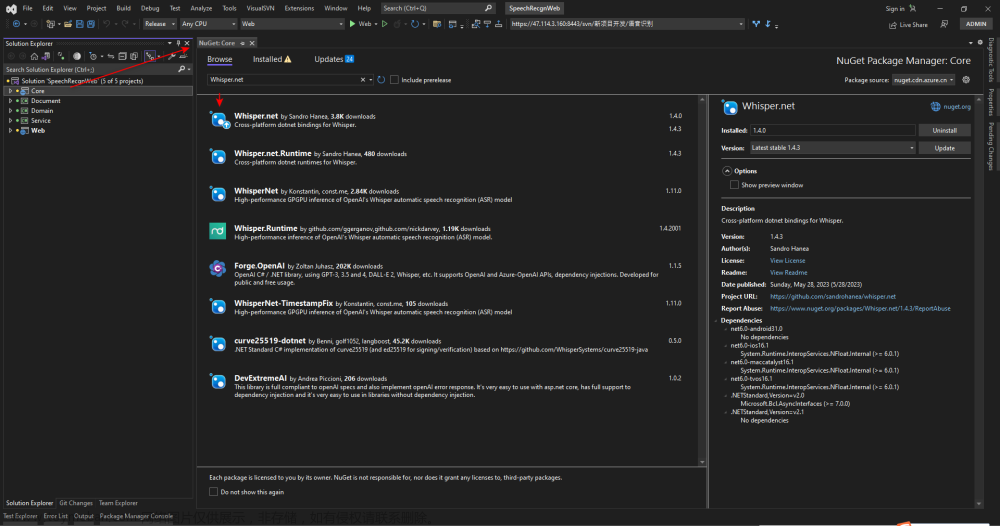

Whisper large-v3是OpenAI之前开源的whisper模型的最新版本,在各种语言上的性能都有显著提升。OpenAI会在未来的API计划中提供Whisper v3。

解码器地址:https://github.com/openai/consistencydecoder

Whisper v3地址:https://github.com/openai/whisper

Consistency Decoder效果展示

Consistency Decoder算是OpenAI“一致性”家族里的新成员,所以,「AIGC开放社区」想为大家介绍一下OpenAI之前开源的另一个创新模型——Consistency Models。

扩散模型的出现极大推动了文生图片、视频、音频等领域的发展,涌现了GAN、VAE等知名模型。但是这些模型在推理的过程中,过于依赖迭代采样过程,导致生成效率非常缓慢或生成图片质量太差。

OpenAI为了突破这个技术瓶颈,提出了Consistency Models(一致性模型)框架并将其开源。该技术的最大优势是支持单步高质量生成,同时保留迭代生成的优点。简单来说,可以使文生图模型在推理的过程中又快又准攻守兼备。

此外,Consistency Models可以通过提取预先训练的扩散模型来使用,也可以作为独立的生成模型来训练,兼容性强且灵活。

开源地址:https://github.com/openai/consistency_models

论文:https://arxiv.org/abs/2303.01469

为了让大家更好的理解Consistency Models技术特点,「AIGC开放社区」先简单的介绍一下扩散模型的原理。

什么是扩散模型

扩散模型主要通过模拟扩散过程来生成数据,核心技术是将数据看作是由一个简单的随机过程(例如,高斯白噪声)经过一系列平滑变换得到的结果。

扩散模型主要由正向过程和反向过程两大块组成。正向过程(扩散过程):首先将原始数据通过添加噪声逐渐扩散,直到变成无法识别的噪声。

具体来说,每一步都会添加一点噪声,噪声的强度通常会随着步骤的进行而增大。这个过程可以用一个随机微分方程来描述。

反向过程(去噪声过程):然后使用一个学习到的模型从噪声数据中重建原始数据。

这个过程通常通过优化一个目标函数来进行,目标是让重建的数据与原始数据尽可能相似。

Consistency Models简单介绍

Consistency Models受扩散模型技术思路启发,直接将噪声映射到数据分布,无需迭代过程直接生成高质量图像。实验证明,如果模型输出在同一轨迹上的点保持一致,可以有效学习此映射。

简单来说,Consistency Models直接放弃了逐步去噪过程,而是直接学习把随机的噪声映射到复杂的图像上,同时加上了一致性的规则约束,避免生成的图像出现“驴唇不对马嘴”的情况。

说的更直白一点,我们如果要做一道麻婆豆腐,需要先切豆腐、配菜,然后放在马勺里进行大火翻炒,再放上调料最后出锅。

而Consistency Models的方法是直接就变出一盘麻婆豆腐,省去了所有制作流程,并且口味、菜品都是按照用户标准来的,这就是该技术的神奇之处。

基于上述技术概念,OpenAI的研究人员使用了知识蒸馏和直接训练两种方法来训练Consistency Models。

知识蒸馏:使用一个预先训练好的扩散模型(如Diffusion),生成一些数据对,然后训练Consistency Models时让这些数据对的输出尽可能接近,来跟扩散模型进行知识蒸馏。

直接训练法:直接从训练集样本中学习数据到噪声的映射,不需要依赖预训练模型。主要是加入噪声进行数据增强,然后优化增强前后的输出一致性。

实验数据

研究人员在多个图像数据集上测试了Consistency Models,包括CIFAR-10、ImageNet 64x64和LSUN 256x256。

结果表明,知识蒸馏训练的Consistency Models效果最好,在所有数据集和步数下均优于现有最好的蒸馏技术Progressive Distillation。

例如,在CIFAR-10上,单步生成达到新记录的FID 3.55,两步生成达到2.93;在ImageNet 64x64上,单步生成FID为6.20,两步生成为4.70,均刷新记录。

直接训练方式下,Consistency Models也显示出强大的能力,在CIFAR-10上打败了大多数单步生成模型,质量接近Progressive Distillation。

此外,该模型支持进行零样本图像编辑,可实现图像去噪、插值、上色、超分辨率生成、笔触生成等多种任务,而无需专门训练。

如有对AI图像感兴趣的同学,推荐这款可以免费使用的智元兔AI设计师文章来源:https://www.toymoban.com/news/detail-752902.html

文章来源地址https://www.toymoban.com/news/detail-752902.html

文章来源地址https://www.toymoban.com/news/detail-752902.html

到了这里,关于OpenAI开源全新解码器和语音识别模型Whisper-v3的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!