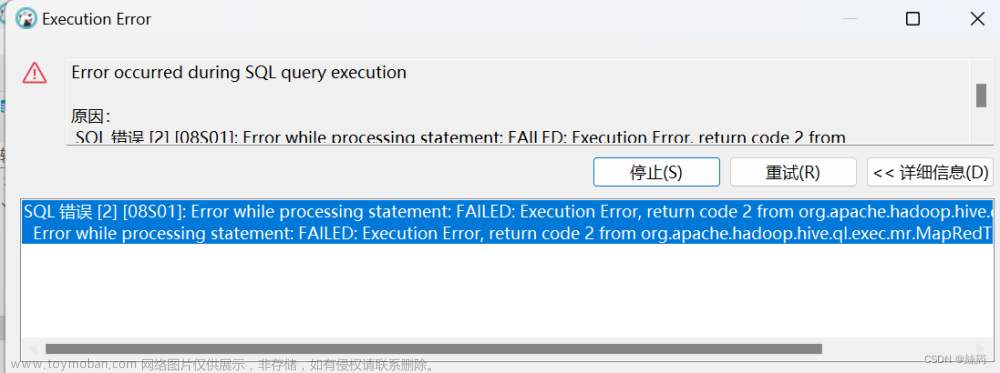

一.问题重现

SQL 错误 [2] [08S01]: Error while processing statement: FAILED: Execution Error, return code 2 from org.apache.hadoop.hive.ql.exec.mr.MapRedTask

Error while processing statement: FAILED: Execution Error, return code 2 from org.apache.hadoop.hive.ql.exec.mr.MapRedTask

Error while processing statement: FAILED: Execution Error, return code 2 from org.apache.hadoop.hive.ql.exec.mr.MapRedTask

二.问题分析

这个错误代码表明 Hive 作业由于某种原因失败。

1.资源问题: 这个错误可能发生在集群上存在资源约束的情况下,例如内存或 CPU 资源不足以完成 Hive 作业。

2.数据问题: 它可能与数据本身相关。例如,数据可能损坏,或者数据格式或模式存在问题,Hive 无法处理。

3.配置问题: 不正确的 Hive 或 Hadoop 配置设置可能导致作业失败。

4.查询错误: 可能是与你尝试执行的 SQL 查询相关的问题。例如,它可能存在语法错误,或者尝试执行 Hive 不支持的操作。

5.权限问题: 你可能没有执行你尝试执行的操作所需的权限。

6.版本冲突:hive和Hadoop版本不兼容。

三.问题解决

为了解决这个问题我们可以尝试以下步骤:

-

检查 Hive 日志以获取有关问题性质的更多详细错误消息。这些日志可以提供有关问题的额外信息。

-

检查你的 SQL 查询,确保它是正确的,并适用于你正在处理的数据和模式。

-

验证你是否具有访问和操作数据所需的权限。

-

确保你的 Hive 和 Hadoop 配置正确设置。

-

如果错误与数据有关,请检查数据是否存在问题,如损坏、缺失值或不正确的格式。

- 考虑咨询你的 Hadoop 或 Hive 管理员以获取进一步的故障排除帮助。

- 检查集群的资源利用情况,看集群资源是否充足。例如CPU和内存

如果确定是集群资源不足,可以在hadoop/etc/hadoop/下yarn-site.sh配置文件添加以下内容

<!--yarn单个容器允许分配的最大最小内存 -->

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>4096</value>

</property>

<!-- yarn容器允许管理的物理内存大小 -->

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<!-- 关闭yarn对物理内存和虚拟内存的限制检查 -->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>排除以上问题之后问题没有解决,如果你插入数据是很多字段,可以尝试减少字段插入数据

例如

这是我原本插入的数据的SQL语句

-- 插入数据

insert overwrite table dw_didi.t_user_order_wide partition(dt='2020-04-12')

select

orderid,telephone,lng,lat,province,city,es_money,gender,profession,age_range,tip,subscribe,

case when subscribe = 0 then '非预约'

when subscribe = 1 then '预约'

end as subscribe_name,sub_time,is_agent,

case when is_agent = 0 then '本人'

when is_agent = 1 then '代叫'

end as is_agent_name,

agent_telephone,

date_format(concat(order_time,':00'),'yyyy-MM-dd') as order_date,

year(date_format(concat(order_time,':00'),'yyyy-MM-dd:ss')) as order_year,

month(date_format(concat(order_time,':00'),'yyyy-MM-dd:ss'))as order_month,

day(date_format(concat(order_time,':00'),'yyyy-MM-dd:ss'))as order_day,

hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss'))as order_hour,

case when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 1 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 5 then '凌晨'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 5 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 8 then '早上'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 8 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 11 then '上午'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 11 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 13 then '中午'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 13 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 17 then '下午'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 17 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 19 then '晚上'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 19 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 20 then '半夜'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 20 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 24 then '深夜'

when hour(date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) > 0 and hour (date_format(concat(order_time,':00'),'yyyy-MM-dd HH:mm:ss')) <= 1 then '深夜'

else 'N/A'

end as order_time_range,

date_format(concat(concat(order_time,':00'),':00'),'yyyy-MM-dd HH:mm:ss') as order_time

from ods_didi.t_user_order WHERE dt = '2020-04-12' and length(order_time) > 8;

SELECT * from dw_didi.t_user_order_wide现在改为

insert overwrite table dw_didi.wide1 partition(dt='2020-04-12')

select

orderid

from ods_didi.t_user_order WHERE dt = '2020-04-12' and length(order_time) > 8;

SELECT * from dw_didi.wide1如果尝试运行之后还是报相同错误

就可以基本判定是hive配置文件的错误

检查配置文件后,如果还是报错,我们可以尝试设置hive的执行引擎

1.下载tez的依赖包:http://tez.apache.org

2.拷贝apache-tez-0.9.1-bin.tar.gz到hadoop102的/export/software目录

3.解压缩apache-tez-0.9.1-bin.tar.gz

tar -zxvf apache-tez-0.9.1-bin.tar.gz -C /export/servers4.进入到Hive的配置目录

/hive/conf

5.在hive-env.sh文件中添加tez环境变量配置和依赖包环境变量配置

vim hive-env.shexport TEZ_HOME=/export/servers/tez-0.9.1 #是你的tez的解压目录

export TEZ_JARS=""

for jar in `ls $TEZ_HOME |grep jar`; do

export TEZ_JARS=$TEZ_JARS:$TEZ_HOME/$jar

done

for jar in `ls $TEZ_HOME/lib`; do

export TEZ_JARS=$TEZ_JARS:$TEZ_HOME/lib/$jar

done

export HIVE_AUX_JARS_PATH=/export/servers/hadoop-2.7.7/share/hadoop/common/hadoop-lzo-0.4.20.jar$TEZ_JARS

6.在hive-site.xml文件中添加如下配置,更改hive计算引擎

<property>

<name>hive.execution.engine</name>

<value>tez</value>

</property>7.在Hive的/export/servers/hive/conf下面创建一个tez-site.xml文件

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>tez.lib.uris</name> <value>${fs.defaultFS}/tez/tez-0.9.1,${fs.defaultFS}/tez/tez-0.9.1/lib</value>

</property>

<property>

<name>tez.lib.uris.classpath</name> <value>${fs.defaultFS}/tez/tez-0.9.1,${fs.defaultFS}/tez/tez-0.9.1/lib</value>

</property>

<property>

<name>tez.use.cluster.hadoop-libs</name>

<value>true</value>

</property>

<property>

<name>tez.history.logging.service.class</name> <value>org.apache.tez.dag.history.logging.ats.ATSHistoryLoggingService</value>

</property>

</configuration>

8.将/export/servers/tez-0.9.1上传到HDFS的/tez路径

hadoop fs -mkdir /tez

hadoop fs -put /export/servers/tez-0.9.1/ /tez

hadoop fs -ls /tez查看结果是这个

/tez/tez-0.9.1运行Tez时检查到用过多内存而被NodeManager杀死进程问题:文章来源:https://www.toymoban.com/news/detail-753482.html

Caused by: org.apache.tez.dag.api.SessionNotRunning: TezSession has already shutdown. Application application_1546781144082_0005 failed 2 times due to AM Container for appattempt_1546781144082_0005_000002 exited with exitCode: -103

For more detailed output, check application tracking page:http://hadoop102:8088/cluster/app/application_1546781144082_0005Then, click on links to logs of each attempt.

Diagnostics: Container [pid=11116,containerID=container_1546781144082_0005_02_000001] is running beyond virtual memory limits. Current usage: 216.3 MB of 1 GB physical memory used; 2.6 GB of 2.1 GB virtual memory used. Killing container.

解决方法:文章来源地址https://www.toymoban.com/news/detail-753482.html

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>到了这里,关于在hive插入数据时出现“Execution Error, return code 2 from org.apache.hadoop.hive.ql.exec.mr.MapRedTask”报错的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!