一、实验介绍

注意力机制作为一种模拟人脑信息处理的关键工具,在深度学习领域中得到了广泛应用。本系列实验旨在通过理论分析和代码演示,深入了解注意力机制的原理、类型及其在模型中的实际应用。

本文将介绍将介绍注意力权重矩阵可视化(矩阵热图heatmap)

二、实验环境

本系列实验使用了PyTorch深度学习框架,相关操作如下:

1. 配置虚拟环境

conda create -n DL python=3.7

conda activate DL

pip install torch==1.8.1+cu102 torchvision==0.9.1+cu102 torchaudio==0.8.1 -f https://download.pytorch.org/whl/torch_stable.html

conda install matplotlib

conda install scikit-learn

2. 库版本介绍

| 软件包 | 本实验版本 | 目前最新版 |

|---|---|---|

| matplotlib | 3.5.3 | 3.8.0 |

| numpy | 1.21.6 | 1.26.0 |

| python | 3.7.16 | |

| scikit-learn | 0.22.1 | 1.3.0 |

| torch | 1.8.1+cu102 | 2.0.1 |

| torchaudio | 0.8.1 | 2.0.2 |

| torchvision | 0.9.1+cu102 | 0.15.2 |

三、实验内容

0. 理论介绍

a. 认知神经学中的注意力

人脑每个时刻接收的外界输入信息非常多,包括来源于视

觉、听觉、触觉的各种各样的信息。单就视觉来说,眼睛每秒钟都会发送千万比特的信息给视觉神经系统。人脑通过注意力来解决信息超载问题,注意力分为两种主要类型:

-

聚焦式注意力(Focus Attention):

- 这是一种自上而下的有意识的注意力,通常与任务相关。

- 在这种情况下,个体有目的地选择关注某些信息,而忽略其他信息。

- 在深度学习中,注意力机制可以使模型有选择地聚焦于输入的特定部分,以便更有效地进行任务,例如机器翻译、文本摘要等。

-

基于显著性的注意力(Saliency-Based Attention)

- 这是一种自下而上的无意识的注意力,通常由外界刺激驱动而不需要主动干预。

- 在这种情况下,注意力被自动吸引到与周围环境不同的刺激信息上。

- 在深度学习中,这种注意力机制可以用于识别图像中的显著物体或文本中的重要关键词。

在深度学习领域,注意力机制已被广泛应用,尤其是在自然语言处理任务中,如机器翻译、文本摘要、问答系统等。通过引入注意力机制,模型可以更灵活地处理不同位置的信息,提高对长序列的处理能力,并在处理输入时动态调整关注的重点。

b. 注意力机制:

-

注意力机制(Attention Mechanism):

- 作为资源分配方案,注意力机制允许有限的计算资源集中处理更重要的信息,以应对信息超载的问题。

- 在神经网络中,它可以被看作一种机制,通过选择性地聚焦于输入中的某些部分,提高了神经网络的效率。

-

基于显著性的注意力机制的近似: 在神经网络模型中,最大汇聚(Max Pooling)和门控(Gating)机制可以被近似地看作是自下而上的基于显著性的注意力机制,这些机制允许网络自动关注输入中与周围环境不同的信息。

-

聚焦式注意力的应用: 自上而下的聚焦式注意力是一种有效的信息选择方式。在任务中,只选择与任务相关的信息,而忽略不相关的部分。例如,在阅读理解任务中,只有与问题相关的文章片段被选择用于后续的处理,减轻了神经网络的计算负担。

-

注意力的计算过程:注意力机制的计算分为两步。首先,在所有输入信息上计算注意力分布,然后根据这个分布计算输入信息的加权平均。这个计算依赖于一个查询向量(Query Vector),通过一个打分函数来计算每个输入向量和查询向量之间的相关性。

-

注意力分布(Attention Distribution):注意力分布表示在给定查询向量和输入信息的情况下,选择每个输入向量的概率分布。Softmax 函数被用于将分数转化为概率分布,其中每个分数由一个打分函数计算得到。

-

打分函数(Scoring Function):打分函数衡量查询向量与输入向量之间的相关性。文中介绍了几种常用的打分函数,包括加性模型、点积模型、缩放点积模型和双线性模型。这些模型通过可学习的参数来调整注意力的计算。

-

加性模型: s ( x , q ) = v T tanh ( W x + U q ) \mathbf{s}(\mathbf{x}, \mathbf{q}) = \mathbf{v}^T \tanh(\mathbf{W}\mathbf{x} + \mathbf{U}\mathbf{q}) s(x,q)=vTtanh(Wx+Uq)

-

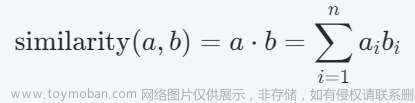

点积模型: s ( x , q ) = x T q \mathbf{s}(\mathbf{x}, \mathbf{q}) = \mathbf{x}^T \mathbf{q} s(x,q)=xTq

-

缩放点积模型: s ( x , q ) = x T q D \mathbf{s}(\mathbf{x}, \mathbf{q}) = \frac{\mathbf{x}^T \mathbf{q}}{\sqrt{D}} s(x,q)=DxTq (缩小方差,增大softmax梯度)

-

双线性模型: s ( x , q ) = x T W q \mathbf{s}(\mathbf{x}, \mathbf{q}) = \mathbf{x}^T \mathbf{W} \mathbf{q} s(x,q)=xTWq (非对称性)

-

-

-

软性注意力机制:

-

定义:软性注意力机制通过一个“软性”的信息选择机制对输入信息进行汇总,允许模型以概率形式对输入的不同部分进行关注,而不是强制性地选择一个部分。

-

加权平均:软性注意力机制中的加权平均表示在给定任务相关的查询向量时,每个输入向量受关注的程度,通过注意力分布实现。

-

Softmax 操作:注意力分布通常通过 Softmax 操作计算,确保它们成为一个概率分布。

-

1. 注意力权重矩阵可视化(矩阵热图)

a. 导入必要的库

import torch

from d2l import torch as d2l

b. 可视化矩阵热图(show_heatmaps)

可视化矩阵热图~展示注意力权重

def show_heatmaps(matrices, xlabel, ylabel, titles=None, figsize=(2.5, 2.5), cmap='Reds'):

"""显示矩阵热图"""

d2l.use_svg_display()

num_rows, num_cols = matrices.shape[0], matrices.shape[1]

fig, axes = d2l.plt.subplots(num_rows, num_cols, figsize=figsize,

sharex=True, sharey=True, squeeze=False)

for i, (row_axes, row_matrices) in enumerate(zip(axes, matrices)):

for j, (ax, matrix) in enumerate(zip(row_axes, row_matrices)):

pcm = ax.imshow(matrix.detach().numpy(), cmap=cmap)

if i == num_rows - 1:

ax.set_xlabel(xlabel)

if j == 0:

ax.set_ylabel(ylabel)

if titles:

ax.set_title(titles[j])

fig.colorbar(pcm, ax=axes, shrink=0.6)

-

参数解释:

-

matrices: 一个包含要显示的矩阵的张量,可以是单个矩阵或矩阵的列表。如果是列表,它应该是一个形状为(num_rows, num_cols)的张量,其中每个元素是要显示的一个矩阵。 -

xlabel和ylabel: x轴和y轴的标签。 -

titles(可选): 一个包含图形标题的列表,用于标识每列矩阵的标题。 -

figsize(可选): 一个包含图形大小的元组。 -

cmap(可选): 用于绘制热图的颜色映射。

-

-

函数流程:

-

使用

d2l.use_svg_display()将图形显示格式设置为SVG。 -

获取矩阵的行数和列数。

-

使用

d2l.plt.subplots()创建一个包含子图的图形,遍历每个子图:- 使用

ax.imshow()显示矩阵的热图。 - 设置标签、标题等属性。

- 如果提供了

titles,则为每列矩阵设置标题。

- 如果提供了

- 使用

-

使用

fig.colorbar()添加颜色条。

-

c. 实验结果

- 将单位矩阵变形为四维张量,表示一个注意力权重矩阵。

# torch.eye 返回一个对角线元素为1,其余元素为0的矩阵。

attention_weights = torch.eye(10).reshape((1, 1, 10, 10))

show_heatmaps(attention_weights, xlabel='Keys', ylabel='Queries')

文章来源:https://www.toymoban.com/news/detail-754998.html

文章来源:https://www.toymoban.com/news/detail-754998.html

- 创建一个大小为 1x1x10x10 的张量作为权重矩阵,其中的元素是在0和1之间均匀随机生成的。

attention_weights = torch.rand(1, 1, 10, 10)

show_heatmaps(attention_weights, xlabel='Keys', ylabel='Queries')

文章来源地址https://www.toymoban.com/news/detail-754998.html

文章来源地址https://www.toymoban.com/news/detail-754998.html

到了这里,关于【深度学习实验】注意力机制(一):注意力权重矩阵可视化(矩阵热图heatmap)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!