LLM

大语言模型(Large Language Model,LLM)是一种利用大量文本数据进行训练的自然语言处理模型,其评价可以从多个方面进行。

以下是一些主要的评价方面:

- 语言理解和生成能力:评价大语言模型在自然语言理解(如语义理解、实体识别、情感分析等)和自然语言生成(如文本生成、机器翻译、对话系统等)方面的表现。可以通过与其他现有技术和方法的比较,以及通过各种评估指标(如BLEU、ROUGE、BERTScore等)来衡量其性能。

- 逻辑推理和常识能力:评价大语言模型在解决逻辑推理和常识问题方面的能力,如问答、推理任务等。可以通过评价其回答的逻辑合理性和常识应用的准确性来衡量其性能。

- 语言风格和情感表达:评价大语言模型在生成具有特定风格和情感表达的文本方面的能力。可以通过与人类编写的文本进行比较,以评估其在风格和情感表达方面的相似性和连贯性。

- 跨语言和跨领域能力:评价大语言模型在不同语言和领域上的泛化能力。可以通过训练和测试模型在不同语言和领域的数据集上进行评估,以衡量其跨语言和跨领域的性能。

- 模型的大小和计算效率:评价大语言模型的模型大小和计算效率,以衡量其可扩展性和实用性。可以通过比较不同模型的大小和计算速度来评估其性能。

- 伦理和道德方面:评价大语言模型在伦理和道德方面的表现,如避免生成有害或不道德的内容,保护用户隐私等。可以通过审计和监督机制来确保模型的应用符合道德和法律标准。

优点:

- 数据驱动:大语言模型可以从海量数据中学习语言规律和知识,从而提高语言生成和理解的能力。

- 泛化能力:通过大规模数据训练,大语言模型具备良好的泛化能力,能在面对未见过的问题和任务时,做出准确的预测和生成。

- 应用广泛:大语言模型可应用于多种自然语言处理任务,如文本生成、对话系统、机器翻译、文本分类等。

- 强大的上下文理解能力:大语言模型能够理解复杂的语义和上下文,从而在处理问题时更加准确。

缺点:

- 结果依赖训练语料:大语言模型的输出结果受到训练数据的影响,可能存在偏见和不准确性。

- 训练成本高:大语言模型的训练需要大量的计算资源和时间,对硬件设备和算力有较高要求。

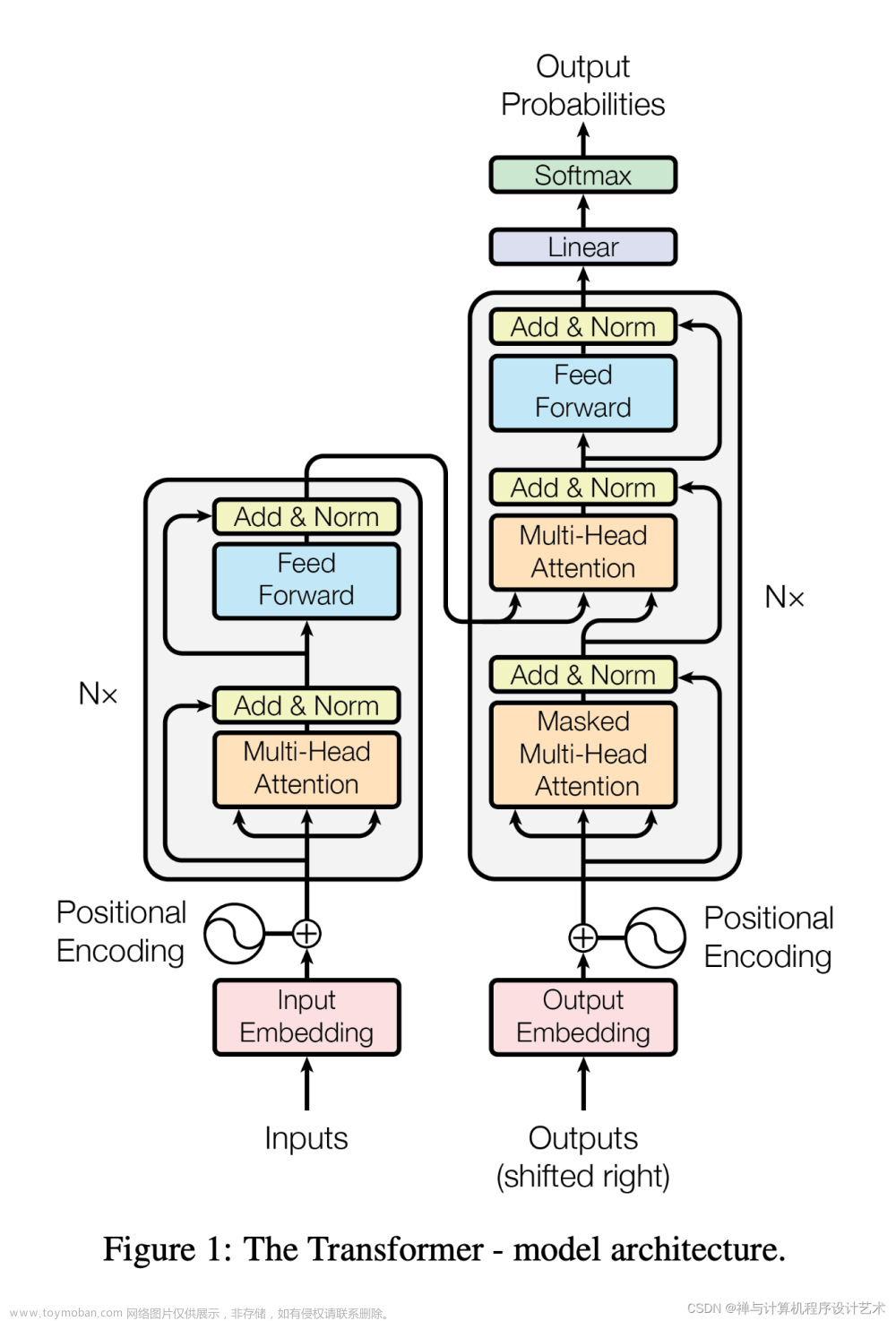

- 解释性不足:大语言模型的工作原理基于深度神经网络,其内部结构复杂,解释性较差,不易理解模型的决策过程。

- 上下文理解局限性:尽管大语言模型具有强大的上下文理解能力,但在一些复杂的语义和上下文理解方面,仍存在一定的局限性。

总之,大语言模型的评价涉及多个方面,需要综合考虑其在语言理解、生成、逻辑推理、常识应用、语言风格、情感表达、跨语言和跨领域等方面的表现,以及模型的大小、计算效率和伦理道德方面的问题。通过综合评估这些方面,可以更好地了解大语言模型的性能和潜在应用价值。

RLHF

RLHF(Reinforcement Learning from Human Feedback)是一种通过人类反馈来训练人工智能模型的方法,旨在使模型与人类的价值观和对齐。然而,由于RLHF方法的一些局限性,制定一套人工标准准则来确保其安全、可靠和有效地应用变得至关重要。这些准则可以帮助研究人员和开发者更好地理解、改进和应用RLHF方法,以降低潜在的风险和负面影响。

以下是RLHF人工标准准则的建议:文章来源:https://www.toymoban.com/news/detail-755526.html

- 透明度和可解释性:确保RLHF模型的决策过程和训练数据是透明的,以便用户和公众能够理解和预测模型的行为。

- 数据质量和来源:确保用于训练RLHF模型的数据质量和来源,以避免错误信息和偏见在模型中传播。

- 人类反馈的质量和可靠性:确保提供反馈的人类专家具有专业知识和道德观念,以保证反馈的质量和可靠性。

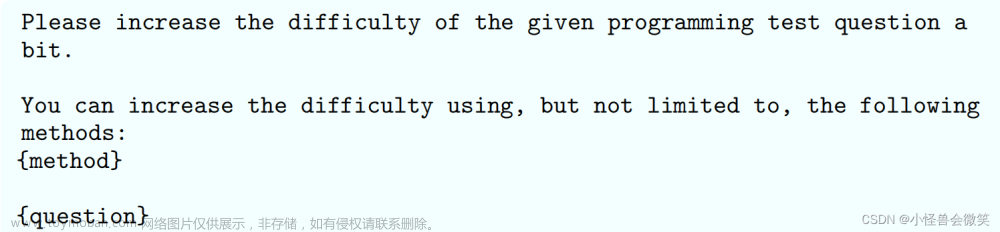

- 模型训练和优化:制定严格的模型训练和优化流程,以确保模型在训练过程中不会产生有害或不道德的行为。

- 审计和监督:建立审计和监督机制,以确保RLHF模型的应用符合道德和法律标准,并保护用户隐私和权益。

- 跨学科合作:鼓励跨学科合作,以便更好地理解和解决RLHF方法在实际应用中可能遇到的问题和挑战。

- 持续改进和更新:不断收集和分析关于RLHF方法的应用数据和反馈,以便及时发现并解决潜在的安全隐患和局限性。

遵循这些人工标准准则,研究人员和开发者可以更安全、可靠地应用RLHF方法,以促进人工智能技术的发展和普及。文章来源地址https://www.toymoban.com/news/detail-755526.html

到了这里,关于AI:大语言模型LLM的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!