引言

MistralAI,一家法国的初创企业,近期在AI界引发了轰动,刚刚发布了全球首个基于MoE(Mixture of Experts,混合专家)技术的大型语言模型——Mistral-8x7B-MoE。这一里程碑事件标志着AI技术的一个重要突破,尤其是在模型结构和效率上的创新,让它在业界赢得了“超越GPT-4”的评价。

huggingface模型下载:https://huggingface.co/DiscoResearch/DiscoLM-mixtral-8x7b-v2

AI快站模型免费加速下载:https://aifasthub.com/models/DiscoResearch

Mistral-8x7B-MoE的核心特点

Mistral-8x7B-MoE由8个拥有70亿参数的专家网络组成,每个token的处理交由最相关的两个专家进行。这种结构不仅提高了模型处理信息的效率,还降低了运行成本。MoE技术的应用使得MistralAI的这款新模型在处理复杂任务时更加高效,相比于传统的大型单一模型,它能够更精准地处理各种类型的数据。

模型参数的具体配置如下:

性能与应用

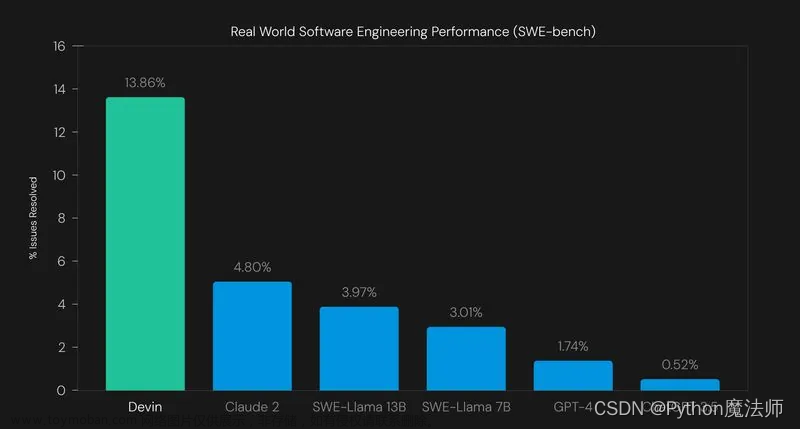

虽然Mistral-8x7B-MoE的具体性能数据尚未全面公开,但初步的社区评测显示,它在多个任务上的表现超越了前身Mistral-7B,甚至在某些方面接近或超越了GPT-4。这一性能提升,使其成为了当前AI开发者和研究人员的新宠。OpenCompass 的最新基准测试结果显示 Mixtral-8x7B 超过 llama-2-70B。

开源与商业化前景

MistralAI坚持使用Apache-2.0开源协议,使得Mistral-8x7B-MoE可免费商用,为企业和开发者提供了更多的可能性。它的开源性质不仅降低了使用门槛,还促进了AI领域的创新和发展。部署Mixtral 8x7B 模型需要 100GB 左右显存,因此完全可以在 8x3090 或 8x4090 GPU实例上运行。

结论

MistralAI的Mistral-8x7B-MoE模型不仅在技术上实现了重大突破,还为未来AI模型的发展方向提供了新的思路。这款基于MoE技术的大模型,不仅预示着AI领域的新篇章,也将推动整个行业向着更高效、更灵活的方向发展。

模型下载

huggingface模型下载

https://huggingface.co/DiscoResearch/DiscoLM-mixtral-8x7b-v2

AI快站模型免费加速下载

https://aifasthub.com/models/DiscoResearch

磁力下载文章来源:https://www.toymoban.com/news/detail-756621.html

magnet:?xt=urn:btih:5546272da9065eddeb6fcd7ffddeef5b75be79a7&dn=mixtral-8x7b-32kseqlen&tr=udp%3A%2F%http://2Fopentracker.i2p.rocks%3A6969%2Fannounce&tr=http%3A%2F%http://2Ftracker.openbittorrent.com%3A80%2Fannounce文章来源地址https://www.toymoban.com/news/detail-756621.html

到了这里,关于MistralAI发布全球首个MoE大模型-Mixtral 8x7B,创新超越GPT-4的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!