一、引言

随着网络技术的发展,网站为了保护自己的数据和资源,纷纷采用了各种反爬虫机制。然而,逆向爬虫技术的出现,使得我们可以突破这些限制,实现对目标网站的深入分析和抓取。本文将介绍逆向爬虫进阶实战的一些技巧和代码片段,帮助读者更好地理解和掌握这一技术。

二、逆向爬虫进阶技巧

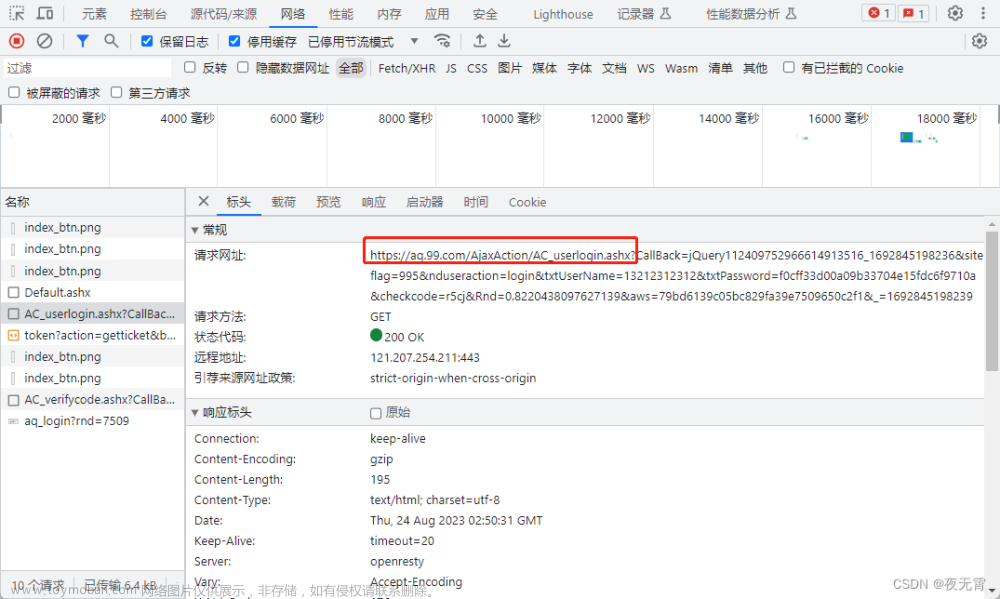

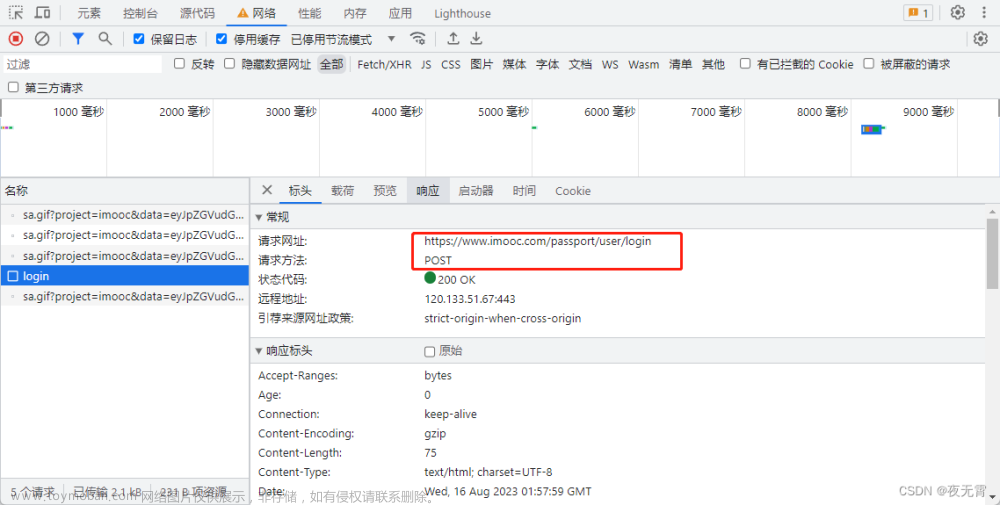

分析网站结构:首先,我们需要对目标网站的结构进行深入分析,了解其数据来源、请求方式、加密方式等。这可以通过查看网页源代码、使用开发者工具进行抓包等方式实现。

模拟浏览器行为:为了绕过基于JavaScript的反爬虫机制,我们可以使用Selenium等工具模拟浏览器行为。这样,我们就可以像正常用户一样访问网站,获取需要的数据。

使用代理IP:为了规避IP封锁等反爬虫机制,我们可以使用代理IP。这样,我们的真实IP地址就会被隐藏起来,从而突破限制。

分析加密算法:有些网站会对请求参数进行加密处理,以增加爬虫的难度。为了解决这个问题,我们需要分析加密算法,找出加密规律,然后对请求参数进行正确的加密处理。

验证码识别:对于使用验证码的网站,我们可以使用OCR(光学字符识别)技术进行识别。这样,我们就可以自动化地输入验证码,完成登录等操作。

三、逆向爬虫进阶实战代码片段

以下是一个使用Python和Selenium模拟浏览器行为抓取数据的代码片段:

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

# 启动浏览器并访问目标网站

driver = webdriver.Chrome()

driver.get("https://www.example.com")

# 输入用户名和密码并登录

username = driver.find_element_by_name("username")

password = driver.find_element_by_name("password")

username.send_keys("your_username")

password.send_keys("your_password")

password.send_keys(Keys.RETURN)

# 等待页面加载完成

time.sleep(5)

# 获取需要的数据并保存到本地文件

data = driver.find_element_by_id("data").text

with open("data.txt", "w") as f:

f.write(data)

# 关闭浏览器并退出程序

driver.quit()

这个代码片段演示了如何使用Selenium模拟浏览器行为登录一个网站,并获取需要的数据保存到本地文件。在实际应用中,我们还需要根据目标网站的具体情况进行适当的修改和优化。

四、总结与展望

逆向爬虫进阶实战是一项具有挑战性和实用性的技术。通过对网站结构、加密算法、验证码识别等方面进行深入研究和探索,我们可以突破各种反爬虫机制的限制,实现对目标网站的深入分析和抓取。未来随着网络技术的不断发展,逆向爬虫技术也将不断进步和完善为我们的生活和工作带来更多的便利和可能性。

好书推荐

购书链接:点此进入

内容简介

本书以爬虫逆向方向的相关技术和岗位要求进行撰写,总结了爬虫的架构体系、主流框架和未来发展。书中包括各种自动化工具、抓包工具、逆向工具的使用。核心内容以Web Js逆向、安卓逆向、小程序逆向为主,结合三十多个实战案例进行分析,内容从易到难,循序渐进。另外还对主流的反爬虫技术进行了讲解,包括传输协议、验证码体系、字符集映射、行为和指纹等。扫描封底二维码,可获得反爬虫补充知识;扫描节中二维码,可获得配套视频讲解知识。

本书适合对爬虫逆向感兴趣,想进一步提升自我的程序员参考阅读。

作者简介

李玺,作者久居一线开发,目前就职中科大数据研究院。深耕爬虫和逆向方向,拥有丰富的经验和精湛的技巧,独立开发过Asyncpy爬虫框架、crawlx爬虫管理平台。作者是CSDN博客专家,爬虫逆向社区站长,荣获CSDN首届GEEK 原创大赛一等奖、2019、2020、2021年博客之星。拥有多项爬虫领域发明专利,新工科大数据技术能力认证,国家科技志愿者,河南省中原科技城E类人才。

前言节选

大数据时代下,传统的数据采集方法已经无法满足高质量研究的需求,网络爬虫通常能在有限的资源下保障数据的质量和数量,但是各种各样的反爬虫方式导致了爬虫工程师所需的技术栈越来越广泛。

撰写本书的目的有两点,一是为了对自己多年的从业经验做一个总结,二是为了对工作或学习到一定阶段感到迷茫和遇到瓶颈的爬虫工程师提供方向和方法。

笔者从招聘网上采集了阶段月薪在两万元以上的高级爬虫工程师、爬虫架构师的岗位要求,总结出了以下进阶技能,本书也主要对这些技能进行分享和案例讲解。

精通爬虫框架,如Scrapy、Pyspider、Webmagic、Nutch、Heritrix等。

熟悉Fiddler、Charles、httpCanary等抓包工具。

具有Js逆向、App逆向、小程序抓取相关经验。

熟悉Android的Hook技术,熟悉各类Hook框架如Xposed、Frida、Unidbg等。

熟悉模拟器、Selenium、Pyppeteer、Airtest等自动化工具。

掌握验证码识别技术。

有信息抽取、文本分类、数据处理、机器学习等相关工作经验。

本书分10章,包括:网络爬虫架构、Python爬虫技巧、Web JS逆向、自动化工具的应用、抓包工具的应用、Android逆向、小程序逆向、抓包技巧汇总、Android逆向案例、验证码识别技术。工具皆为企业级应用工具,在全书30多个实战案例中都有对应的应用场景。

本书对于大家所擅长的开发语言并没有要求,进阶为高级爬虫工程师需要了解和掌握的技术内容十分广泛,不局限于编程语言,不拘泥于采集方法。文章来源:https://www.toymoban.com/news/detail-756857.html

本书适合有一定基础的读者,笔者跳过了一些细枝末节的东西,更多地在讲述如何应用和解决方法,案例代码以Python语言为主。相对于其他同类书来说,笔者选择去掉那些食之无味的安装教程,秉承让大家多在互联网上练习资源检索能力的目的,一些容易找到的软件也没有提供下载地址和安装步骤。文章来源地址https://www.toymoban.com/news/detail-756857.html

到了这里,关于逆向爬虫进阶实战:突破反爬虫机制,实现数据抓取的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!