在Windows电脑上部署自然语言大模型:完整指南

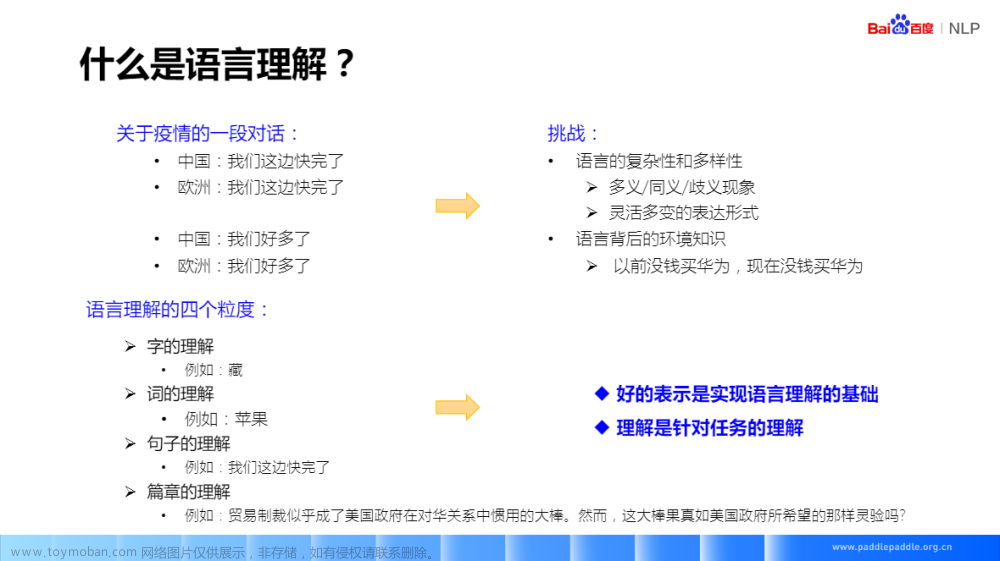

自然语言处理(NLP)的模型越来越强大,人们越来越想把这些模型部署在自己的电脑上。本文就将详细指导你如何在Windows电脑上部署自然语言大模型,包括CUDA的安装,运行环境的搭建,Python载入模型以及模型下载网址等内容。

硬件要求

首先,你需要一个支持CUDA的NVIDIA显卡。CUDA是NVIDIA推出的一种可编程的图形处理器架构,它让你的GPU可以处理并行运算任务,大大提高模型训练和运行的效率。

CUDA的安装

- 前往NVIDIA官网(https://developer.nvidia.com/cuda-downloads)下载CUDA Toolkit,选择适合你系统和显卡的版本。例如,如果你的电脑是Windows 10,显卡是RTX 2080,那么你应该选择CUDA 11.x的版本。

- 下载完成后,双击安装包,按照提示进行安装。安装过程中需要选择“自定义安装”,确保勾选“CUDA”和“显卡驱动”两项。

- 安装完成后,你可以在命令提示符中输入

nvcc --version来检查CUDA是否安装成功。如果出现了CUDA的版本信息,说明CUDA已经成功安装。

Python环境的搭建

你需要安装Python和一些必要的Python库。我们推荐使用Anaconda,这是一个方便的Python版本和库管理工具。

- 前往Anaconda官网(https://www.anaconda.com/products/distribution)下载安装包,并按照提示进行安装。

- 安装完成后,打开Anaconda Prompt,创建一个新的Python环境。例如,你可以输入

conda create -n nlp python=3.8来创建一个名为nlp的环境,Python版本为3.8。 - 激活新建的环境,输入

conda activate nlp。 - 在新环境中安装必要的库,例如,TensorFlow或PyTorch。你可以使用pip进行安装,如

pip install torch。

下载和载入模型

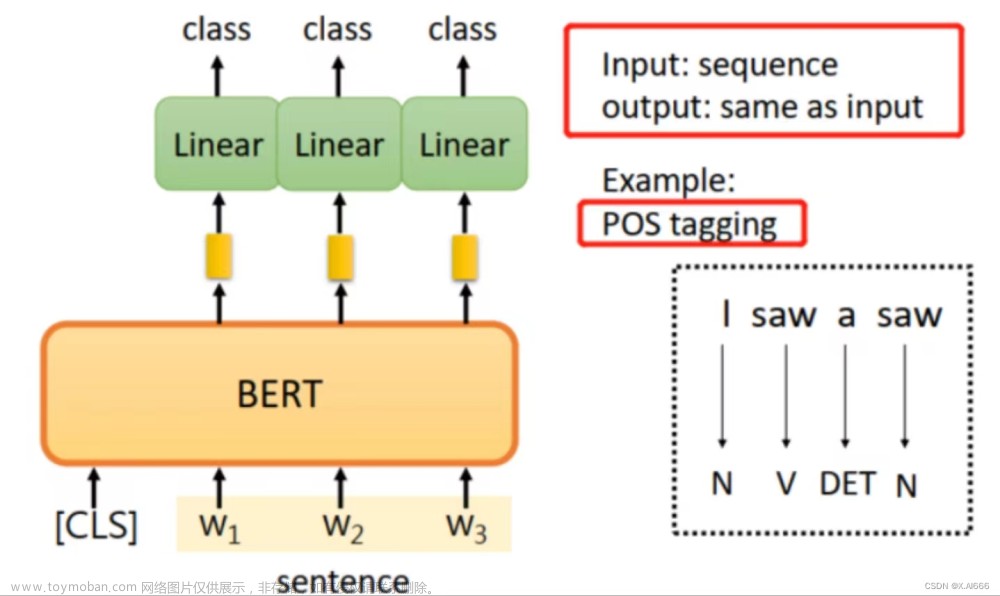

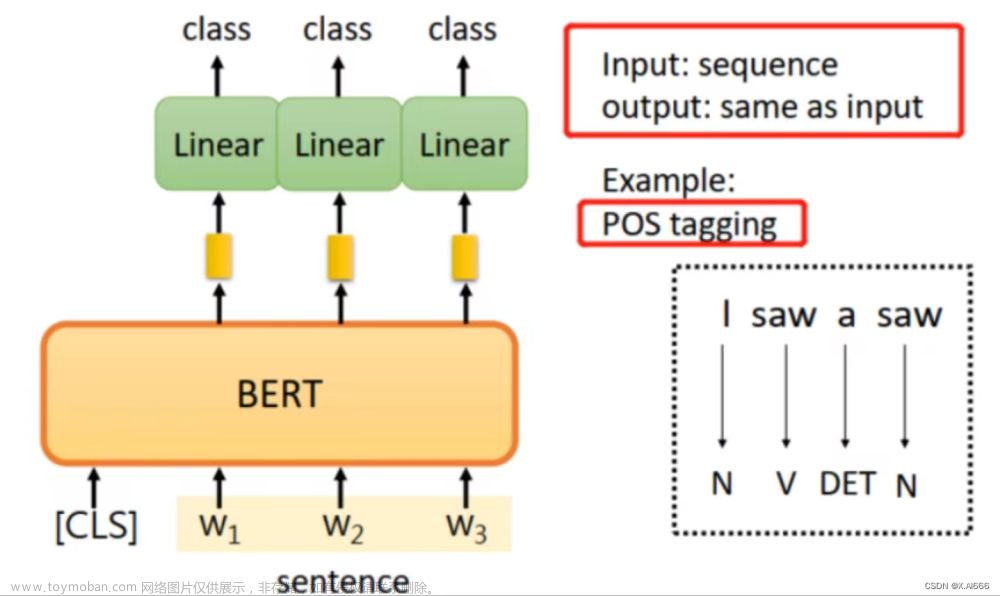

有许多预训练的NLP模型可以供我们使用,例如GPT-2、BERT和RoBERTa。这些模型通常都可以从模型库,如Hugging Face(https://huggingface.co/models)下载。

以GPT-2为例:

- 在激活的Python环境中,安装transformers库。输入

pip install transformers。 - 下载模型。在Python环境中,你可以使用以下代码来下载和载入模型:

from transformers import GPT2LMHeadModel, GPT2Tokenizer

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2")

这段代码会自动从Hugging Face下载GPT-2模型和对应的分词器。文章来源:https://www.toymoban.com/news/detail-757372.html

至此,你已经成功在自己的Windows电脑上部署了一个自然语言大模型。你可以开始使用它进行预测,例如生成文本或分类任务。祝你使用愉快!文章来源地址https://www.toymoban.com/news/detail-757372.html

到了这里,关于在Windows电脑上部署自然语言大模型:完整指南的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!