本心、输入输出、结果

通义千问开源了 720 亿、70亿、140亿、Qwen-VL 四个大模型:实现“全尺寸、全模态”开源

编辑:简简单单 Online zuozuo

地址:https://blog.csdn.net/qq_15071263

个人简介 : 简简单单Online zuozuo,目前主要从事 Java 相关工作,商业方向为 B、G 端,主要使用Java、Python 进行日常开发,喜欢探索各个方面的内容,对很多的方向、内容感兴趣 :目前对 AIGC、云计算、物联网方向感兴趣

未闻万里蓬莱,而窥先圣遗智。故,以此生筑梦,奔而逐之;以泰山之伟,攀而登之;以静雅素心,处世为人。

欢迎有兴趣的朋友相互交流,共同成长。微信: tja6288 商务合作/资料获取/技术交流

如果觉得本文对你有帮助,欢迎点赞、收藏、评论

前言

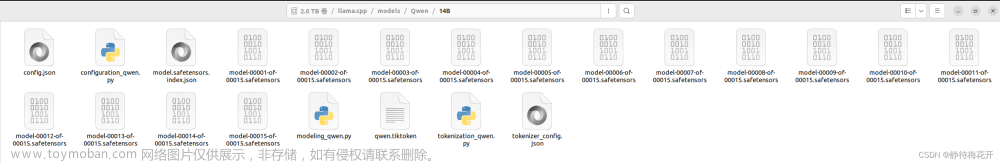

2023年12月1日,阿里云宣布通义千问720亿参数模型Qwen-72B开源,一同开源的还有18亿参数模型Qwen-1.8B和音频大模型Qwen-Audio。加上之前开源的70亿、140亿参数的2款大语言模型,以及视觉理解模型Qwen-VL,通义千问实现了“全尺寸、全模态”开源。

阿里云CTO周靖人

阿里云CTO周靖人表示:

开源生态对促进中国大模型的技术进步与应用落地至关重要,通义千问将持续投入开源,希望成为‘AI时代最开放的大模型’,与伙伴们共同促进大模型生态建设

8月以来开源的大模型Qwen-7B(70亿参数)、Qwen-14B(140亿参数)和视觉理解模型Qwen-VL得到中小企业和个人开发者的青睐,累计下载量超过150万,催生出150多款新模型、新应用

通义千问闭源模型也在持续进化,一个月前发布的通义千问2.0版闭源模型,最近已进阶至2.1版,上下文窗口长度扩展到32k,代码理解生成能力、数学推理能力、中英文百科知识、幻觉诱导抵抗能力分别提升30%、10%、近5%和14%,用户可以在通义千问APP免费体验最新版本的闭源模型

阿里云

阿里云方面表示:

此前中国大模型市场还没出现足以对标国外Llama 2-70B的优质开源模型,Qwen-72B抬升了开源大模型的尺寸和性能,是业界最强开源模型,填补了国内空白。基于Qwen-72B,大中型企业可开发商业应用,高校、科研院所可开展AI for Science等科研工作

72B 的通义千问性能如何

本次开源的Qwen-72B性能更胜一筹,在10个权威基准测评中夺得开源模型最优成绩,在部分测评中超越闭源的GPT-3.5和GPT-4。据悉,Qwen-72B可以处理最多32k的长文本输入,在长文本理解测试集LEval上取得了超越ChatGPT-3.5-16k的效果。研发团队优化了Qwen-72B的指令遵循、工具使用等技能,使之能更好地被下游应用集成

用户可在魔搭社区直接体验Qwen系列模型效果,也可通过阿里云灵积平台调用模型API(应用程序接口),或基于阿里云百炼平台定制大模型应用。阿里云人工智能平台PAI针对通义千问全系列模型进行深度适配,推出了轻量级微调、全参数微调、分布式训练、离线推理验证、在线服务部署等服务

Qwen-1.8B

Qwen-1.8B “向下探底”,成为中国尺寸最小的开源大模型,推理2K长度文本内容仅需3G显存,可在消费级终端部署

花有重开日,人无再少年

在这个充满困难和挑战的时期内,我们依然应该保持积极向上,放下遥不可及的欲望,平凡的普通人也可以成就自己的小梦想

在这个充满变化和无限可能的世界里,每一天都是新的开始。让我们拥抱今天,以积极乐观的心态去面对生活的挑战和机遇。

无论我们遇到什么困难,都要相信自己的力量和智慧,勇敢地迎接挑战。因为每一次的克服和超越,都将使我们的生命更加丰富多彩。

我们要学会欣赏生活中的美好事物,用感恩的心去珍惜所拥有的一切。这样,我们就会发现,快乐其实就在我们的身边,时时刻刻陪伴着我们。

让我们保持对未来的信心和热情,勇敢地追求自己的梦想。无论路途多么艰辛,只要我们坚持不懈,终将实现自己的目标。

让我们一起相信,只要我们心中充满阳光,就没有什么能够阻挡我们前进的步伐。让我们用积极乐观的心态,书写属于我们的精彩人生!

实践是检验真理的唯一标准

✅ 🥶 😎 😟 😲 😰 😭 😓

🔔️ 😂 😅 😍 😘 😚 😜 🤢

👿 💀 👽 👾 😻 💕 💔 💯

💦 💤 🤝 🙍♂️ 🙍 🍊 🍉 🍏文章来源:https://www.toymoban.com/news/detail-757560.html

感谢亲的点赞、收藏、评论,一键三连支持,谢谢 文章来源地址https://www.toymoban.com/news/detail-757560.html

到了这里,关于通义千问开源了 720 亿、70亿、140亿、Qwen-VL 四个大模型:实现“全尺寸、全模态”开源的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!