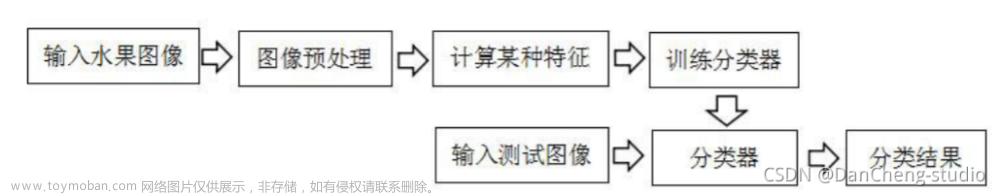

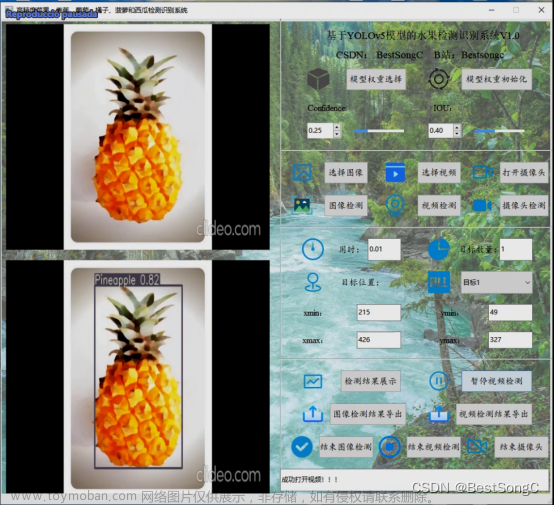

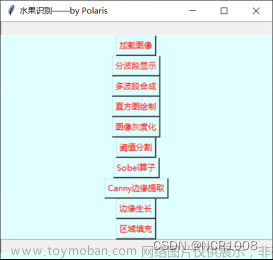

效果图如下:

代码演示和demo仓库看b站视频003期:

到此一游7758258的个人空间_哔哩哔哩_bilibili

代码展示:

数据集图片放置在data文件夹下,大家可以根据自己需要比如识别其他物体,只需要模仿data文件夹下的文件命名放入图片即可运行训练模型了。

运行01数据集文本生成制作.py可以将data文件夹下的图片保存成txt格式

运行02train.py可以将txt中记录的数据读取并训练模型

训练可以使用的卷积神经网络包括: efficientnet、Alexnet、DenseNet、DLA、GoogleNet、Mobilenet、ResNet、ResNext、ShuffleNet、Swin_transformer、VGG等。

训练结束后同时会生成评价指标图

运行03flask_server.py可以生成一个http接口连接小程序端和代码端,将小程序传来的图片调用本地训练好的模型识别之后再返回给小程序界面展示。

小程序端代码直接导入该文件夹即可。

相关知识科普:

CNN是卷积神经网络(Convolutional Neural Network)的缩写。它是一种前馈神经网络,特别适用于处理具有网格状结构的数据,例如图像、视频和声音等。CNN由多个卷积层、池化层和全连接层组成。

CNN的核心思想是通过卷积操作和池化操作来提取输入数据中的特征。卷积层使用卷积核对输入数据进行滑动窗口操作,以捕捉不同位置的局部特征。通过堆叠多个卷积层,网络可以学习到更加复杂的特征表示。池化层则用于降低数据维度,并保留最显著的特征。全连接层将特征映射到具体的输出类别上。

CNN在计算机视觉领域取得了巨大成功,广泛应用于图像分类、目标检测、人脸识别等任务。其优势在于能够自动学习具有平移不变性的特征,并且对于大规模数据集训练时具有较好的性能。

ALexNet是一种深度卷积神经网络(CNN),由Alex Krizhevsky等人于2012年提出。它是第一个在ImageNet Large-Scale Visual Recognition Challenge(ILSVRC)上取得显著优势的深度学习模型。

ALexNet采用了多层卷积层和全连接层的结构。相比于传统的浅层网络,ALexNet引入了更深的网络结构,包含5个卷积层和3个全连接层。同时,它还使用了非线性激活函数(ReLU)来增强模型的表达能力,并且引入了局部响应归一化(Local Response Normalization)层来提高泛化性能。

ALexNet的设计突破了之前的限制,通过大规模数据集的训练,成功地提升了图像分类任务的准确性。它在2012年的ILSVRC比赛中取得了远超其他模型的成绩,标志着深度学习方法在计算机视觉领域的崛起。

ALexNet的成功对深度学习的发展产生了重要影响,激发了更多研究者对深度神经网络的研究兴趣,并为后续的网络架构设计提供了启示。

GoogleNet,也称为Inception,是由Google团队在2014年提出的深度卷积神经网络(CNN)。它是为了参加ImageNet Large-Scale Visual Recognition Challenge(ILSVRC)而设计的。

GoogleNet采用了一种称为"Inception模块"的特殊结构,它允许网络在不同尺度上进行并行处理,以捕捉不同层次的特征。这种并行处理有助于减少参数量,并且在一定程度上缓解了过拟合问题。

与传统的网络相比,GoogleNet具有更深的结构,但通过合理的设计和使用1x1的卷积核进行降维操作,成功地减少了计算复杂度和参数数量。它在2014年的ILSVRC比赛中取得了显著的成果,并且提出的架构思想影响了后续深度学习模型的发展。

VGG是一种深度卷积神经网络(CNN),由牛津大学的研究团队在2014年提出。它被命名为VGG,以纪念论文作者之一Visual Geometry Group(视觉几何群)。

VGG网络的主要特点是其深度和简单性。相比于之前的模型,VGG采用了更多的卷积层和池化层,达到了16或19个卷积层的深度。同时,VGG中的卷积层都使用了较小的3x3卷积核,并且连续堆叠多次,以增加网络的非线性表达能力。

VGG网络的结构非常规整,逻辑清晰。它由多个卷积块组成,每个卷积块由连续的卷积层和一个池化层构成。最后的全连接层负责将提取到的特征映射到具体的输出类别上。

尽管VGG网络相对较深,但它在各种视觉任务上表现出色。VGG的设计思想启发了后续更深层次的神经网络架构,为深度学习的发展做出了重要贡献。

RESNET是一种深度残差网络(Residual Network),由微软研究院的研究团队在2015年提出。它是为了解决深度神经网络中的退化问题(degradation problem)而设计的。

在传统的深度神经网络中,随着网络层数的增加,模型的准确性通常会饱和或下降。这是因为较深层次的网络更难优化,容易出现梯度消失或梯度爆炸等问题。为了解决这个问题,RESNET引入了残差学习的思想。

RESNET通过跳过连接(skip connection)来构建残差块。跳过连接使得信息可以直接在网络中传递,绕过某些层,从而避免了信息丢失和退化。具体而言,每个残差块的输入通过一个恒等映射(identity mapping)与输出相加,然后再进入激活函数进行非线性变换。这种设计使得网络学习到残差的差异,从而更有效地优化模型。

RESNET的结构可以很容易地扩展到更深的层数,甚至达到数百层的深度。利用残差连接的设计,RESNET在ILSVRC比赛等各种视觉任务中取得了非常出色的结果,并且成为深度学习中非常重要的网络架构之一。

MobileNet是一种轻量级的深度卷积神经网络(CNN),由Google的研究团队于2017年提出。它的设计旨在实现在嵌入式设备和移动设备等资源受限的环境下进行高效的图像识别和分类。

MobileNet通过使用深度可分离卷积(depthwise separable convolution)来减少模型的计算量和参数数量。深度可分离卷积将标准卷积操作拆分为两个步骤:深度卷积(depthwise convolution)和逐点卷积(pointwise convolution)。深度卷积对每个输入通道单独执行卷积操作,而逐点卷积用于组合输出通道。这种方式可以大幅减少计算量,同时保持较好的模型准确性。

MobileNet还引入了宽度乘法器(width multiplier)和分辨率乘法器(resolution multiplier)的概念。宽度乘法器用于控制每一层的特征通道数,以进一步减少模型的计算负载。分辨率乘法器则用于调整输入图像的分辨率,从而在模型运行时降低计算需求。

MobileNet在保持相对较小模型大小和低计算成本的同时,仍能保持较高的识别准确率。这使得它在移动设备、嵌入式设备和实时应用等场景中受到广泛应用,例如图像分类、目标检测和人脸识别等任务。

ShuffleNet是一种轻量级的深度神经网络架构,由微软研究院的研究团队于2018年提出。它的设计目标是在计算资源受限的设备上实现高效的图像分类和目标检测。

ShuffleNet通过引入逐通道组卷积(channel shuffling)和分组卷积(group convolution)等操作来减少模型的计算复杂度和参数量。逐通道组卷积将输入特征图的通道重新排列,以增加不同通道之间的交互性。分组卷积将输入特征图分为多个组,并对每个组进行卷积操作,以减少计算量。

ShuffleNet的核心结构是Shuffle Unit,它包含了逐通道组卷积、分组卷积和特征重组(feature shuffle)等操作。Shuffle Unit的设计使得网络在同时保持较低计算负担的前提下,能够学习到更丰富的特征表示。

ShuffleNet具有较小的模型大小和低计算需求,适合在移动设备、嵌入式设备和实时应用等场景中部署。它在保持相对较高的准确率的同时,有效地优化了计算资源的利用。ShuffleNet已经在图像分类、目标检测和人脸识别等领域取得了显著的成果,并为轻量级深度学习模型的发展提供了重要思路。

EfficientNet是一种高效的深度卷积神经网络(CNN)架构,由Google Brain团队在2019年提出。它通过联合优化模型深度、宽度和分辨率来实现更好的性能和计算效率。

EfficientNet的设计思想是基于两个观察结果:首先,较大的模型往往具有更好的性能,但训练和推理成本也更高;其次,网络的深度、宽度和分辨率之间存在着相互依赖的关系。基于这些观察结果,EfficientNet使用了一个称为Compound Scaling的方法,同时增加了模型的深度、宽度和分辨率,以在资源受限的环境下取得更好的性能。

EfficientNet的核心结构是EfficientNet-B0到EfficientNet-B7,它们是由不同层数和通道数的组合构成的。通过使用复合缩放方法,每个EfficientNet模型都可以根据任务和计算资源进行调整,并在准确性和计算效率之间找到一个平衡点。

EfficientNet在许多计算机视觉任务上表现出色,包括图像分类、目标检测和语义分割等。它已经成为当今领先的深度学习模型之一,为在资源受限的设备上实现高效而准确的推理提供了重要的解决方案。

Swin Transformer是一种新兴的视觉感知模型,由香港中文大学的研究团队在2021年提出。它结合了Transformer架构和局部窗口注意力机制,通过分解嵌入式图像处理的长距离依赖性问题。

传统的Transformer模型在处理图像时会面临计算和内存开销的挑战,因为图像具有高分辨率和大量的位置信息。为了解决这个问题,Swin Transformer引入了一个细粒度的分割策略和基于窗口的局部注意力机制。

Swin Transformer首先将输入图像分成小的非重叠路径块(patch),然后在这些路径块上应用Transformer的自注意力机制。接下来,通过使用窗口化的局部注意力机制,模型能够同时处理局部和全局的信息。这种设计不仅降低了计算和内存开销,还有效地捕捉到了图像中不同尺度的特征。

Swin Transformer在多个计算机视觉任务上取得了令人印象深刻的结果,包括图像分类、目标检测和语义分割等。它兼具高效性和表现力,在减少计算复杂度的同时,保持了较好的准确性和泛化性能。Swin Transformer为图像处理领域带来了新的思路和突破,并吸引了广泛的关注和研究。

Flask 是一个使用 Python 编写的轻量级 Web 应用框架。它被广泛用于构建简单而强大的 Web 应用程序和 RESTful API。Flask 遵循了微型框架的理念,它提供了基本的功能和结构,同时保持灵活性和可扩展性,使开发人员能够根据自己的需求构建定制化的 Web 应用。

Flask 框架简洁而易于上手,它不依赖于任何特定的数据库或模板引擎,这意味着开发人员可以根据自己的喜好选择合适的组件。Flask 提供了许多功能,例如 URL 路由、模板渲染、表单处理、会话管理和请求处理等,这些功能使得构建 Web 应用变得更加简单和高效。

由于 Flask 的灵活性,它可以用于构建各种规模的应用,从简单的静态网页到复杂的大型 Web 应用程序都可以得到很好的支持。Flask 还具有丰富的扩展生态系统,开发人员可以利用这些扩展来增加功能,如身份验证、数据库访问、缓存管理等,从而进一步提升应用的能力和性能。

总之,Flask 是一个简单而灵活的 Python Web 应用框架,适用于快速构建高质量的 Web 应用和 API,同时提供了丰富的扩展功能,使开发人员能够根据自己的需求进行定制和扩展。

深度学习结合小程序可以带来许多好处,以下是其中几个主要的优点:

-

易于传播和使用:小程序具有轻量级、快速启动和无需下载安装的特点,用户可以直接通过扫描二维码或搜索即可使用。这种便捷性使得深度学习应用更容易传播和普及,提高了用户的参与度和使用率。

-

实时性和即时反馈:小程序提供实时更新的功能,用户可以随时获得最新的深度学习模型和算法。同时,小程序还能够提供即时反馈,例如实时展示处理结果或即时调整模型参数,使用户能够及时了解和调整深度学习应用的表现。

-

个性化和定制化:小程序可以根据用户的个人需求和喜好进行个性化定制,提供更加精准的推荐和服务。对于深度学习应用来说,这意味着可以根据用户的输入和反馈来自动调整模型的行为,提供更符合用户期望的结果。

-

多渠道覆盖:小程序可以在多个平台上运行,例如微信、支付宝等,覆盖了广泛的用户群体。这使得深度学习应用能够在不同的渠道上推广和应用,拓展了用户群体和市场范围。

-

低成本和高效率:相对于独立开发原生应用,使用小程序进行深度学习应用开发可以减少开发成本和时间。小程序平台提供了丰富的开发工具和组件,使开发人员能够更快速地构建和迭代应用,降低了开发的技术门槛和成本。文章来源:https://www.toymoban.com/news/detail-758121.html

总的来说,将深度学习与小程序结合,可以实现深度学习应用的快速传播、实时反馈、个性化定制、多渠道覆盖和低成本高效率开发,为用户提供更好的体验和服务。文章来源地址https://www.toymoban.com/news/detail-758121.html

到了这里,关于基于python深度学习的水果或其他物体识别小程序的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!