对于GPT-3.5,我们实际上并不能在OpenAI的服务器上直接训练它。OpenAI的模型通常是预训练好的,也就是说,它们已经在大量的语料上进行过训练,学习到了语言的基本规则和模式。

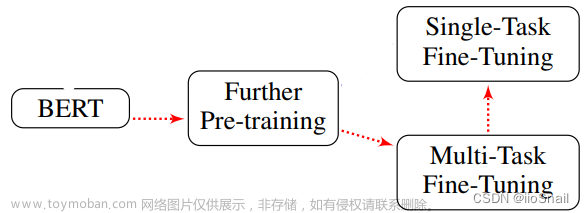

然而,OpenAI提供了一种叫做"微调"(fine-tuning)的方法,让我们可以在预训练好的模型基础上进行进一步的训练,使模型适应特定的任务或领域。这就好比,有人已经用一块木头雕出了一个大概的人形,然后你可以在这个基础上,继续雕刻出更加细致的五官、衣服的纹理等等。

微调的过程需要你拥有一些特定领域的数据,例如在你的例子中,就是和产品品类相关的专业洞察语料。你可以用这些数据来训练模型,让模型学习到这些数据中的特定规则和模式。微调后的模型,就可以更好地处理与这些数据相关的任务。

在具体实现上,你需要将你的数据整理成特定的格式,然后用OpenAI提供的API或者SDK,将数据发送给OpenAI的服务器,服务器会返回模型在你的数据上的输出结果。你可以根据这些结果来调整模型的参数,使模型的性能更好。这个过程可能需要反复进行多次,直到模型的性能达到你的需求为止。

"微调"(fine-tuning)是对GPT-3.5的微调吗?微调后的模型是只有我能用吗?别人也能用吗?还是能使用GPT-3.5的人就能用?

"微调"(fine-tuning)是对预训练模型如GPT-3.5进行的进一步训练,是的。微调的目标是使模型适应特定的任务或领域。例如,如果你微调一个模型来理解医学术语,那么这个模型将在处理医学相关的问题上表现得更好。

微调后的模型,理论上只有进行微调的人或者组织才有直接访问和使用的权限,除非他们选择分享或公开模型。如果你使用你自己的数据和资源进行了微调,那么微调后的模型属于你,别人不能直接使用,除非你授权他们使用。最终的使用权限取决于你与OpenAI之间的协议。文章来源:https://www.toymoban.com/news/detail-758244.html

至于其他使用GPT-3.5的人,他们只能使用OpenAI提供的基础GPT-3.5模型,不能直接使用你微调过的模型。他们需要自己收集数据,自己进行微调,才能得到适应他们特定任务或领域的模型。文章来源地址https://www.toymoban.com/news/detail-758244.html

到了这里,关于小白理解GPT的“微调“(fine-tuning)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!