摘要:本文将详细介绍 LainChain 的工作原理,以及如何通过结合 RAG(Retrieval-Aggregated Generation)技术来增强大型语言模型(如 GPT 和 ChatGPT 等)的性能。我们将探讨 COT、TOT、RAG 以及 LangChain 的概念,并通过一个简单的例子展示如何使用 HuggingGPT 工具来调用 OpenAI API。

一、引言

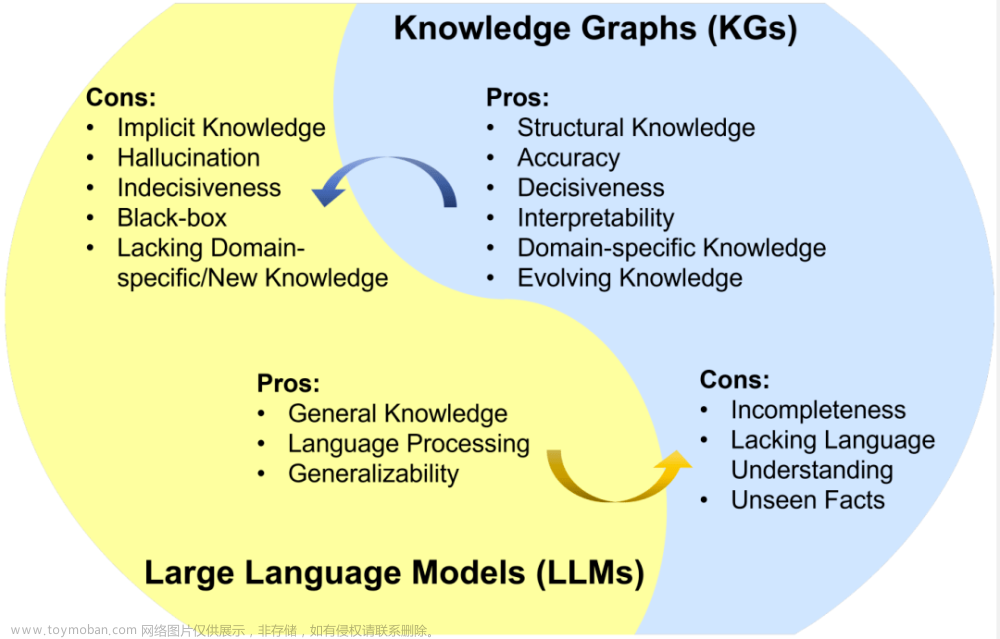

随着自然语言处理(NLP)领域的快速发展,大型语言模型如 GPT 和 ChatGPT 等已经成为了处理各种自然语言任务的强大工具。然而,这些模型在处理知识密集型任务时,仍然面临着一定的挑战。为了解决这些问题,研究者们提出了一种名为 LainChain 的方法,通过结合 RAG 技术来提升大型语言模型的能力。

二、背景知识

1. COT(Chain of Thought):这是一种解决复杂问题的方法,通过模拟人类思考的连续步骤来生成解答。在这种方法中,模型首先生成一系列解决问题的中间步骤或推理过程,然后再得出最终答案。

2. TOT(Tree of Thought):这是 COT 的一种扩展,不仅仅生成线性的思考链,而是创建一个更复杂的、树状的思考路径。这种方法使得模型能够更深入地探索不同的可能性,并在必要时回溯到之前的思考点。

3. RAG(Retrieval-Aggregated Generation):这是一种将信息检索组件和文本生成模型结合起来的方法。它通过接受输入并检索相关的支持文档,这些文档随后作为上下文,与输入的原始提示一起送给文本生成器,从而得到最终的输出。这种方法使得语言模型能够在不需要重新训练的情况下获取最新信息,并基于检索生成更可靠的输出。

三、LangChain 与 RAG

LangChain 是一种利用 RAG 技术来增强大型语言模型能力的方法。通过结合检索器和语言模型,LangChain 能够在回答问题时提供更加事实一致的答案,并给出知识来源。这种方法特别适用于知识密集型的任务,如回答复杂问题或进行事实验证。

调用openai的api

import openai

# 设置OpenAI API密钥

openai.api_key = '你的API密钥'

# 使用OpenAI API生成文本

response = openai.Completion.create(

model="text-davinci-002", # 指定模型

prompt="请写一篇关于机器学习的简短介绍:", # 设置提示语

max_tokens=100 # 指定生成的最大令牌数

)

# 打印响应结果

print(response.choices[0].text.strip())

function call

import openai

# 设置OpenAI API密钥

openai.api_key = '你的API密钥'

# 使用Function Call API进行特定操作

response = openai.Functions.call(

function="function_name", # 指定函数名称,例如"text-davinci-002"

inputs="你的输入内容" # 提供输入

)

# 打印响应结果

print(response["data"]["text"])

四、HuggingGPT 工具使用

HuggingGPT 是一个用于调用 OpenAI API 的工具,可以帮助用户更方便地使用 LainChain 和其他大型语言模型。通过以下简单的代码示例,我们可以看到如何使用 HuggingGPT

HuggingGPT文章来源:https://www.toymoban.com/news/detail-758917.html

- 理解用户自然语言指令,并计划分配任务

- 根据 Hugging Face 上的模型描述,选择合适的工具(Al模型)

- 调用 Al 模型执行子任务

- 整合结果并返回结果

五、结论

LainChain 通过结合 RAG 技术,有效地提升了大型语言模型在知识密集型任务中的表现。借助 HuggingGPT 工具,我们可以更方便地使用 LainChain 和其他大型语言模型来解决实际问题。在未来,我们期待看到更多类似的技术发展,以进一步提高自然语言处理领域的研究和应用水平。文章来源地址https://www.toymoban.com/news/detail-758917.html

到了这里,关于LainChain 原理解析:结合 RAG 技术提升大型语言模型能力的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!