一、引言

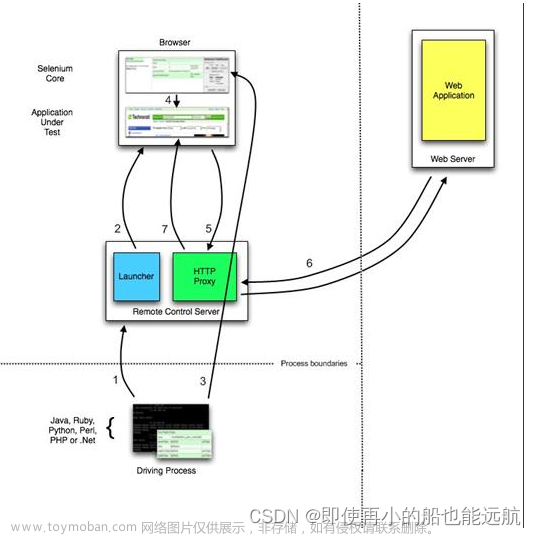

Selenium作为一个强大的自动化测试工具,其在网络爬虫领域也展现出了许多技术优势。首先,Selenium可以模拟浏览器行为,包括点击、填写表单、下拉等操作,使得它能够处理一些其他爬虫工具无法应对的情况,比如需要登录或者页面使用了大量JavaScript渲染的情况。其次,Selenium支持多种浏览器,包括Chrome、Firefox、Safari等,这使得开发者可以根据实际需求选择合适的浏览器进行爬取,提高了灵活性。此外,Selenium还可以执行JavaScript,这对于需要处理JavaScript渲染的网页来说至关重要。总之,Selenium在网络爬虫领域具有独特的优势,为开发者提供了强大的工具来应对各种复杂的网页情况,使得爬虫开发变得更加便捷和灵活。

二、环境准备

为了使用Selenium进行网络爬虫开发,首先需要安装Selenium库和浏览器驱动。以Python为例,可以通过pip安装Selenium库,然后下载对应浏览器的驱动程序,如Chrome浏览器需要下载ChromeDriver,将驱动程序放在系统路径下或指定路径下。接下来,通过编写Python代码,创建一个浏览器实例,打开目标网页,并模拟各种操作来实现爬取。以下是一个简单的Python示例代码:

python

Copy

pip install selenium

三、爬虫程序设计

1、导入必要的库和包

首先,我们需要导入Selenium库以及其他必要的库和包:

python

Copy

from selenium import webdriver

import time

2、启动浏览器驱动程序

接下来,我们需要启动浏览器驱动程序,这里以Chrome浏览器为例:

python

Copy

driver = webdriver.Chrome()

3、抓取网页内容

通过Selenium,开发者可以模拟浏览器行为,包括点击、填写表单、下拉等操作,从而获取网页上的各种信息。比如:

python

Copy

driver.get('https://www.zhihu.com')

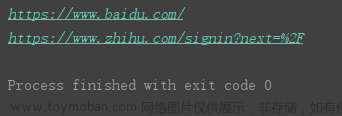

4. 提取特定信息,爬取知乎为案例

当使用Selenium库进行网络爬虫开发时,可以轻松地提取知乎网站上的特定信息,比如问题标题、问题描述等。以下是一个简单的Python示例代码,演示了如何使用Selenium库来实现这一功能。在这个示例中,我们首先创建了一个Chrome浏览器实例,并打开了知乎网站。然后,我们使用Selenium库提供的方法,通过CSS选择器定位到了问题标题和问题描述的元素,并将它们提取出来并打印出来。最后,我们关闭了浏览器。这个示例展示了如何利用Selenium库轻松地提取知乎网站上的特定信息,为进一步的数据处理和分析提供了便利。

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

# 设置代理信息

proxyHost = "www.16yun.cn"

proxyPort = "5445"

proxyUser = "16QMSOML"

proxyPass = "280651"

chrome_options = Options()

chrome_options.add_argument('--proxy-server=http://{}:{}'.format(proxyHost, proxyPort))

chrome_options.add_argument('--proxy-auth={}{}'.format(proxyUser, proxyPass))

# 创建一个带代理的Chrome浏览器实例

driver = webdriver.Chrome(options=chrome_options)

# 打开知乎网站

driver.get('https://www.zhihu.com')

# 提取问题标题

question_titles = driver.find_elements_by_css_selector('h2.ContentItem-title')

for title in question_titles:

print(title.text)

# 提取问题描述

question_descriptions = driver.find_elements_by_css_selector('div.ContentItem-meta')

for desc in question_descriptions:

print(desc.text)

# 关闭浏览器

driver.quit()

5. 数据存储和处理

使用Selenium进行数据爬取后,可以将抓取到的数据存储到文件或数据库中,也可以进行进一步的处理和分析。Selenium提供了丰富的方法来定位和提取网页元素,同时也可以配合其他库来实现数据的存储和处理,为后续的数据分析和利用提供了便利。文章来源:https://www.toymoban.com/news/detail-762074.html

四、优化和扩展

在实际应用中,可以根据需求对爬虫程序进行优化和扩展,优化方面,可以通过设置合理的页面加载等待时间、使用无头浏览器模式、采用并行化处理等方式提升爬取速度和稳定性。扩展方面,可以结合其他库如BeautifulSoup进行数据解析,使用代理IP和用户代理进行反反爬虫,实现自动化登录和交互操作等,从而扩展爬虫的功能和适用范围。通过不断优化和扩展Selenium爬虫,可以更好地适应各种复杂的网页情况,提高爬虫的效率和灵活性,为数据采集和分析提供更多可能性。文章来源地址https://www.toymoban.com/news/detail-762074.html

到了这里,关于Selenium库编写爬虫详细案例的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!