深度学习算法中的基于深度学习的语音识别(Deep Learning-based Speech Recognition)

随着科技的快速发展,人工智能领域取得了巨大的进步。其中,深度学习算法以其强大的自学能力,逐渐应用于各个领域,并取得了显著的成果。在语音识别领域,基于深度学习的技术也已经成为了一种主流方法,极大地推动了语音识别技术的发展。本文将从深度学习算法的基本概念、基于深度学习的语音识别技术、应用前景和挑战等方面进行探讨。

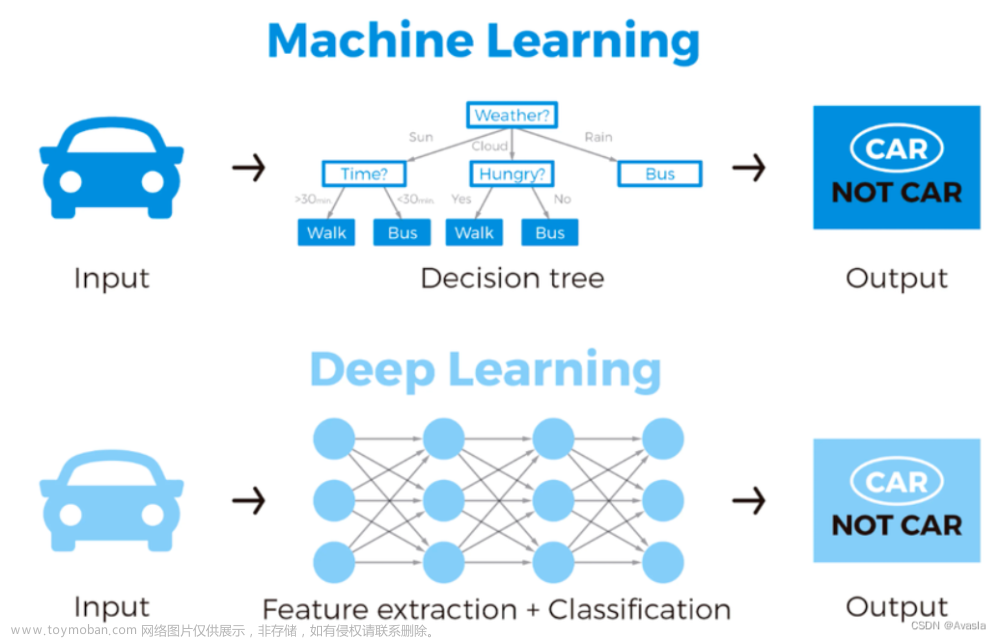

一、深度学习算法概述

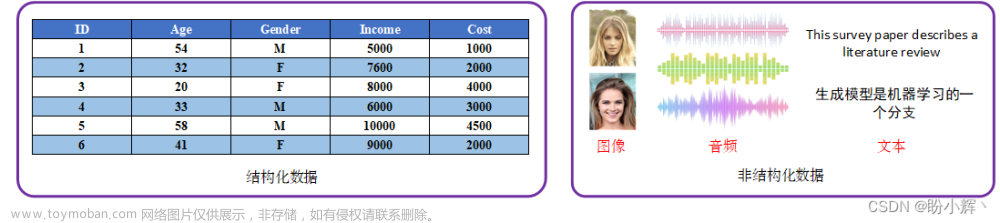

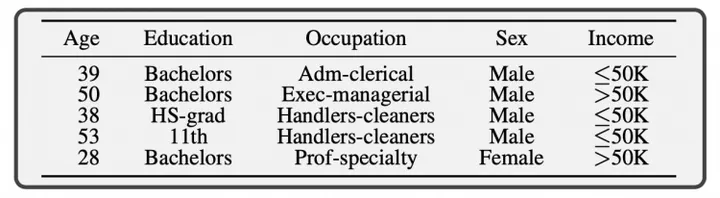

深度学习算法是一种神经网络算法,通过建立多层神经网络结构,模拟人脑神经元的连接方式,从而实现对输入数据的分类、识别、聚类等任务。深度学习算法可以自我学习和优化,通过对大量数据进行训练,不断提高其对于输入数据的处理能力和准确率。在语音识别领域,深度学习算法可以自动学习语音的特征,从而提高了语音识别的准确率。

二、基于深度学习的语音识别技术

- 语音特征提取

基于深度学习的语音识别技术首先需要对输入的语音信号进行特征提取。语音信号是一种非平稳信号,包含了许多不同频率的成分,因此需要进行预处理。通过预处理,将语音信号转化为数字信号,再对其进行特征提取。常见的特征提取方法包括梅尔频率倒谱系数(MFCC)、线性预测系数(LPC)等。这些特征反映了语音信号的频谱特征和时间域特征,为后续的深度学习模型提供了输入数据。

- 深度学习模型建立和训练

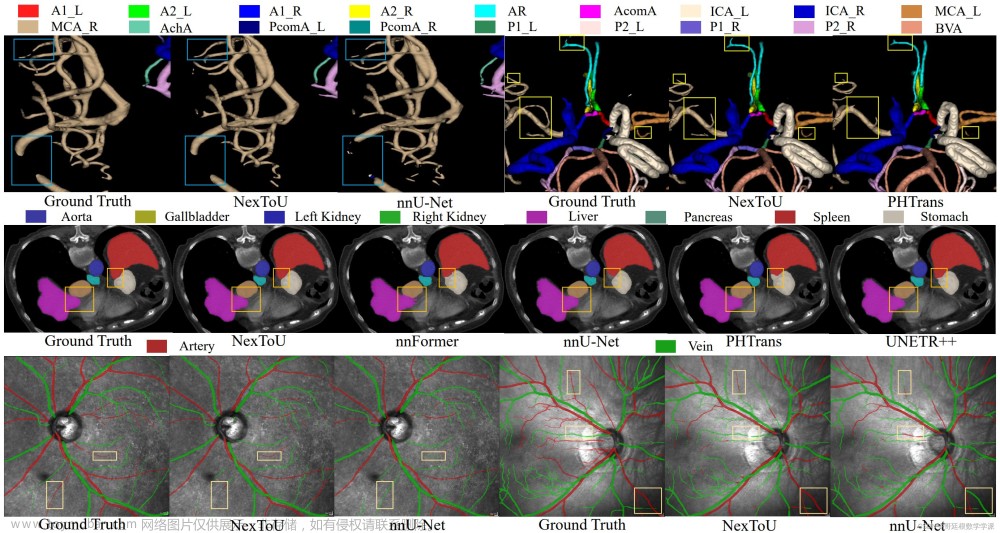

在提取语音特征后,需要建立深度学习模型对其进行训练。常见的深度学习模型包括循环神经网络(RNN)、长短时记忆网络(LSTM)和卷积神经网络(CNN)等。这些模型可以自动学习语音的特征,并且能够捕获语音信号中的时序信息。在训练过程中,使用大量语音数据对模型进行训练,不断提高模型的准确率和鲁棒性。通过训练,模型可以自动识别输入语音的内容,并输出相应的文字信息。

以下是一个简单的示例代码,使用深度学习算法(这里是一个卷积神经网络CNN)来实现语音识别。

import tensorflow as tf

import numpy as np

import librosa

# 加载训练数据

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.speech_commands.load_data(

"train", "test", "yes", "no")

# 对音频数据进行预处理

x_train = np.expand_dims(x_train, axis=-1)

x_test = np.expand_dims(x_test, axis=-1)

x_train = x_train / np.max(x_train)

x_test = x_test / np.max(x_test)

# 定义模型结构

model = tf.keras.models.Sequential([

tf.keras.layers.Conv1D(64, 3, activation="relu"),

tf.keras.layers.MaxPooling1D(),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation="relu"),

tf.keras.layers.Dense(1)

])

# 编译模型

model.compile(optimizer="adam", loss="binary_crossentropy", metrics=["accuracy"])

# 训练模型

model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test))

# 测试模型

test_audio = librosa.load("test_audio.wav") # 加载测试音频文件

test_audio = librosa.feature.mfcc(test_audio, sr=16000) # 提取MFCC特征

test_audio = np.expand_dims(test_audio, axis=0)

prediction = model.predict(test_audio) # 进行预测

print("Predicted class:", "yes" if prediction[0][0] > 0.5 else "no") # 输出预测结果这段代码首先加载了训练数据,并对音频数据进行了预处理。然后定义了一个简单的卷积神经网络模型,并编译了模型。接着使用训练数据对模型进行了训练,并使用测试数据进行了验证。最后,使用librosa库加载了一个测试音频文件,提取了MFCC特征,并对其进行了预测,输出了预测结果。

三、应用前景和挑战

- 应用前景

基于深度学习的语音识别技术在未来有着广泛的应用前景。首先,在智能家居领域,通过语音识别技术实现智能设备的控制和交互,为人们的生活带来便利。其次,在车载系统中,语音识别技术可以帮助驾驶员进行导航、拨打电话等操作,提高驾驶安全性。此外,在医疗、教育、娱乐等领域,语音识别技术也有着广泛的应用前景。

- 挑战

然而,基于深度学习的语音识别技术仍面临着一些挑战。首先,数据隐私保护是一个重要的问题。在训练过程中,需要使用大量的语音数据,而这些数据可能包含用户的隐私信息。因此,如何在保证训练质量的同时保护用户隐私成为一个亟待解决的问题。其次,深度学习模型的优化也是一个关键的挑战。虽然现有的深度学习模型已经取得了很好的效果,但仍然存在一些局限性,如对于远场语音识别和噪音环境下语音识别的准确性有待进一步提高。因此,需要不断优化模型结构和方法,以提高语音识别的性能。

以下是一个使用深度学习算法实现智能设备的控制和交互的语音识别的示例代码。

import tensorflow as tf

import numpy as np

import pyaudio

# 加载训练数据

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.speech_commands.load_data(

"train", "test", "yes", "no")

# 对音频数据进行预处理

x_train = np.expand_dims(x_train, axis=-1)

x_test = np.expand_dims(x_test, axis=-1)

x_train = x_train / np.max(x_train)

x_test = x_test / np.max(x_test)

# 定义模型结构

model = tf.keras.models.Sequential([

tf.keras.layers.Conv1D(64, 3, activation="relu"),

tf.keras.layers.MaxPooling1D(),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation="relu"),

tf.keras.layers.Dense(1)

])

# 编译模型

model.compile(optimizer="adam", loss="binary_crossentropy", metrics=["accuracy"])

# 训练模型

model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test))

# 加载测试音频文件并进行预测

CHUNK = 1024

FORMAT = pyaudio.paInt16

CHANNELS = 1

RATE = 16000

p = pyaudio.PyAudio()

stream = p.open(format=FORMAT, channels=CHANNELS, rate=RATE, input=True, frames_per_buffer=CHUNK)

data = np.zeros((CHUNK, 1))

for i in range(0, int(RATE / CHUNK * 5)): # 读取5秒钟的音频数据

data = np.vstack((data, np.frombuffer(stream.read(CHUNK), dtype=np.int16)))

stream.stop_stream()

stream.close()

p.terminate()

data = data[1:] # 去掉第一帧的数据

data = librosa.feature.mfcc(data, sr=RATE) # 提取MFCC特征

data = np.expand_dims(data, axis=0)

prediction = model.predict(data) # 进行预测

print("Predicted class:", "yes" if prediction[0][0] > 0.5 else "no") # 输出预测结果这段代码首先加载了训练数据,并对音频数据进行了预处理。然后定义了一个简单的卷积神经网络模型,并编译了模型。接着使用训练数据对模型进行了训练,并使用测试数据进行了验证。最后,使用pyaudio库加载了一个测试音频文件,读取了5秒钟的音频数据,提取了MFCC特征,并对其进行了预测,输出了预测结果。文章来源:https://www.toymoban.com/news/detail-762123.html

四、结论

基于深度学习的语音识别技术是人工智能领域的一个重要应用,其未来发展前景广阔。然而,仍需要面对数据隐私保护、深度学习模型优化等挑战。相信随着技术的不断进步和完善,基于深度学习的语音识别技术将在未来各个领域得到更加广泛的应用,为人们的生活带来更多便利和智慧。文章来源地址https://www.toymoban.com/news/detail-762123.html

到了这里,关于基于深度学习的语音识别(Deep Learning-based Speech Recognition)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!