1.爬虫三大库

因为爬虫需要用到这三个Requests,BeautifulSoup和Lxml库,所以先说一下我是如何安装,和使用的。

1.1 Requests库

1.1.1 requests库的安装

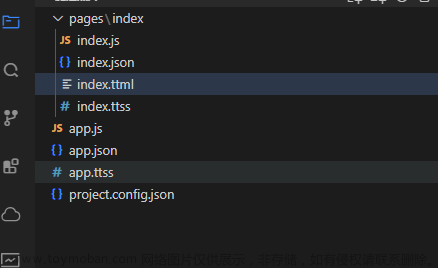

我是通过pycharm下载的第三方库requests

打开pycharm后点击File>>Settings>>Project>>Project>>Python Interpreter>>点击右方“+”号>>在搜索栏中输入requests>>下方的选项栏中出现requests后点击requests>>点击下方的Install Package

最后在这一栏中出现了requests就算安装完成了

1.1.2 Requests库的介绍和使用

1.Requests库的作用就是请求网站获取网页数据的。

2.reqests是一个很强大的第三方库,可以发送http请求和处理响应。常用的有:

1).发送get请求requests.get()

2).发送post请求,requests.post()

3).设置请求头,例如:User-Agent、Authorization等

import requests

# 使用get方法发送get请求,并获取响应内容

res = requests.get('http://bj.xiaozhu.com/')

# pycharm中返回结果为<Response [200]>,说明请求成功,若为404、400则请求网址失败

print(res)3.时候爬虫需要加入请求头来伪装成浏览器,以便更好的抓取数据。

所以为什么要加入请求头呢?

第一、先了解请求头是什么东西

请求头是在http请求中发送的一系列额外的信息,它们提供了关于请求本身、客户端环境 、以及请求上下文的信息。请求头在客户端与服务器之间的通信中起到了重要的作用。 我对请求头的理解:浏览器是人,服务器是保险柜,而请求头就是钥匙或者说是密码,没有相应的密码是无法打开保险柜的。 如果请求头不对,浏览器就会觉得你是不对密码不会给你响应(开门),你就拿不到信息(钱) 而其中我们最常用的请求头就是User-Agent:标识客户端的浏览器或应用程序类型,以便服务器能够针对不同客户端进行适配。 服务器可以使用 User-Agent 头来识别客户端的类型和版本,以便为不同的客户端提供适当的响应。

请求头的使用方法:

在网页页面右击,点击检查,选择Network,如果没有刷新一下。复制User-Agent的内容

import requests

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.5735.289 Safari/537.36'

}

res = requests.get('http://bj.xiaozhu.com/',headers=headers)

print(res.text)4.Requests库有时候也会出现问题,而requests库的错误和异常主要有:

ConnectionError:网络问题

HTTPError:HTTP请求返回不了成功的状态码

Timeout:请求超时

TooManyRedirects:请求超过了设定的最大重定向次数

当发现这些错误和异常而进行代码修改重新再来时,爬虫程序又开始重新运行了,爬取到的数据又会重新爬取一次, 这对于爬虫效率和质量来说都是不利的。 这时可以通过python的try来避免异常了

import requests

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.5735.289 Safari/537.36'

}

res = requests.get('http://bj.xiaozhu.com/',headers=headers)

try:

print(res.text)

except ConnectionError: # 出现ConnectionError时,会执行下面的操作

print('拒绝连接')1.2 BeautifulSoup库

1.2.1 bs4库的安装

Beautiful库和requests库的安装过程

有点不一样,因为 BeautifulSoup 库属于 bs4,或者说 bs4 是 BeautifulSoup 库的一个特定版本。所以我们在pycharm中下载bs4,同下载requests库一样只需要将搜索的requests换成bs4

1.2.2 BeautifulSoup库的介绍和使用

1. BeautifulSoup库的介绍

通过BeautifulSoup库可以很轻松地解析Requests库请求的网页, 并把网页源代码解析为Soup文档,以便过滤提取数据。

2. BeautifulSoup库的使用

import requests

from bs4 import BeautifulSoup

headers = {'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.5735.289 Safari/537.36'

}

res = requests.get('http://bj.xiaozhu.com/',headers = headers)

# BeautifulSoup是一个Python库,用于从HTML或XML文档中提取数据。

# res.text是一个包含HTML代码的字符串,'html.parser'是解析器的名称,它告诉BeautifulSoup使用HTML解析器来解析HTML代码。

soup = BeautifulSoup(res.text,'html.parser') # 对返回的结果进行解析

print(soup.prettify())

# soup.prettify 是 BeautifulSoup库中的一个方法,用于将解析后的HTML代码格式化为易于阅读的格式。

1.3 Lxml库

1.3.1lxml库的安装

同上一样。

1.3.2 lxml库的介绍

Lxml库是基于libxml12这一个XML解析库的Python封装。该模块使用C语言编写,解析速度比BeautifulSoup更快。

2.综合实例———爬取酷狗TOP500的数据

import requests

from bs4 import BeautifulSoup

import time

# 爬虫思路分析

# (1)爬取的内容为酷狗榜单中TOP500的音乐信息

# (2)网页版的酷狗不能手动翻页进行下一步的浏览,但通过观察第一页的URL:

# https://www.kugou.com/yy/rank/home/1-8888.html

# 这里尝试把数字1换成2再进行浏览,恰好返回的是第二页信息。

# 每页显示22首歌,所以总共需要23个URL

# (3)需要爬取的信息有

# 排名情况

# 歌手

# 歌曲名

# 歌曲时间

headers = {'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36'

}

def kugou_info(url):

res = requests.get(url, headers=headers)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'html.parser')

ranks = soup.select('#rankWrap > div.pc_temp_songlist > ul > li> span.pc_temp_num')

titles = soup.select('#rankWrap > div.pc_temp_songlist > ul > li > a')

times = soup.select('#rankWrap > div.pc_temp_songlist > ul > li > span.pc_temp_tips_r > span')

for rank, title, time in zip(ranks, titles, times):

data = {

'rank': rank.get_text().strip(), # strip()是python中的一个字符串方法,

# 用于去除字符串的两端空白字符(包括空格、换行符、制表符)。

# 他不会删除字符串中间的空白字符。

'singer': title.get_text().split('-')[1].strip(),

'song': title.get_text().split('-')[0].strip(),

'time': time.get_text().strip()

}

print(data)

if __name__ == '__main__':

urls = ['https://www.kugou.com/yy/rank/home/{}-8888.html'.format(str(i)) for i in range(1, 24)] # 列表推导式

for url in urls:

kugou_info(url)

time.sleep(1)

小拓展:

1.在python中,if_name_=="_main_":是一个特殊的条件语句,用于判断当前文件是否作为

主程序运行,它的主要作用有以下几点:

1.组织代码:使用这个语句可以将主程序的逻辑与被导入文件的逻辑分开。在主程序中,

你可以编写与程序整体运行相关的代码,而在被导入文件中,你可以编写模块级的函数和变量

2.避免重复执行:当一个文件被其他文件导入时,_name_的值为文件名,条件语句为假,

后续代码不会被执行。这可以避免在导入文件时执行不必要的代码,提高代码的效率和可读性。

3.方便测试:通过将测试代码放在if_name_=="_main_":块中,可以在单独运行主程序时进行测试,

而不会影响其他文件的导入和使用。

总的来说,if_name_=="_main_":语句提供了一种方便的方式来组织和测试代码,使你的代码更加

模块化和易于维护。

2.列表推导式

是一种简洁的方式来创新一个新的列表,其中包含满足某些条件的元素。它的语法类似于循环,但将

循环和条件合并到一行中。

列表推导式的基本结构是:[expression for item in iterable]

其中:

expression是一个计算机每个元素的表达式

item是从可迭代对象(如列表、元组等)中取出的每个元素

iterable是可迭代对象本身文章来源:https://www.toymoban.com/news/detail-762318.html

示例:

numbers=[1,2,3,4,5]

squares=[number ** 2 for number in numbers]

print(squares)

文章来源地址https://www.toymoban.com/news/detail-762318.html

到了这里,关于爬虫的第一个小程序的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!