目录

一、机器学习的定义

二、机器学习的发展历程

2.1 萌芽期(20世纪50年代-60年代)

2.2 符号主义时期(20世纪60年代-80年代)

2.3 统计学习时期(20世纪90年代-21世纪初)

2.4 深度学习时期(21世纪初至今)

三、主要算法

3.1 线性回归(Linear Regression)

3.2 K-均值聚类(K-Means Clustering)

3.3 决策树(Decision Tree)

3.4 支持向量机(Support Vector Machine, SVM)

3.5 神经网络(Neural Network)

3.6 条件随机场(Conditional Random Field,简称CRF)

3.7 Boosting算法

机器学习是人工智能(AI)的一个重要分支,它研究如何使计算机从数据中学习并做出预测或决策,而不需要明确编程。机器学习算法通过识别数据中的模式,自动改进其性能。以下是机器学习的定义及发展历程:

一、机器学习的定义

机器学习是一种科学方法,它通过训练算法,使计算机系统能够从数据中自动学习、识别模式并做出决策。这种方法利用统计学、概率论、优化理论等数学工具,结合算法设计和计算机编程,实现对数据的自动分析和预测。机器学习的主要目标是使计算机具有自我学习和自我改进的能力,以便更好地处理复杂任务。

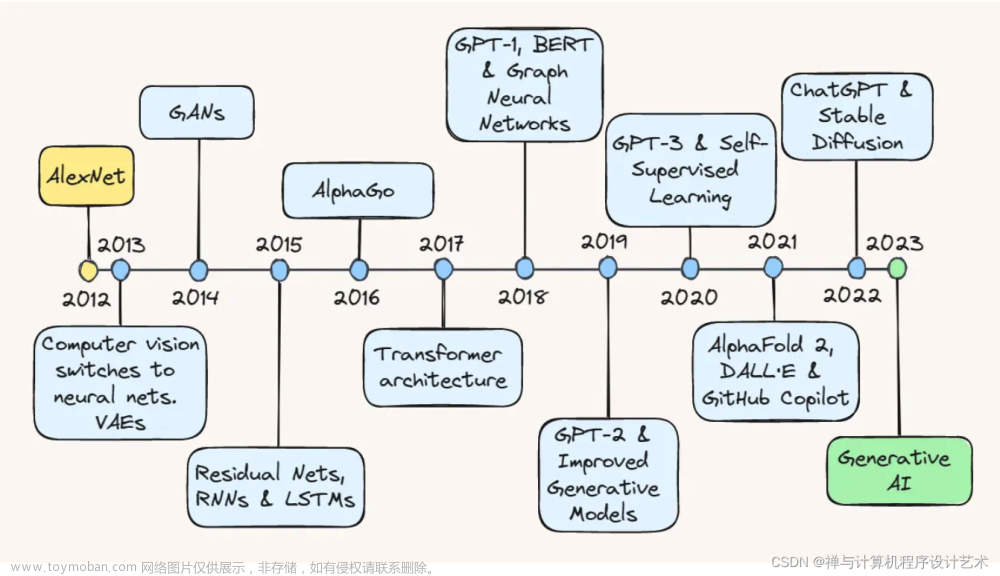

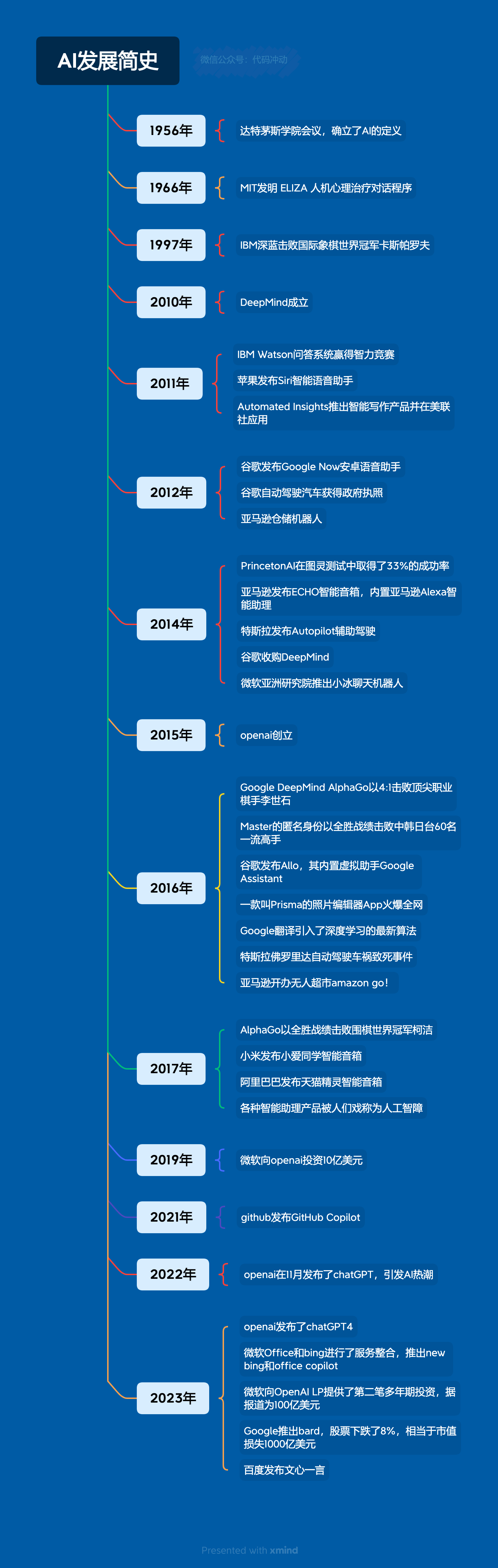

二、机器学习的发展历程

2.1 萌芽期(20世纪50年代-60年代)

机器学习的概念起源于20世纪50年代,当时科学家们开始研究如何让计算机具有学习能力。这一时期的代表人物有Arthur Samuel和Marvin Minsky。其中,Arthur Samuel于1959年定义了“机器学习”,并开发了一个西洋跳棋程序,该程序能够通过自我对弈来提高棋艺。

2.2 符号主义时期(20世纪60年代-80年代)

在这一时期,研究者们主要关注于符号学习方法,即使用符号逻辑和规则来表示知识。符号主义认为,人类的智能是基于符号操作的,因此计算机也应该通过符号操作来实现智能。然而,随着问题的复杂性增加,符号主义方法遇到了瓶颈。

2.3 统计学习时期(20世纪90年代-21世纪初)

90年代以后,随着计算机性能的飞速提升和数据的爆发式增长,统计学习方法开始崭露头角。统计学习方法以概率论和统计学为基础,通过对大量数据进行学习,自动提取数据的内在规律和模式。支持向量机(SVM)、决策树、随机森林等算法在这个时期得到了广泛应用。

2.4 深度学习时期(21世纪初至今)

深度学习是机器学习的一个分支,它使用深度神经网络来模拟人脑的学习过程。深度学习在图像识别、语音识别、自然语言处理等领域取得了突破性进展。随着计算机硬件性能的不断提升和大数据时代的到来,深度学习得以快速发展并在许多领域实现了超越人类的表现。

机器学习作为人工智能的核心技术之一,经历了从符号主义到统计学习再到深度学习的过程。随着技术的不断进步和应用领域的不断拓展,机器学习将在未来发挥更加重要的作用。

三、主要算法

以下是几个经典的机器学习算法及其定义或例子:

3.1 线性回归(Linear Regression)

线性回归是一种用于预测数值型数据的机器学习算法。它通过找到输入变量的特定权重,来描述输入变量与输出变量之间的线性关系。例如,可以使用线性回归来预测房价,其中输入变量可能包括房屋的面积、地理位置、建造年份等,输出变量为房价。

3.2 K-均值聚类(K-Means Clustering)

K-均值聚类是一种无监督学习算法,用于将输入数据划分为K个不同的类或簇。该算法通过迭代计算每个簇的中心点,并将数据点分配给最近的中心点,来不断优化簇的划分。例如,可以使用K-均值聚类来对顾客进行分群,以便针对不同群体制定不同的营销策略。

3.3 决策树(Decision Tree)

决策树是一种监督学习算法,用于分类和回归问题。它通过递归地将数据集划分为更小的子集,来构建一个树状结构。每个内部节点表示一个特征属性上的判断条件,每个分支代表一个可能的属性值,每个叶节点代表一个类别或数值。例如,可以使用决策树来诊断疾病,其中输入变量可能包括患者的症状、年龄、性别等,输出变量为疾病的类型。

3.4 支持向量机(Support Vector Machine, SVM)

支持向量机是一种监督学习算法,主要用于分类问题。它通过在高维空间中寻找一个超平面,使得不同类别的数据点能够最大限度地被分开。支持向量机在文本分类、图像识别等领域有广泛应用。例如,可以使用支持向量机来对新闻文章进行分类,其中输入变量可能包括文章的文本内容、作者、发布时间等,输出变量为文章的类别(如政治、经济、体育等)。

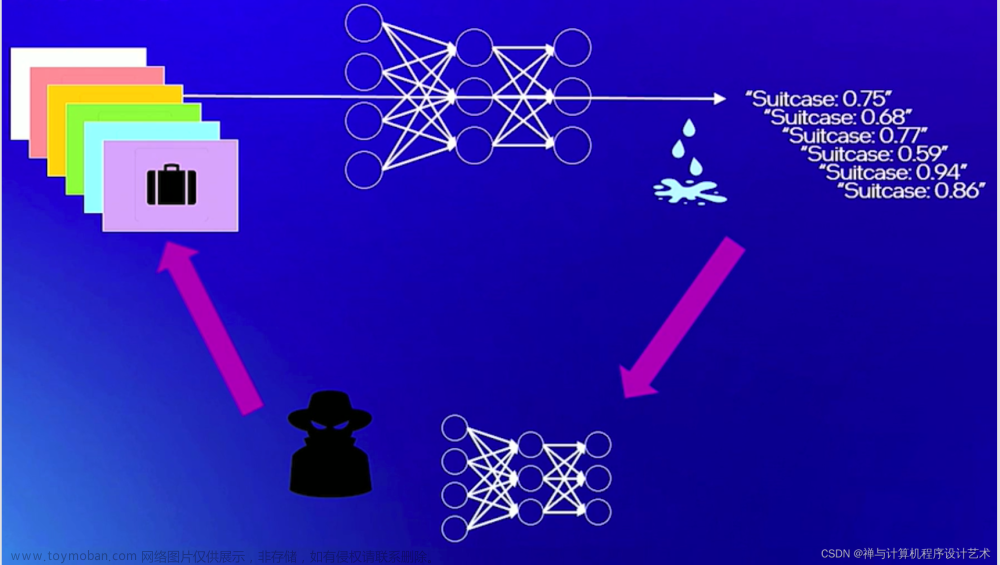

3.5 神经网络(Neural Network)

神经网络是一种模拟人脑神经元连接方式的机器学习算法。它通过构建一个由神经元组成的网络结构,来学习输入数据与输出数据之间的复杂关系。神经网络在图像识别、语音识别、自然语言处理等领域有广泛应用。例如,可以使用神经网络来进行图像识别,其中输入变量为图像的像素值,输出变量为图像所属的类别。

3.6 条件随机场(Conditional Random Field,简称CRF)

这是一种鉴别式概率模型,常用于标注或分析序列资料,如自然语言文字或是生物序列。

条件随机场是给定一组输入随机变量条件下另一组输出随机变量的条件概率分布模型,其特点是假设输出随机变量构成马尔科夫随机场。当用于标注问题时,一般讨论的都是线性链条件随机场,此时问题就变成了由输入序列对输出序列预测的判别模型,形式为对数线性模型,其学习方法通常是极大似然估计或正则化的极大似然估计。

3.7 Boosting算法

这是一种提高任意给定学习算法准确度的方法。它也是一种可以用来减小监督式学习中偏差的机器学习算法。

Boosting算法的思想起源于Valiant提出的PAC (Probably Approximately Correct)学习模型。Valiant和Kearns提出了弱学习和强学习的概念:识别错误率小于1/2,也即准确率仅比随机猜测略高的学习算法称为弱学习算法;识别准确率很高并能在多项式时间内完成的学习算法称为强学习算法。同时,Valiant和Kearns首次提出了PAC学习模型中弱学习算法和强学习算法的等价性问题,即任意给定仅比随机猜测略好的弱学习算法,是否可以将其提升为强学习算法?1990年,Schapire最先构造出一种多项式级的算法,对该问题做了肯定的证明,这就是最初的Boosting算法。

Boosting是一种框架算法,主要是通过对样本集的操作获得样本子集,然后用弱分类算法在样本子集上训练生成一系列的基分类器。它是一种框架算法,可以与其他算法结合使用,例如AdaBoost(Adaptive Boosting)算法,这是一种效率很高的Boosting算法。文章来源:https://www.toymoban.com/news/detail-763381.html

(请关注,下期我们讨论自然语言处理。)文章来源地址https://www.toymoban.com/news/detail-763381.html

到了这里,关于【AI】人工智能复兴的推进器之机器学习的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!