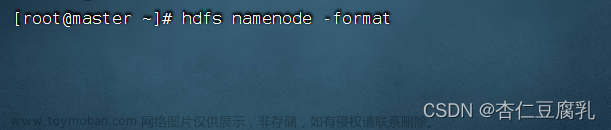

执行start-dfs.sh后,datenode没有启动,很大一部分原因是因为在第一次格式化dfs后又重新执行了格式化命令(hdfs namenode -format),这时主节点namenode的clusterID会重新生成,而从节点datanode的clusterID 保持不变。

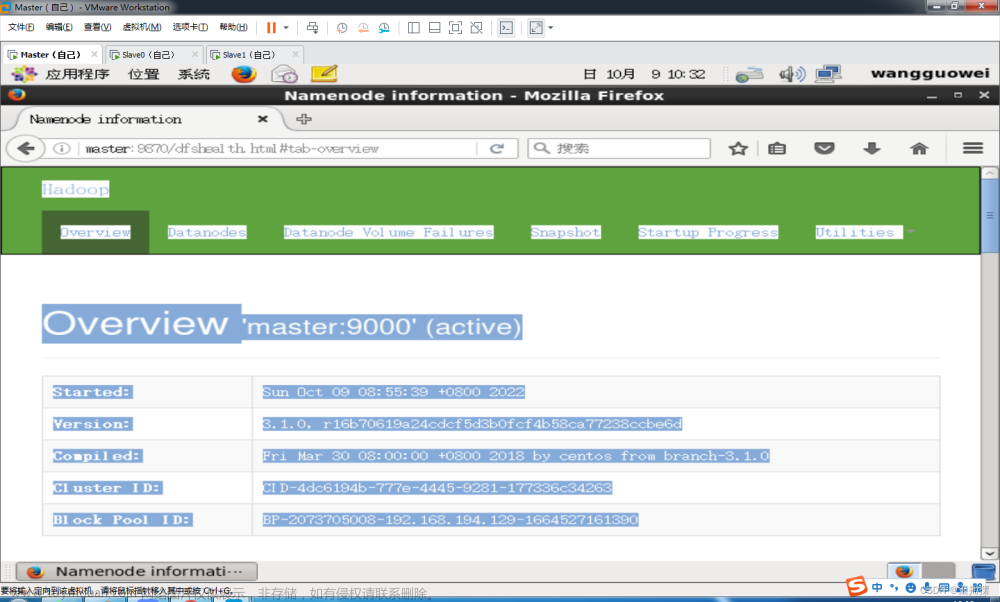

在主节点也就是namenode那个节点上的hdfs-site.xml文件下找到这两个文件路径

打开name目录中current下面的VERSION文件,然后用这个clusterID替换掉datanode节点上的data/current/VERSION里的clusterID

文章来源:https://www.toymoban.com/news/detail-764588.html

文章来源:https://www.toymoban.com/news/detail-764588.html

参考http://t.csdnimg.cn/Gk4cg文章来源地址https://www.toymoban.com/news/detail-764588.html

到了这里,关于【Hadoop】执行start-dfs.sh启动hadoop集群时,datenode没有启动怎么办的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!