论文:《Learning Deep Network for Detecting 3D Object Keypoints and 6D Poses》

摘要:

-

解决问题:标注困难且没有CAD模型。

-

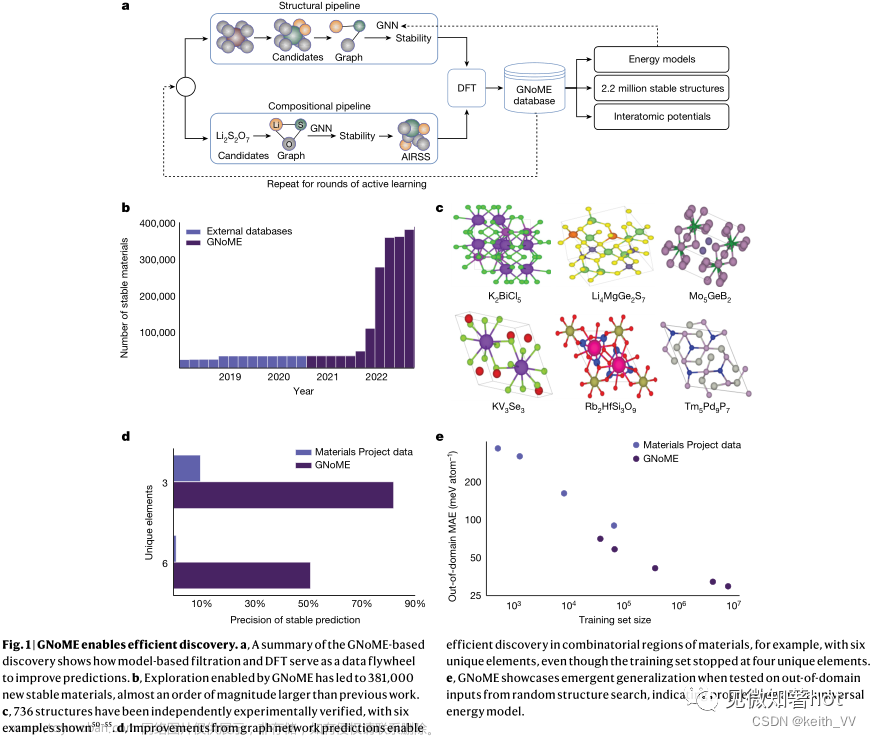

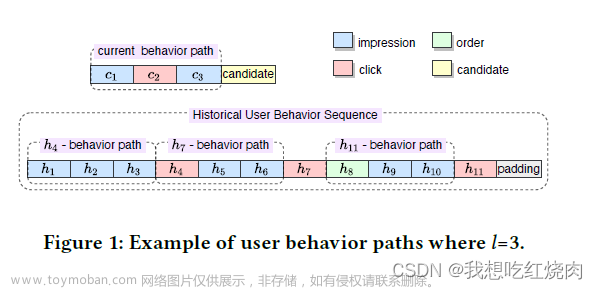

开发了一种基于关键点的6D对象姿态检测方法,Object Keypoint based POSe Estimation (OK-POSE)。通过使用大量具有多视点之间的相对变换信息的图像对(相对变换信息可以很容易地从任何廉价的双目相机或大多数智能手机设备中获得,从而大大降低了标签成本)来训练网络,并在训练中应用了多个新的损失函数,使模型可以自动检测几何和视觉一致的对象的3D关键点。在推理的时候,将检测对象的3D关键点和参考图像的3D关键点建立对应关系,使用Kabsch算法计算其相对位姿,在已知参考图像物体位姿的情况下,便可得到检测对象的6D位姿。

具体来说,OK-POSE学习自动检测具有不变性、独特性和局部性的物体的3D关键点,以估计真实RGB图像中的6D物体姿态。与以前的6D姿态检测方法不同,我们的方法从图像对之间的相对变换中学习3D关键点,而不是从明确的3D标记信息或3D CAD模型中学习。考虑到真实图像通常包含多个对象,OK-POSE执行两项任务,即对象检测和关键点检测。

- 对于关键点检测任务,其分支由一系列精心设计的关键点损失函数训练,包括显著性损失、深度回归损失、跨视图一致性损失、分离损失和转换恢复损失。这些损失函数的总体目标是寻找最佳的3D关键点,这些关键点在不同的视点上一致地位于对象的相同部分,而无需关键点注释,即使它们是不可见的。

- 对于对象检测任务,我们设计了类似于Faster R-CNN的模型分支(称为对象分支)和损失函数。对象分支为检测到的关键点提供类别指示。

在推理阶段,我们的网络将RGB图像作为输入,并检测输入图像中目标对象的类别、2D位置和3D关键点,通过该图像,可以从每个不同对象的参考图像中的相应关键点几何推断6D对象姿态。参考图像以物体的姿态信息为基准进行标注,为输入图像设置参考坐标系。由于我们的网络可以预测图像中的所有3D关键点,包括不可见的关键点,因此在推理阶段中只有一个参考图像就足够了。

-

效果:与依赖对象的3D CAD模型或大量3D标记的方法相比,OK-POSE实现了可接受的性能。这些结果表明,当没有三维CAD模型或大量三维标注时,我们的方法可以作为一种合适的替代方法。(其实效果较差。)

网络架构:

- 对于主干网络,使用ResNet101和特征金字塔网络FPN来提取图像特征,通过RPN提取感兴趣区域ROI输入到后面两个分支中。

- 对于关键点分支,设计了一个网络,可以预测特征图中每个像素点为第i个关键点的概率,除此之外,还会预测每个点的深度。

- 对于物体分支,会检测每个物体的类别的bbox。

怎么从相对变换中学习3D关键点?

给出了一个物体的图像对(I,I′),其视点之间具有已知的相对变换矩阵T。我们的目标是预测两幅图像中具有几何和视觉一致性的两个最佳3D关键点列表。几何一致性意味着3D关键点应保持对象的旋转不变性、位置不变性和比例不变性。视觉一致性意味着匹配关键点的位置应具有相似的视觉外观。为此,我们考虑以下标准来学习正确的三维关键点:

-

一种跨视图一致性损失(cross-view consistency loss),用于测量相对变换下两个关键点列表之间的差异。

在这种损失函数和具有广泛变换的训练对的帮助下,学习到的3D关键点将稳定地落在对象的一致位置上,即使该位置在图像中是不可见的。这使得每个对象只有一个参考图像时能够进行稳健的推理。

-

一种深度回归损失(depth regression loss),使预测的关键点深度和根据对极几何(epipolar geometry,描述了两张图片的视觉几何关系)的相对变换计算的深度之间的距离最小化。

-

一种独特性损失(distinctiveness loss),它鼓励关键点出现在视觉显著区域,并具有显著性、易于检测和多样性的特性。(较复杂,建议看原文3.2节)

-

一种分离损失(separation loss),鼓励一个图像中关键点之间的距离大于参数δ,避免它们距离太近甚至重叠。换言之,如果关键点在3D空间中比δ更接近,我们会惩罚它们:

-

一种变换恢复损失(transformation recovery loss),它使用下式惩罚从两个关键点列表中恢复的变换[R′|t′]与真实的[R|t]之间的差别:文章来源:https://www.toymoban.com/news/detail-765524.html

该函数测量估计的相对旋转R′和真实旋转R之间的角距离,以及估计的平移t′和真实平移t之间的欧几里得距离。可以通过Kabsch算法(《A solution for the best rotation to relate two sets of vectors》)从两个预测关键点列表中计算R′和t′。文章来源地址https://www.toymoban.com/news/detail-765524.html

到了这里,关于论文解读《Learning Deep Network for Detecting 3D Object Keypoints and 6D Poses》 无需位姿标注的model-free 6D位姿估计的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!