🐮博主syst1m 带你 acquire knowledge!

✨博客首页——syst1m的博客💘

😘《CTF专栏》超级详细的解析,宝宝级教学让你从蹒跚学步到健步如飞🙈

😎《大数据专栏》大数据从0到秃头👽,从分析到决策,无所不能❕

🔥 《python面向对象(人狗大战)》突破百万的阅读量,上过各种各样的官方大型专栏,python面向对象必学之一!🐽

🎉希望本文能够给读者带来帮助,更好地理解这个问题或解决你的困惑🐾

HDFS NFS Gateway简介:

HDFS NFS Gateway是Hadoop Distributed File System(HDFS)中的一个组件,它允许客户端通过NFS(Network File System,网络文件系统)与HDFS进行交互。具体来说,HDFS NFS Gateway允许客户端像访问本地文件系统一样挂载和访问HDFS文件系统,支持上传,下载,删除,追加内容,有点类似于windows的文件共享。下面正文即开始讲解该组件的功能使用,以及配置

正文

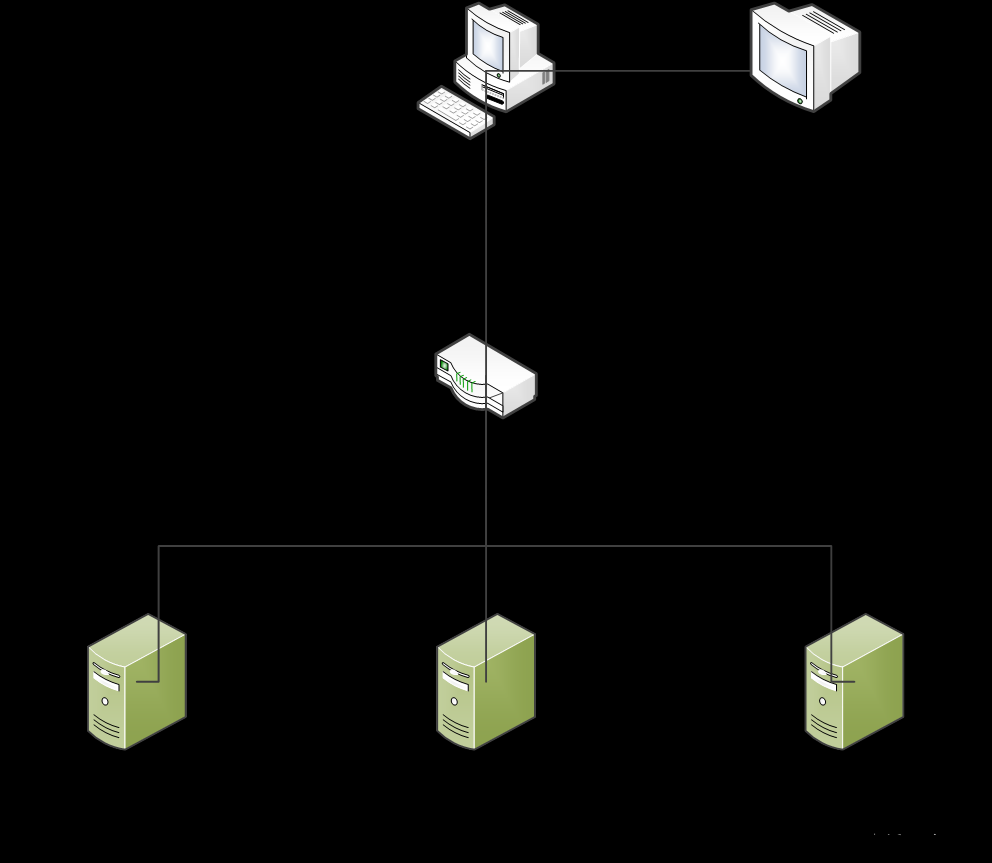

以图片的方式描述NFS,让读者能更好的理解!

如下图,将HDFS挂载为windows文件管理器的网络位置

hadoop内容

1,配置NFS

配置HDFS需要配置如下内容

core-site.xml,新增配置项以及hdfs-site.xml,新增配置项

开启protmap,nfs3两个进程

在root1进行如下操作

1.1 在core-site.xml内新增如下两项

1.2 在hdfs-site.xml中新增如下项

nfs.suerpser:NFS操作HDFS系统,所使用的超级用户(hdfs的启动用户为超级用户)

nfs.dump.dir:NFS接受数据上传时使用的临时目录

nfs.exports.allowed.hosts:NFS允许连接的客户端IP和权限,rw表示读写,ip整体活部分可以*代替

上面写的192.168.88.1以rw连接(这个是电脑虚拟网卡VMnet8的IP,与虚拟机通讯就走这个网卡)

2,启用NFS功能

2.1 将配置好的core-site.xml和hdfs-site.xml分发到root2和root3

2.2 重启Hadoop HDFS集群(先stop-dfs.sh然后start-dfs.sh)

2.3 停止系统的NFS相关进程

systemctl stop nfs;systemctl disable nfs 关闭系统nfs并关闭其开机自启

2.4 启动portmap(HDFS自带的rpcbind功能)(必须root执行):hdfs --daemon start portmap

2.5 启动nfs(HDFS自带的nfs功能)(必须以hadoop用户执行):hdfs --daemon start nfs3

2.6 最后启动HDFS集群

检查NFS是否正常

以下操作在root2或root3执行(因为root1卸载了rpcbind,缺少了必要的2个命令)

执行:rpcinfo -p root1,正常输出如下

执行showmount -e root1

可以看到 / 192.168.88.1

这样就是表示正常了

3,在windows挂载HDFS文件系统(windows必须是专业版)

3.1 开启windows的NFS功能

3.2 在windows挂载HDFS文件系统并访问

在windows命令提示符cmd输入net use X:\192.168.88.101!

文章来源:https://www.toymoban.com/news/detail-765569.html

文章来源:https://www.toymoban.com/news/detail-765569.html

总结

到这里这个HDSF NFS就完全部署完成了,希望该文章能有有效的帮助到大家,如有不懂的,可留言,来帮你解决剩下的疑难问题文章来源地址https://www.toymoban.com/news/detail-765569.html

到了这里,关于HDFS NFS Gateway(环境配置,超级详细!!)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[数据存储]HDFS的简介、初始化配置与运行](https://imgs.yssmx.com/Uploads/2024/02/533249-1.png)