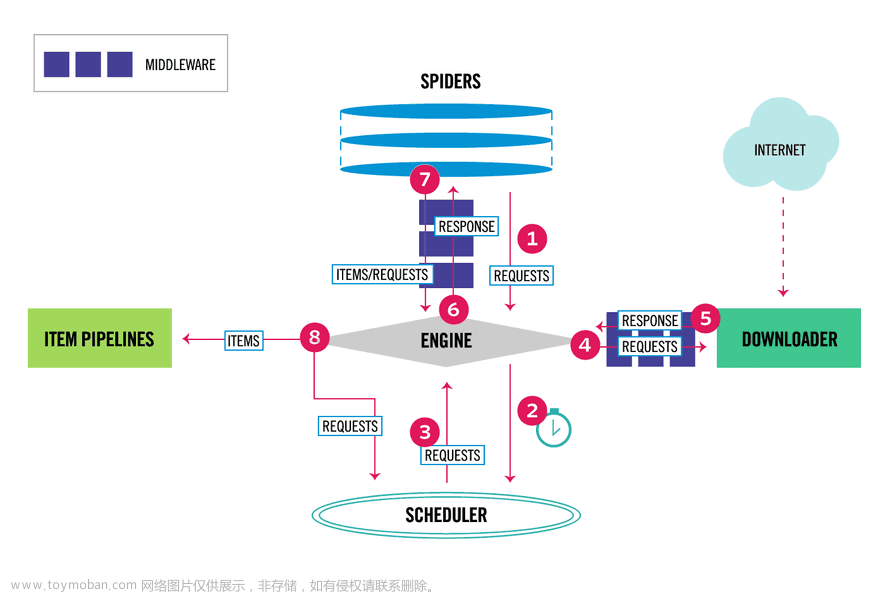

在网络爬虫开发中,利用Selenium进行无界面浏览器自动化是一种常见且强大的技术。无界面浏览器可以模拟真实用户的行为,解决动态加载页面和JavaScript渲染的问题,给爬虫带来了更大的便利。本文将为您介绍如何利用Selenium进行无界面浏览器自动化爬虫开发的步骤,并分享实用的代码示例,帮助您快速掌握这一技巧,提高爬虫开发的效率。

第一部分:安装和配置

1. 安装Selenium库:

- 在开始之前,我们需要安装Selenium库:

```python

pip install selenium

```文章来源:https://www.toymoban.com/news/detail-765581.html

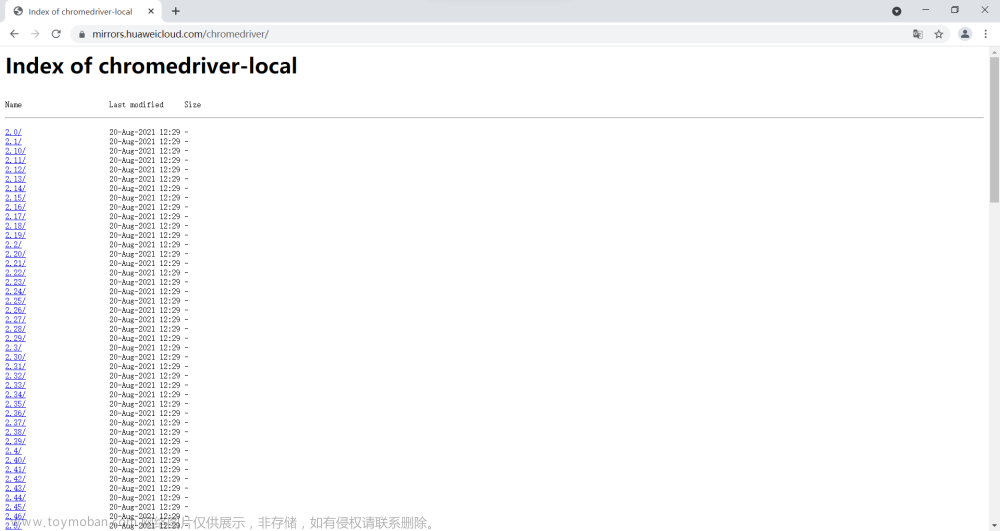

2. 下载并配置浏览器驱动:

- Selenium需要与浏览器驱动程序配合使用,不同的浏览器需要对应不同的驱动。这里以Chrome浏览器为例:

```python

from selenium import webdriver

from webdriver_manager.chrome import ChromeDriverManager

# 创建Chrome浏览器驱动

driver = webdriver.Chrome(ChromeDriverManager().install())

```

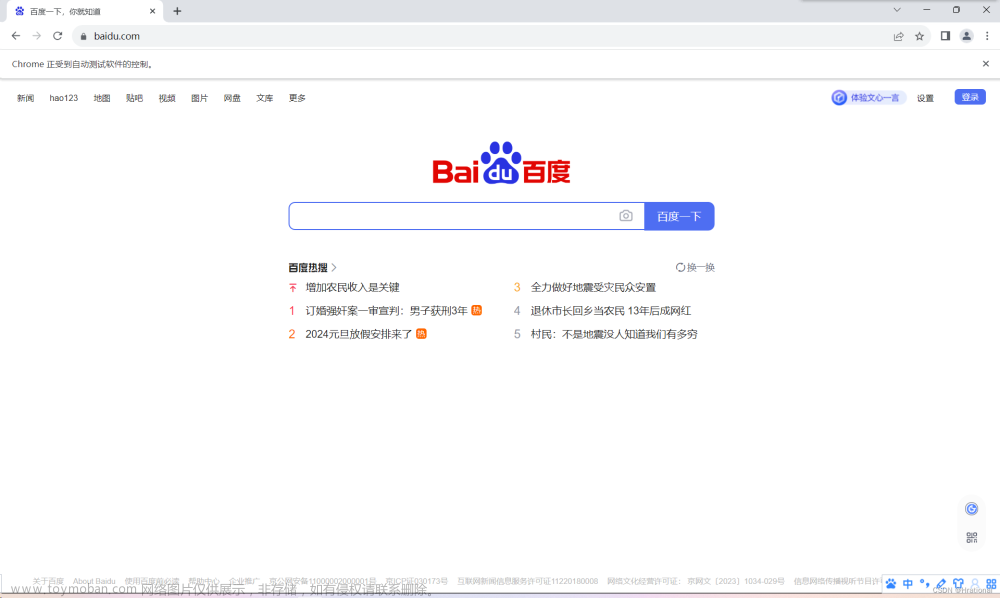

第二部分:使用Selenium进行无界面浏览器自动化操作

1. 打开网页:

```python

# 打开指定网页

driver.get("https://www.example.com")

```

2. 查找元素:

- 可以通过各种定位方式查找页面中的元素,例如按照标签名、class名称、id名称等:

```python

# 按照标签名查找元素

element = driver.find_element_by_tag_name("h1")

# 按照class名称查找元素

element = driver.find_element_by_class_name("content")

# 按照id名称查找元素

element = driver.find_element_by_id("username")

```

3. 操作元素:

- 对找到的元素进行点击、输入文本等操作:

```python

# 点击元素

element.click()

# 输入文本

element.send_keys("Hello, World!")

```

4. 获取网页内容:

- 可以获取整个网页的源代码或者某个元素的文本内容:

```python

# 获取整个网页的源代码

html_content = driver.page_source

# 获取某个元素的文本内容

element = driver.find_element_by_tag_name("h1")

text = element.text

```

第三部分:爬虫开发案例

```python

from selenium import webdriver

from webdriver_manager.chrome import ChromeDriverManager

# 创建Chrome浏览器驱动

driver = webdriver.Chrome(ChromeDriverManager().install())

# 打开指定网页

driver.get("https://www.example.com")

# 按照标签名查找元素

element = driver.find_element_by_tag_name("h1")

# 获取元素的文本内容

text = element.text

print("网页标题:", text)

# 关闭浏览器驱动

driver.quit()

```

通过安装Selenium库,配置相应的浏览器驱动,以及使用常用的方法实现对网页的操作和数据提取,我们可以快速开发出高效且稳定的爬虫系统。希望本文对您在无界面浏览器自动化爬虫开发方面的学习和实践有所帮助,祝您在爬虫开发的道路上取得成功!文章来源地址https://www.toymoban.com/news/detail-765581.html

到了这里,关于Selenium进行无界面爬虫开发的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!